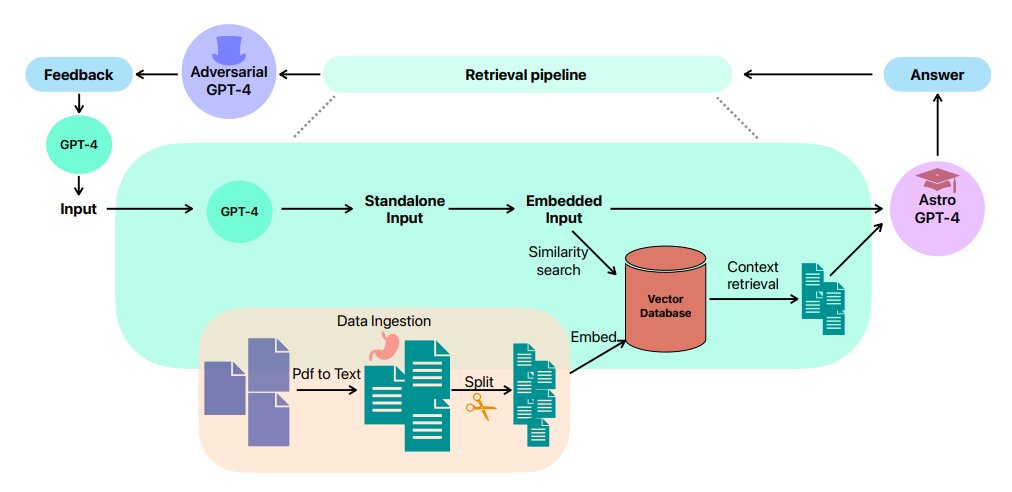

El flujo de trabajo de avisos adversarios en contexto utilizando el modelo GPT-4 de OpenAI. El procedimiento comienza con el preprocesamiento y la incrustación de los documentos de Astronomía Galáctica. Se realiza una búsqueda de similitud en la consulta incrustada y se recuperan fragmentos de documentos relevantes. Se realiza una compresión contextual adicional para eliminar información irrelevante de los fragmentos. Estos textos comprimidos sirven como entrada a una instancia GPT-4, que genera una idea. Luego, esta idea es criticada por un segundo modelo GPT-4, y la retroalimentación es moderada por un tercer modelo GPT-4. Crédito: arXiv (2023). DOI: 10.48550/arxiv.2306.11648

Casi en cualquier lugar al que vaya en Internet, parece casi imposible escapar de los artículos sobre IA. Incluso aquí en UT, hemos publicado varios. Por lo general, se enfocan en cómo un grupo de investigación específico aprovechó la tecnología para dar sentido a una gran cantidad de datos. Pero ese tipo de reconocimiento de patrones no es todo para lo que sirve la IA. De hecho, se está volviendo bastante capaz de pensar en abstracto. Y un lugar donde el pensamiento abstracto puede ser útil es en el desarrollo de nuevas teorías científicas. Con ese pensamiento en mente, un equipo de investigadores de la ESA, Columbia y la Universidad Nacional de Australia (ANU) utilizó una IA para generar hipótesis científicas en astronomía.

En concreto, lo hicieron en el subcampo de la astronomía galáctica, que se especializa en la investigación en torno a la formación y física de las galaxias. Un artículo publicado recientemente sobre la arXiv El servidor de preimpresión menciona que seleccionaron este subcampo debido a su «naturaleza integradora», que requiere «conocimiento de diversos subcampos».

Eso suena exactamente como en lo que la IA ya es buena. Pero un modelo de lenguaje grande estándar (LLM) como los que se han vuelto más familiares recientemente (ChatGPT, Bard, etc.) no tendría suficiente conocimiento del tema para desarrollar hipótesis razonables en ese campo. Incluso podría ser víctima de las «alucinaciones» que algunos investigadores (y periodistas) advierten que son una de las desventajas de interactuar con los modelos.

Para evitar ese problema, los investigadores, dirigidos por Ioana Ciucă y Yuan-Sen Ting de ANU, utilizaron un código conocido como interfaz de programación de aplicaciones (API), que estaba escrito en Python, conocido como Langchain. Esta API permite a los usuarios más avanzados manipular LLM como GPT-4, que sirve como base más reciente para ChatGPT. En el caso de los investigadores, cargaron más de 1000 artículos científicos relacionados con la astronomía galáctica en GPT-4 después de descargarlos del Sistema de Datos de Astrofísica de la NASA.

Uno de los experimentos de los investigadores fue probar cómo la cantidad de artículos a los que tenía acceso el modelo afectaba las hipótesis resultantes. Notaron una diferencia significativa entre las hipótesis sugeridas que desarrolló teniendo acceso a solo diez artículos frente a tener acceso a los mil completos.

Pero, ¿cómo juzgaron la validez de las propias hipótesis? Hicieron lo que cualquier científico que se precie haría y reclutaron expertos en el campo. Dos de ellos, para ser precisos. Y les pidieron que solo las hipótesis basadas en la originalidad del pensamiento, la viabilidad de probar las hipótesis y la precisión científica de su base. Los expertos descubrieron que, incluso con un conjunto de datos limitado de solo diez artículos, las hipótesis sugeridas por Astro-GPT, como llamaron a su modelo, se calificaron solo un poco más bajo que un doctorado competente. alumno. Con acceso a los 1.000 artículos completos, Astro-GPT obtuvo una puntuación de «casi nivel de experto».

Un factor crítico en la determinación de las hipótesis finales que se presentaron a los expertos fue que las hipótesis se refinaron utilizando «indicaciones adversarias». Si bien esto suena agresivo, simplemente significa que, además del programa que estaba desarrollando las hipótesis, otro programa fue entrenado en el mismo conjunto de datos y luego proporcionó retroalimentación al primer programa sobre sus hipótesis, lo que obligó al programa original a mejorar su falacias lógicas y, en general, crean ideas sustancialmente mejores.

Incluso con los comentarios de los adversarios, no hay razón para el doctorado en astronomía. los estudiantes dejen de proponer sus propias ideas únicas en su campo. Sin embargo, este estudio apunta a una capacidad infrautilizada de estos LLM. A medida que se adoptan más ampliamente, los científicos y los legos pueden aprovecharlos cada vez más para generar nuevas y mejores ideas para probar.

Más información:

Ioana Ciucă et al, Aprovechando el poder de las incitaciones adversarias y los modelos de lenguaje extenso para la generación de hipótesis robustas en astronomía, arXiv (2023). DOI: 10.48550/arxiv.2306.11648

Información del diario:

arXiv

Proporcionado por Universe Today

Citación: AI podría ayudar a los astrónomos a generar hipótesis rápidamente (28 de junio de 2023) recuperado el 28 de junio de 2023 de https://phys.org/news/2023-06-ai-astronomers-rapidly-generate.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.