Newswise: los científicos del Laboratorio Nacional Oak Ridge del Departamento de Energía están liderando un nuevo proyecto para garantizar que las supercomputadoras más rápidas puedan mantenerse al día con los grandes datos de la investigación de física de alta energía.

«Para el big data científico, este es uno de los mayores desafíos del mundo», dijo Marcel Demarteau, director de la División de Física de ORNL e investigador principal del proyecto, que primero tiene como objetivo abordar un tsunami de datos que surgirá de una importante actualización de el acelerador de partículas más potente del mundo, el Gran Colisionador de Hadrones o LHC. “Cada uno de sus detectores de partículas más grandes será capaz de transmitir 50 terabits por segundo, los datos equivalentes a ver 10 millones de películas de Netflix de alta definición al mismo tiempo”.

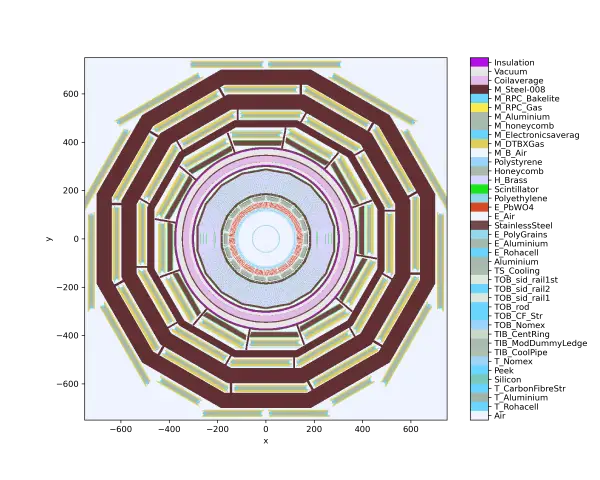

El LHC se encuentra en las profundidades subterráneas de la Organización Europea para la Investigación Nuclear, o CERN, ubicada en la frontera entre Suiza y Francia. Aplastando protones y núcleos más pesados, el LHC produce partículas de progenie que rastrean sus detectores. Los detectores generan enormes cantidades de datos que se comparan con simulaciones para que los experimentos puedan validar teorías. El conocimiento adquirido mejora nuestra comprensión de las fuerzas fundamentales.

Los investigadores esperan que el acelerador de partículas mejorado, llamado High-Luminosity LHC, comience a operar en 2029. La luminosidad mide qué tan apretadas están las partículas a medida que atraviesan el acelerador y chocan. Mayor luminosidad significa más colisiones de partículas. El LHC actualizado promete descubrimientos pero a un costo: creará más datos de los que pueden gestionar las simulaciones.

“El LHC de alta luminosidad aumentará la cantidad de colisiones de protones hasta 10 veces más de lo que puede producir el LHC”, dijo Demarteau.

Para abordar este desafío, los socios del nuevo proyecto están desarrollando un código de simulación llamado Celeritas, la palabra latina para velocidad. Los códigos de simulación actuales funcionan calculando las interacciones electromagnéticas de las partículas a medida que se mueven a través de los detectores. Para aumentar enormemente el rendimiento de datos de simulaciones de alta fidelidad de experimentos de física de alta energía, Celeritas utilizará nuevos algoritmos que emplean unidades de procesamiento de gráficos para procesamiento paralelo masivo en plataformas informáticas de clase líder como Frontier de ORNL. Frontier, la primera computadora a exaescala del mundo, puede realizar quintillones de cálculos por segundo. En otras palabras, puede completar una tarea en un segundo que le llevaría a toda la población mundial más de cuatro años si cada persona pudiera completar un cálculo cada segundo.

Celeritas es uno de los cinco proyectos que la Oficina de Ciencias del DOE está financiando para acelerar los descubrimientos de física de alta energía a través de la computación de alto rendimiento. Sus oficinas de Investigación de Computación Científica Avanzada y Física de Alta Energía apoyan el proyecto a través de un programa llamado Descubrimiento Científico a través de Computación Avanzada, o SciDAC.

“Celeritas es un paso importante en la reelaboración de toda la forma en que se realizan los análisis y simulaciones computacionales en el ecosistema de física de alta energía”, dijo Tom Evans de ORNL. Dirigirá el proyecto de varios laboratorios, que incluye científicos del Laboratorio Nacional Argonne y el Laboratorio Nacional Acelerador Fermi, o Fermilab.

Evans también dirige el Grupo de Métodos de Computación de Alto Rendimiento para Aplicaciones Nucleares de ORNL y encabeza el desarrollo de aplicaciones relacionadas con la cartera de energía de la nación para el Proyecto de Computación a Exaescala del DOE. Utiliza técnicas de Monte Carlo que se basan en muestreos aleatorios repetidos para pasar cada partícula a través de un mundo virtual y simular la historia de su movimiento.

“Piense en ello como un juego de tirar dados, donde simulamos pistas de partículas basadas en los mejores modelos físicos disponibles de sus interacciones con la materia”, dijo Evans, quien trabaja con Seth Johnson de ORNL en el desarrollo de métodos y herramientas para optimizar Celeritas. “Simulamos pistas que cruzan un detector y las comparamos con los datos que salen del detector. Estas correlaciones se utilizan para validar teorías del modelo estándar de física de partículas”.

Actualmente, Worldwide LHC Computing Grid gestiona el almacenamiento, la distribución y el análisis de los datos del LHC. Sus 13 sitios más grandes, incluidos dos en los Estados Unidos, en el Laboratorio Nacional Brookhaven del DOE y Fermilab, se conectan a través de redes de alta velocidad. La infraestructura informática distribuida de Open Science Grid proporciona a más de 12 000 físicos de todo el mundo acceso casi en tiempo real a los datos y la capacidad de procesarlos.

“Queremos incorporar las instalaciones de cómputo de clase líder del DOE en esta red para aprovechar su rico poder y recursos de cómputo”, dijo Evans. Ahora, ni el Centro de Cómputo de Liderazgo de Argonne en el Laboratorio Nacional de Argonne ni el Centro de Cómputo de Liderazgo de Oak Ridge en ORNL son parte de esta red.

En RAPIDS2, el Instituto SciDAC de Ciencias de la Computación, Datos e Inteligencia Artificial, los colaboradores de Celeritas también desarrollarán herramientas de flujo de trabajo para hacer que las instalaciones informáticas federadas del DOE sean compatibles con los centros informáticos de física de alta energía. Fred Suter y Stefano Tognini de ORNL trabajan con Scott Klasky, líder del grupo de sistemas de flujo de trabajo del laboratorio, para integrar herramientas y tecnologías avanzadas que reducen la carga del alto tráfico de datos dentro y fuera de los procesadores.

“A medida que los recursos de cómputo de alto rendimiento continúan creciendo en capacidad computacional, hemos visto un crecimiento mucho menor en su capacidad y ancho de banda de almacenamiento. Eso significa que debemos continuar optimizando los flujos de trabajo para mantener este desequilibrio”, dijo Klasky. “Esto es absolutamente necesario para el descubrimiento científico, especialmente a medida que avanzamos hacia la red informática mundial del LHC. Las técnicas convencionales que han utilizado allí ya no serán suficientes para este desafío informático”.

El primer objetivo del equipo es simular el detector de solenoide de muón compacto del LHC en las supercomputadoras ORNL. Los investigadores de este experimento están ansiosos por integrar Celeritas en su marco de software existente. “Nos dieron nuestro primer objetivo importante: modelar un subcomponente del detector de solenoide compacto de muones llamado calorímetro de alta granularidad”, dijo Evans. Demarteau agregó: “Es un detector complejo de última generación para medir energías. Es un detector altamente sofisticado y un caso de prueba ideal para Celeritas”.

Celeritas tiene consecuencias importantes para el análisis de datos de experimentos con detectores en el CERN, pero su éxito también servirá para experimentos en otros lugares. “Los experimentos de neutrinos como el Experimento de neutrinos subterráneos profundos nuevamente emplean un detector masivo para detectar interacciones de neutrinos”, dijo Demarteau, llamando a un experimento en el Medio Oeste. «Esta herramienta también permitirá nuevos conocimientos sobre las interacciones de los neutrinos con la materia».

UT-Battelle administra ORNL para la Oficina de Ciencias del Departamento de Energía, el mayor patrocinador individual de la investigación básica en ciencias físicas en los Estados Unidos. La Oficina de Ciencias está trabajando para abordar algunos de los desafíos más apremiantes de nuestro tiempo. Para obtener más información, visite energy.gov/science.