Deci, la compañía de aprendizaje profundo que construye la próxima generación de IA, anunció un rendimiento revolucionario en el recién lanzado 4 de Intel.el Procesadores escalables Gen Intel® Xeon®, con nombre en código Sapphire Rapids. Al optimizar los modelos de IA que se ejecutan en el nuevo hardware de Intel, Deci permite a los desarrolladores de IA lograr un rendimiento de inferencia similar al de la GPU en las CPU en producción para tareas de procesamiento de lenguaje natural (NLP) y visión artificial.

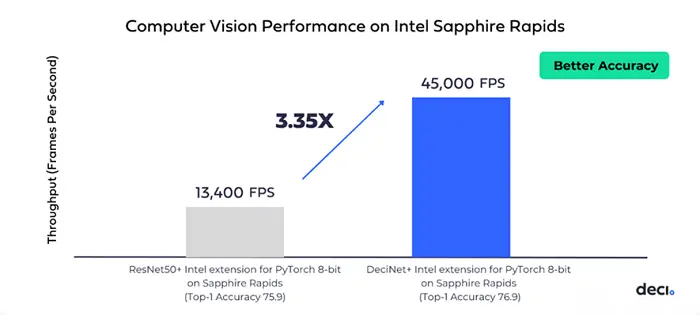

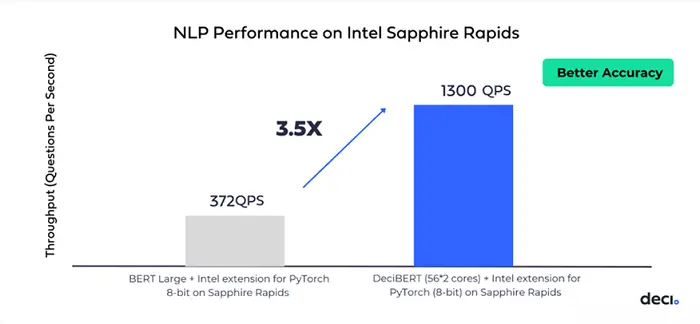

Deci utilizó su tecnología patentada AutoNAC (construcción de arquitectura neuronal automatizada) para generar arquitecturas de modelo personalizadas con reconocimiento de hardware que brindan una precisión y una velocidad de inferencia incomparables en la CPU Intel Sapphire Rapids. Para la visión por computadora, Deci brindó un aumento de rendimiento de 3.35x, así como un aumento de precisión del 1%, en comparación con una versión INT8 de ResNet50 que se ejecuta en Intel Sapphire Rapids. Para NLP, Deci entregó una aceleración de 3,5 veces en comparación con la versión INT8 del modelo BERT en Intel Sapphire Rapids, así como un aumento de precisión de +0,1. Todos los modelos se compilaron y cuantificaron en INT8 con Intel® Advanced Matrix Extensions (AMX) y la extensión Intel para PyTorch.

“Este avance en el rendimiento marca otro capítulo en la asociación Deci-Intel que permite a los desarrolladores de IA lograr una precisión y un rendimiento de inferencia sin precedentes con arquitecturas de modelo con reconocimiento de hardware impulsadas por NAS”, dijo Yonatan Geifman, director ejecutivo y cofundador de Deci. “Estamos encantados de permitir que nuestros clientes conjuntos logren un rendimiento de grado de producción escalable, en cuestión de días”.

Deci e Intel han mantenido amplias colaboraciones tecnológicas y comerciales estratégicas desde 2019, y recientemente anunciaron la aceleración de los modelos de aprendizaje profundo utilizando chips Intel con la tecnología AutoNAC de Deci. Deci es miembro del programa Intel Disruptor y ha colaborado con Intel en varias presentaciones de MLPerf. Juntos, los dos permiten que las nuevas aplicaciones basadas en el aprendizaje profundo se ejecuten a escala en las CPU de Intel, al tiempo que reducen los costos de desarrollo y el tiempo de comercialización.

Si está utilizando CPU para la inferencia de aprendizaje profundo o planea hacerlo, hable con los expertos de Deci para saber cómo puede obtener rápidamente un mejor rendimiento y garantizar la máxima utilización del hardware. Para obtener más información sobre la colaboración Deci-Intel, vaya a https://deci.ai/intel/

Regístrese para recibir el boletín gratuito insideBIGDATA.

Únase a nosotros en Twitter: https://twitter.com/InsideBigData1

Únase a nosotros en LinkedIn: https://www.linkedin.com/company/insidebigdata/

Únase a nosotros en Facebook: https://www.facebook.com/insideBIGDATANOW