En este artículo especial, Vincent Terrasi, director de producto de OnCrawl, habla de lo que ocurre cuando la ciencia de los datos y el aprendizaje de las máquinas se encuentran con el SEO. Vincent se convirtió en Director de Producto de OnCrawl después de haber sido Director de Marketing de Datos en OVH. También es el cofundador de dataseolabs.com, donde ofrece formación sobre Ciencia de los Datos y SEO. Tiene una formación muy variada, con 7 años de emprendimiento para sus propios sitios, luego 3 años en M6Web y 3 años en OVH como Gerente de Marketing de Datos. Es pionero en Ciencia de los Datos y Aprendizaje Automático para SEO.

La ciencia de los datos como un cambio en el juego para el SEO

La ciencia de los datos se cruza con los grandes datos y la inteligencia artificial cuando se trata de analizar y procesar datos conocidos como conjuntos de datos. El creciente campo conocido como ciencia de los datos es una combinación de varias herramientas, algoritmos y reglas de aprendizaje automático que se utilizan para descubrir patrones ocultos basados en datos en bruto.

La ciencia de los datos no es nueva en el SEO: en 2011, Google creó Google Brain, un equipo dedicado a transformar los productos de Google con inteligencia artificial para hacerlos «más rápidos, más inteligentes y más útiles». Con el 95% de los buscadores usando Google como su principal motor de búsqueda, no fue una sorpresa que la compañía Mountain View invirtiera mucho en nuevas tecnologías para mejorar la calidad de sus servicios. En 2015, Google Brain lanzó RankBrain, un algoritmo de cambio de juego que se utiliza para mejorar la calidad de los resultados de búsqueda de Google. Dado que alrededor del 15% de las consultas nunca antes se habían buscado, el propósito era permitir automáticamente que Google comprendiera mejor la consulta para ofrecer los resultados más relevantes.

Estos ejemplos, entre muchos otros, de cómo Google implementa la ciencia de los datos en sus algoritmos muestran que estas dos disciplinas son complementarias. Así que ahora veamos cómo el SEO puede aprovechar el aprendizaje de la máquina.

El valor del aprendizaje de la máquina para el SEO

Cuando se trata de aplicar el aprendizaje de la máquina al SEO, particularmente con respecto a cómo ahorrar tiempo diariamente y cómo mostrar el valor del SEO al C-Suite en su organización, tres ventajas vienen a la mente:

Predicción

Los algoritmos de predicción pueden ser útiles a la hora de priorizar su hoja de ruta, resaltando las palabras clave, identificando las futuras tendencias de las rutas largas o incluso prediciendo el tráfico. Por ejemplo, centrarse en las palabras clave de larga distancia es una estrategia eficaz de SEO, ya que a menudo atraen más tráfico que cualquier otra palabra clave de alta competencia. Sin embargo, como dependen de un número tan reducido de búsquedas, pueden ser difíciles de predecir y planificar. Pero varias razones pueden llevar a la empresa, a los directores de marketing y a muchos otros responsables a pedir proyecciones de tráfico de SEO:

- Para estar seguro de la inversión

- Para equilibrar los gastos entre los canales orgánicos y los pagados

Mediante el uso de modelos capacitados, Facebook Prophet y los datos de la consola de búsqueda de Google, se pueden identificar y detectar futuras tendencias a largo plazo y construir un modelo predictivo para pronosticar los resultados de Google.

Generación de texto

Una estrategia de SEO eficiente requiere un buen contenido, pero la creación de contenido es costosa de establecer y mantener en un sitio web. O simplemente puede ser difícil encontrar la inspiración.

Por eso es que la generación automática de contenidos es valiosa. Cuando la generación de texto es altamente cualitativa, se puede utilizar para:

- Creación de anclas para la vinculación interna

- Creación masiva de variantes de etiquetas de título

- Creación masiva de variantes de meta descripciones

Automatización

La automatización es útil para etiquetar las imágenes y eventualmente el video usando un algoritmo de detección de objetos como el de TensorFlow. Este algoritmo puede ayudar a etiquetar las imágenes, por lo que puede optimizar los atributos alt con bastante facilidad. Además, el proceso de automatización puede ser usado para pruebas A/B ya que es bastante simple hacer algunos cambios básicos en una página.

La automatización también puede usarse para detectar anomalías antes de que Google las note. Uno de los propósitos de una auditoría SEO es encontrar métricas o KPIs donde el sitio web no funciona como se espera.

El uso de la máquina de aprender a encontrar las anomalías reveladas por los rastreos también significa que se pueden tener en cuenta los eventos estacionales, junto con los cambios graduales del sitio web a lo largo del tiempo.

Cómo conectar el SEO técnico con el aprendizaje de la máquina

Un estudio de caso práctico con palabras clave de cola larga

Ahora, prácticamente, ¿qué tan fácil es conectar el SEO técnico con el aprendizaje de la máquina?

Tener acceso a una plataforma de ciencia de datos así como acceso API a una herramienta de SEO haría tu vida más fácil.

Si no tienes este tipo de acceso, me gustaría presentarte una metodología que puedes usar para predecir las tendencias de las palabras clave a largo plazo. Las palabras clave de larga duración son términos de búsqueda que tienen un volumen de búsqueda y una tasa de competencia menores que las palabras clave de corta duración. A menudo atraen más tráfico que cualquier otra palabra clave altamente competitiva, por lo que son muy útiles para cualquier estrategia de SEO.

Objetivos y requisitos previos

Nuestro objetivo es identificar palabras clave de larga duración para su sitio y construir un modelo predictivo para pronosticar las futuras tendencias de larga duración y los éxitos de Google.

Este método, que utiliza un cuaderno de Google Collab y el algoritmo de Facebook Prophet, le permitirá pronosticar datos de series de tiempo basados en un modelo aditivo en el que las tendencias no lineales tienen en cuenta la estacionalidad anual, semanal y diaria, así como los efectos debidos a las vacaciones.

Para eso, necesitarás:

5 pasos para obtener tus predicciones de SEO

Te guiaré a través de 5 pasos fáciles para usar la ciencia de los datos para obtener la predicción de las tendencias de las palabras clave de largo plazo para tu sitio web.

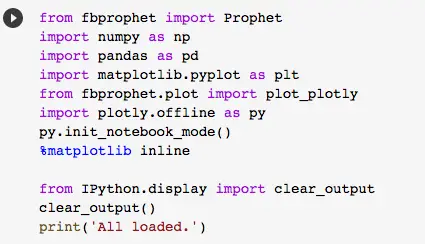

1. Importar bibliotecas

Una vez que hayas abierto tu cuaderno de Google Colab, necesitas importar la biblioteca de Facebook Prophet. Ejecuta el guión para obtener estos recursos.

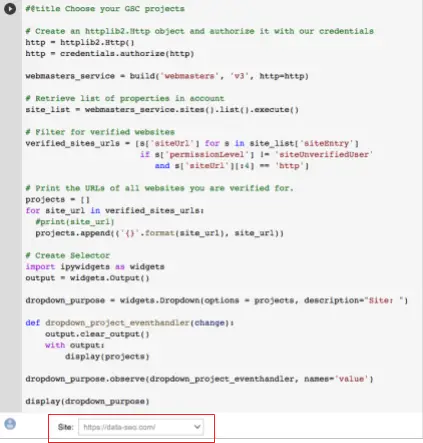

2. Conecta tu consola de búsqueda de Google

Para conectar su consola de búsqueda de Google, debe agregar su «Identificación del cliente«así como tu»Secreto de cliente”. Una vez que hayas rellenado esta información, puedes ejecutar el guión.

El cuaderno le pedirá ahora que elija los proyectos de la SGC que quiera examinar. Puedes elegir simplemente el sitio web que quieres analizar en el menú desplegable:

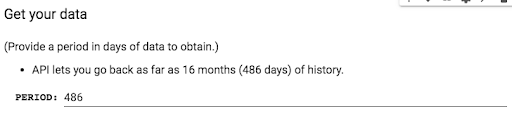

Último paso del acceso a la API de la GSC, debe proporcionar el período que desea examinar. Puedes ir hasta 16 meses, que es el límite de datos disponibles en el GSC:

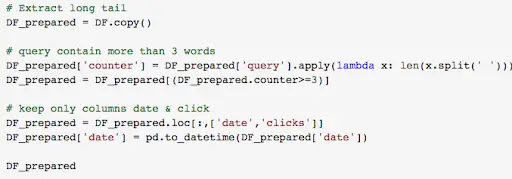

3. Detecte su larga cola

Para este ejemplo, consideraremos que cualquier consulta con más de tres palabras es una consulta de cola larga:

Ejecuta el guión para obtener todas tus consultas de larga duración, el número de clics que reciben y su fecha.

4. Prepara tus datos para Facebook Prophet

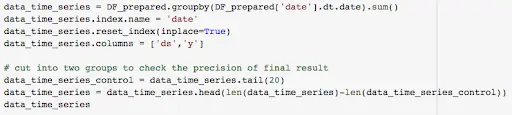

Ahora que tienes todos tus datos de palabras clave de larga duración, tienes que prepararlos para Facebook Prophet:

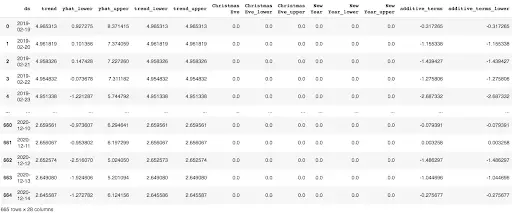

- Termine los datos: clasificar sus datos en dos columnas: una columna de datos (ds) y una columna de valores (y)

- Dividir los datos en dos grupos: El 80% de los datos se utilizarán para crear las proyecciones y el resto de los datos se utilizarán para comprobar la exactitud de las proyecciones.

5. Desarrollar un modelo de previsión y hacer predicciones

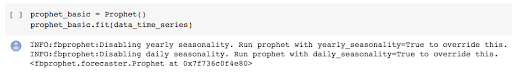

Para desarrollar su modelo de previsión, primero debe crear una instancia de la clase Profeta y luego agregar sus datos:

Entonces, crea un marco de datos con las fechas para las que quieres una predicción con make_future_dataframe(period=X, «X» es un número de días.

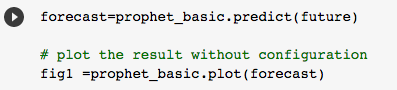

Llama a predecir para hacer una predicción y almacenarla en el pronóstico dataframe.

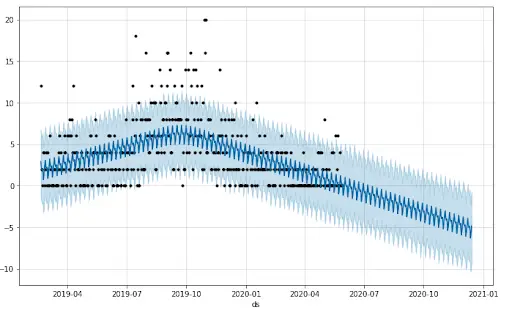

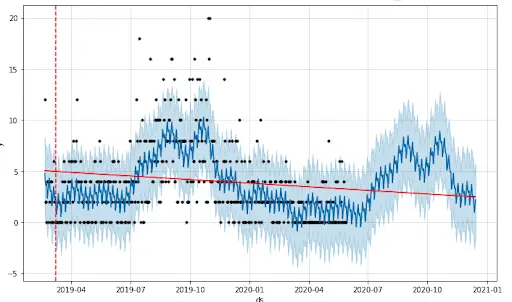

Y aquí estamos, ¡acabas de generar un primer gráfico de predicción con tus propios datos!

Lo que necesita hacer ahora es establecer la realidad del ciclo de vida de su sitio web durante el período analizado.

Déjeme explicarle: El Profeta crea 25 puntos de cambio, o eventos clave, que influyen en los datos. Pero esos eventos clave no son probablemente los que corresponden a la realidad de su sitio web, como la Navidad si tiene un sitio web de comercio electrónico o el Super Bowl si tiene un sitio de medios de comunicación en línea dedicado a los deportes.

Para establecer su número de puntos de cambio, use el n_changepoints al inicializar «Profeta». Prophet también le permitirá ajustar el «rango» de estos eventos clave, es decir, el impacto que tendrán en la predicción.

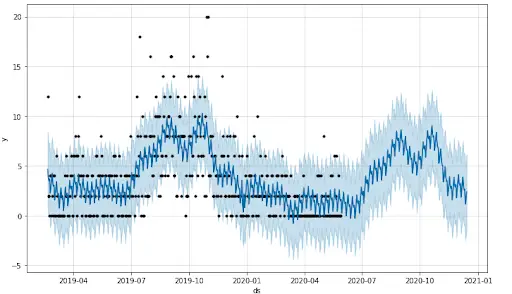

Ahora que has añadido más puntos de cambio, tu gráfico debería parecerse más a esto:

Probablemente tendrás que fijar el número de puntos de cambio y el número de escala_prior_de_puntos_de_cambio para obtener el resultado que quieres. Siéntete libre de jugar con los scripts para reducir la tasa de error y elegir tu escala.

Una vez hecho esto, podemos calcular la proyección final. Ejecuta el guión para obtener el resultado final y los datos de la proyección:

Envuélvelo.

Hemos visto en este post un método para aprovechar los datos de la SGC con Facebook Prophet. Con nada más que el acceso a la API correcta y este cuaderno de Google Colab, puede crear fácilmente un pronóstico fiable de sus palabras clave de larga duración y de los hits de Google.

Estos datos pueden utilizarse directamente en los informes, pero también cuando se establecen los objetivos de una campaña de comercialización o como punto de referencia para establecer el valor de un proyecto.

Una vez que vea lo útil que puede ser este tipo de análisis para el SEO, será difícil imaginar un momento en el que la ciencia de los datos y el SEO técnico no fueran de la mano.

Suscríbete al boletín de noticias gratuito de InsideBIGDATA.