Mezcla de expertos es una técnica de aprendizaje por conjuntos desarrollada en el campo de las redes neuronales.

Implica descomponer las tareas de modelado predictivo en subtareas, entrenar un modelo experto en cada una, desarrollar un modelo de puerta que aprende en qué experto confiar en función de la entrada que se va a predecir y combina las predicciones.

Aunque la técnica se describió inicialmente utilizando expertos en redes neuronales y modelos de activación, se puede generalizar para utilizar modelos de cualquier tipo. Como tal, muestra una fuerte similitud con la generalización apilada y pertenece a la clase de métodos de aprendizaje por conjuntos denominados metaaprendizaje.

En este tutorial, descubrirá la combinación de enfoques de expertos para el aprendizaje conjunto.

Después de completar este tutorial, sabrá:

- Un enfoque intuitivo del aprendizaje en conjunto implica dividir una tarea en subtareas y desarrollar un experto en cada subtarea.

- La mezcla de expertos es un método de aprendizaje por conjuntos que busca abordar explícitamente un problema de modelado predictivo en términos de subtareas utilizando modelos expertos.

- El enfoque de divide y vencerás está relacionado con la construcción de árboles de decisión, y el enfoque de metaaprendizaje está relacionado con el método de conjunto de generalización apilada.

Pon en marcha tu proyecto con mi nuevo libro Ensemble Learning Algorithms With Python, que incluye tutoriales paso a paso y el Código fuente de Python archivos para todos los ejemplos.

Empecemos.

Una suave introducción a la mezcla de conjuntos de expertos

Foto de Radek Kucharski, algunos derechos reservados.

Descripción general del tutorial

Este tutorial se divide en tres partes; ellos son:

- Subtareas y expertos

- Mezcla de expertos

- Subtareas

- Modelos expertos

- Modelo de puerta

- Método de agrupación

- Relación con otras técnicas

- Mezcla de expertos y árboles de decisión

- Mezcla de expertos y apilamiento

Subtareas y expertos

Algunas tareas de modelado predictivo son notablemente complejas, aunque pueden ser adecuadas para una división natural en subtareas.

Por ejemplo, considere una función unidimensional que tiene una forma compleja como una S en dos dimensiones. Podríamos intentar idear un modelo que modele la función por completo, pero si conocemos la forma funcional, la forma de S, también podríamos dividir el problema en tres partes: la curva en la parte superior, la curva en la parte inferior y la línea que conecta las curvas.

Esto es un divide y conquistaras enfoque para la resolución de problemas y subyace a muchos enfoques automatizados para el modelado predictivo, así como a la resolución de problemas de manera más amplia.

Este enfoque también se puede explorar como base para desarrollar un método de aprendizaje por conjuntos.

Por ejemplo, podemos dividir el espacio de características de entrada en subespacios en función de algún conocimiento de dominio del problema. A continuación, se puede entrenar un modelo en cada subespacio del problema, siendo de hecho un experto en el subproblema específico. Luego, un modelo aprende a qué experto recurrir para predecir nuevos ejemplos en el futuro.

Los subproblemas pueden o no superponerse, y los expertos de subproblemas similares o relacionados pueden contribuir a los ejemplos que están técnicamente fuera de su experiencia.

Este enfoque del aprendizaje conjunto es la base de una técnica denominada mezcla de expertos.

Mezcla de expertos

Mezcla de expertos, MoE o ME para abreviar, es una técnica de aprendizaje por conjuntos que implementa la idea de capacitar a expertos en subtareas de un problema de modelado predictivo.

En la comunidad de redes neuronales, varios investigadores han examinado la metodología de descomposición. […] Metodología de mezcla de expertos (ME) que descompone el espacio de entrada, de modo que cada experto examina una parte diferente del espacio. […] Una red de puertas se encarga de combinar los distintos expertos.

– Página 73, Clasificación de patrones utilizando métodos de conjunto, 2010.

Hay cuatro elementos en el enfoque, ellos son:

- División de una tarea en subtareas.

- Desarrolle un experto para cada subtarea.

- Utilice un modelo de activación para decidir qué experto utilizar.

- Agrupe las predicciones y la salida del modelo de activación para realizar una predicción.

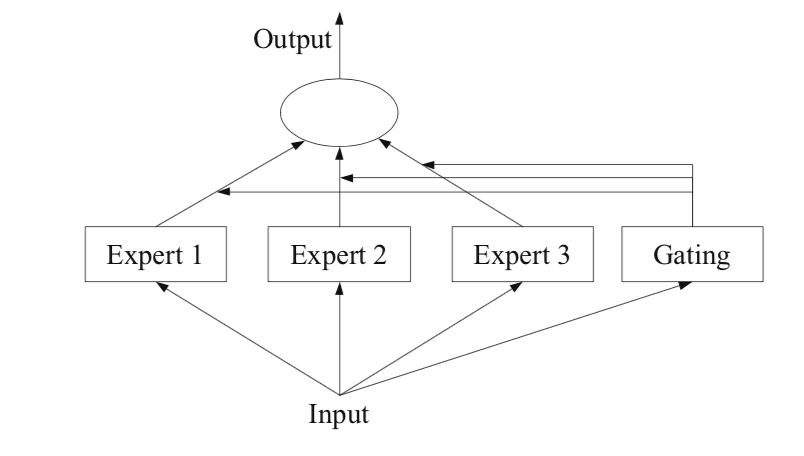

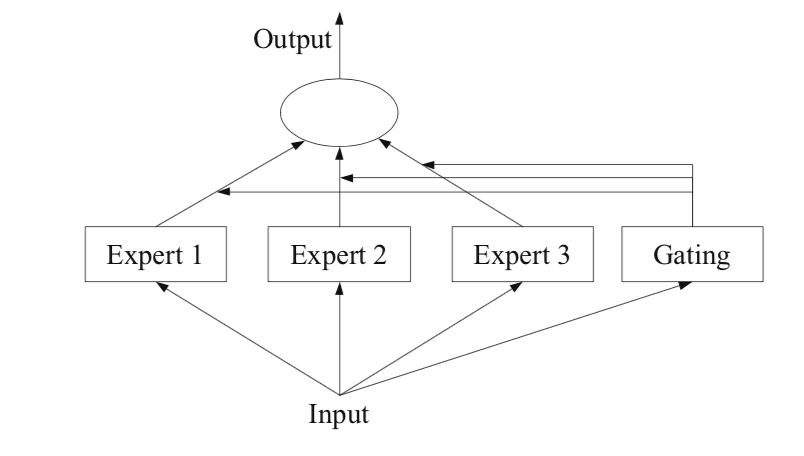

La siguiente figura, tomada de la página 94 del libro de 2012 “Métodos de conjunto”, proporciona una descripción general útil de los elementos arquitectónicos del método.

Ejemplo de un modelo de mezcla de expertos con miembros expertos y una red de puerta

Tomado de: Métodos de conjunto

Subtareas

El primer paso es dividir el problema de modelado predictivo en subtareas. Esto a menudo implica el uso de conocimientos de dominio. Por ejemplo, una imagen podría dividirse en elementos separados como fondo, primer plano, objetos, colores, líneas, etc.

… ME trabaja en una estrategia de divide y vencerás en la que una tarea compleja se divide en varias subtareas más simples y más pequeñas, y los alumnos individuales (llamados expertos) están capacitados para diferentes subtareas.

– Página 94, Métodos de conjunto, 2012.

Para aquellos problemas en los que la división de la tarea en subtareas no es obvia, se podría utilizar un enfoque más simple y genérico. Por ejemplo, uno podría imaginar un enfoque que divida el espacio de características de entrada por grupos de columnas o separe ejemplos en el espacio de características basándose en medidas de distancia, inliers y valores atípicos para una distribución estándar, y mucho más.

… En ME, un problema clave es cómo encontrar la división natural de la tarea y luego derivar la solución general a partir de subsoluciones.

– Página 94, Métodos de conjunto, 2012.

Modelos expertos

A continuación, se diseña un experto para cada subtarea.

El enfoque de mezcla de expertos se desarrolló y exploró inicialmente dentro del campo de las redes neuronales artificiales, por lo que tradicionalmente los propios expertos son modelos de redes neuronales que se utilizan para predecir un valor numérico en el caso de regresión o una etiqueta de clase en el caso de clasificación.

Debe quedar claro que podemos «conectar» cualquier modelo para el experto. Por ejemplo, podemos usar redes neuronales para representar tanto las funciones de activación como a los expertos. El resultado se conoce como red de densidad de mezcla.

– Página 344, Aprendizaje automático: una perspectiva probabilística, 2012.

Cada uno de los expertos recibe el mismo patrón de entrada (fila) y hace una predicción.

Modelo de puerta

Se utiliza un modelo para interpretar las predicciones realizadas por cada experto y para ayudar a decidir en qué experto confiar para una determinada entrada. Esto se denomina modelo de puerta, o red de puerta, dado que tradicionalmente es un modelo de red neuronal.

La red de puertas toma como entrada el patrón de entrada que se proporcionó a los modelos expertos y genera la contribución que cada experto debería tener al hacer una predicción para la entrada.

… los pesos determinados por la red de puertas se asignan dinámicamente en función de la entrada dada, ya que el Ministerio de Educación aprende de manera efectiva qué parte del espacio de características aprende cada miembro del conjunto

– Página 16, Ensemble Machine Learning, 2012.

La red de puertas es clave para el enfoque y, efectivamente, el modelo aprende a elegir el tipo de subtarea para una entrada determinada y, a su vez, el experto en quien confiar para hacer una predicción sólida.

La mezcla de expertos también puede verse como un algoritmo de selección de clasificadores, donde los clasificadores individuales son entrenados para convertirse en expertos en alguna porción del espacio de características.

– Página 16, Ensemble Machine Learning, 2012.

Cuando se utilizan modelos de redes neuronales, la red de puertas y los expertos se capacitan juntos para que la red de puertas aprenda cuándo confiar en cada experto para hacer una predicción. Este procedimiento de entrenamiento se implementó tradicionalmente utilizando la maximización de expectativas (EM). La red de control puede tener una salida softmax que proporcione una puntuación de confianza similar a la probabilidad para cada experto.

En general, el procedimiento de entrenamiento intenta lograr dos objetivos: para determinados expertos, encontrar la función de activación óptima; para una función de puerta dada, capacitar a los expertos en la distribución especificada por la función de puerta.

– Página 95, Ensemble Machine Learning, 2012.

Método de agrupación

Finalmente, la mezcla de modelos expertos debe hacer una predicción, y esto se logra mediante un mecanismo de agrupación o agregación. Esto podría ser tan simple como seleccionar al experto con el mayor rendimiento o confianza que proporciona la red de puertas.

Alternativamente, se podría hacer una predicción de suma ponderada que combine explícitamente las predicciones hechas por cada experto y la confianza estimada por la red de control. Puede imaginar otros enfoques para hacer un uso eficaz de las predicciones y la salida de la red de puerta.

El sistema de agrupación / combinación puede entonces elegir un solo clasificador con el peso más alto, o calcular una suma ponderada de las salidas del clasificador para cada clase, y elegir la clase que recibe la suma ponderada más alta.

– Página 16, Ensemble Machine Learning, 2012.

¿Quiere comenzar con el aprendizaje por conjuntos?

Realice ahora mi curso intensivo gratuito de 7 días por correo electrónico (con código de muestra).

Haga clic para registrarse y obtener también una versión gratuita en formato PDF del curso.

Descarga tu minicurso GRATIS

Relación con otras técnicas

El método de mezcla de expertos es menos popular hoy en día, quizás porque se describió en el campo de las redes neuronales.

Sin embargo, se han producido más de 25 años de avances y exploración de la técnica y puede ver un gran resumen en el artículo de 2012 «Veinte años de mezcla de expertos».

Es importante destacar que recomendaría considerar la intención más amplia de la técnica y explorar cómo podría usarla en sus propios problemas de modelado predictivo.

Por ejemplo:

- ¿Existen formas obvias o sistemáticas de dividir su problema de modelado predictivo en subtareas?

- ¿Existen métodos especializados que pueda entrenar en cada subtarea?

- Considere desarrollar un modelo que prediga la confianza de cada modelo experto.

Mezcla de expertos y árboles de decisión

También podemos ver una relación entre una mezcla de expertos y los árboles de clasificación y regresión, a menudo denominados CART.

Los árboles de decisión se ajustan utilizando un enfoque de dividir y conquistar para el espacio de características. Cada división se elige como un valor constante para una característica de entrada y cada subárbol puede considerarse un submodelo.

La mezcla de expertos se estudió principalmente en la comunidad de redes neuronales. En este hilo, los investigadores generalmente consideran una estrategia de divide y vencerás, intentan aprender una combinación de modelos paramétricos de manera conjunta y usan reglas de combinación para obtener una solución general.

– Página 16, Métodos de conjunto, 2012.

Podríamos adoptar un enfoque de descomposición recursiva similar para descomponer la tarea de modelado predictivo en subproblemas al diseñar la combinación de expertos. Esto se conoce generalmente como una mezcla jerárquica de expertos.

El procedimiento de mezclas jerárquicas de expertos (HME) puede verse como una variante de los métodos basados en árboles. La principal diferencia es que las divisiones de árboles no son decisiones difíciles sino probabilísticas suaves.

– Página 329, Los elementos del aprendizaje estadístico, 2016.

A diferencia de los árboles de decisión, la división de la tarea en subtareas suele ser explícita y descendente. Además, a diferencia de un árbol de decisiones, la combinación de expertos intenta examinar todos los submodelos de expertos en lugar de un solo modelo.

Hay otras diferencias entre los HMEs y la implementación CART de árboles. En un HME, se ajusta un modelo lineal (o de regresión logística) en cada nodo terminal, en lugar de una constante como en CART. Las divisiones pueden ser de múltiples vías, no solo binarias, y las divisiones son funciones probabilísticas de una combinación lineal de entradas, en lugar de una sola entrada como en el uso estándar de CART.

– Página 329, Los elementos del aprendizaje estadístico, 2016.

Sin embargo, estas diferencias pueden inspirar variaciones en el enfoque para un problema de modelado predictivo dado.

Por ejemplo:

- Considere enfoques automáticos o generales para dividir el espacio de características o el problema en subtareas para ayudar a ampliar la idoneidad del método.

- Considere explorar ambos métodos de combinación que confían en el mejor experto, así como métodos que buscan un consenso ponderado entre los expertos.

Mezcla de expertos y apilamiento

La aplicación de la técnica no tiene que limitarse a modelos de redes neuronales y se puede utilizar una variedad de técnicas estándar de aprendizaje automático en el lugar buscando un fin similar.

De esta manera, el método de mezcla de expertos pertenece a una clase más amplia de métodos de aprendizaje por conjuntos que también incluirían la generalización apilada, conocida como apilado. Como una mezcla de expertos, el apilamiento entrena un conjunto diverso de modelos de aprendizaje automático y luego aprende un modelo de orden superior para combinar mejor las predicciones.

Podríamos referirnos a esta clase de métodos de aprendizaje por conjuntos como modelos de metaaprendizaje. Es decir, modelos que intentan aprender de la salida o aprender cómo combinar mejor la salida de otros modelos de nivel inferior.

El metaaprendizaje es un proceso de aprendizaje de los alumnos (clasificadores). […] Para inducir un meta clasificador, primero se entrenan los clasificadores base (etapa uno) y luego el meta clasificador (segunda etapa).

– Página 82, Clasificación de patrones utilizando métodos de conjunto, 2010.

A diferencia de una combinación de expertos, los modelos de apilamiento a menudo se ajustan todos al mismo conjunto de datos de entrenamiento, p. Ej. sin descomposición de la tarea en subtareas. Y también a diferencia de una mezcla de expertos, el modelo de nivel superior que combina las predicciones de los modelos de nivel inferior normalmente no recibe el patrón de entrada proporcionado a los modelos de nivel inferior y, en cambio, toma como entrada las predicciones de cada modelo de nivel inferior. .

Los métodos de metaaprendizaje son los más adecuados para los casos en los que ciertos clasificadores clasifican correctamente de manera consistente, o clasifican erróneamente de manera consistente, ciertas instancias.

– Página 82, Clasificación de patrones utilizando métodos de conjunto, 2010.

Sin embargo, no hay ninguna razón por la que el apilamiento híbrido y la combinación de modelos expertos no puedan desarrollarse mejor que cualquiera de los enfoques de forma aislada en un problema de modelado predictivo dado.

Por ejemplo:

- Considere tratar los modelos de nivel inferior en apilamiento como expertos capacitados en diferentes perspectivas de los datos de entrenamiento. Quizás esto podría implicar el uso de un enfoque más suave para descomponer el problema en subproblemas donde se utilizan diferentes transformaciones de datos o métodos de selección de características para cada modelo.

- Considere proporcionar el patrón de entrada al metamodelo en el apilamiento en un esfuerzo por hacer que la ponderación o la contribución de los modelos de nivel inferior estén condicionadas al contexto específico de la predicción.

Otras lecturas

Esta sección proporciona más recursos sobre el tema si desea profundizar.

Documentos

Libros

Artículos

Resumen

En este tutorial, descubrió una combinación de enfoques de expertos para el aprendizaje en conjunto.

Específicamente, aprendiste:

- Un enfoque intuitivo del aprendizaje en conjunto implica dividir una tarea en subtareas y desarrollar un experto en cada subtarea.

- La mezcla de expertos es un método de aprendizaje por conjuntos que busca abordar explícitamente un problema de modelado predictivo en términos de subtareas utilizando modelos expertos.

- El enfoque de divide y vencerás está relacionado con la construcción de árboles de decisión, y el enfoque de metaaprendizaje está relacionado con el método de conjunto de generalización apilada.

¿Tiene usted alguna pregunta?

Haga sus preguntas en los comentarios a continuación y haré todo lo posible para responder.