Una convergencia única de tres megatendencias ayudó a sacar la inteligencia artificial de la academia y la hizo omnipresente en las aplicaciones cotidianas: big data, computación en la nube y algoritmos avanzados. Hoy en día, la IA ha cambiado fundamentalmente la forma en que se escribe el software y se integra en las experiencias digitales diarias, como escribir correos electrónicos, buscar en la web, comprar ropa, buscar y escuchar música y crear sitios web. Sin embargo, algo más lenta ha sido la propagación de la IA en los sistemas de infraestructura global de fabricación, transporte, aviación, generación de energía, servicios financieros y otras industrias.

Si bien estas industrias tienen grandes cantidades de datos, los datos a menudo son:

- no en el dominio público; por ejemplo, exploración de petróleo o informes de impacto ambiental en petróleo y gas

- requiere humanos altamente informados para anotar; por ejemplo, datos de sensores de turbinas de gas, bombas, compresores

- se almacena en almacenes de datos complejos, en muchos formatos, y no siempre se limpia; por ejemplo, registros o manuales de mantenimiento de aeronaves

Estos desafíos muy reales hacen que la aplicación de las mismas técnicas de IA que revolucionaron la búsqueda en Internet, la lectura de facturas, la traducción de idiomas y la celebración de conversaciones no se apliquen tal cual a dominios especializados.

Los profesionales de la IA en la industria se están dando cuenta de que los enfoques convencionales de aprendizaje automático supervisado y los modelos a gran escala de la academia y la investigación a menudo fallan en dominios especializados, lo que dificulta mucho la puesta en funcionamiento de los grandes datos en las empresas comerciales. Como dijo Chirag Dekate, director analista sénior de Gartner en 2019, «lanzar pilotos es engañosamente fácil, pero implementarlos en producción es un desafío notorio».

En lugar de depender de científicos de datos y desarrolladores de software, la clave para la adopción de la industria es empoderar a los expertos en la materia (SMEs) que entienden íntimamente los procesos y los datos. Sin embargo, permitir que las pymes, como técnicos aeronáuticos, operadores de centrales eléctricas, analistas financieros, agentes de aduanas y otros, definan, construyan e implementen su propia IA especialmente diseñada de forma intuitiva y rápida requiere nuevos enfoques para el descubrimiento, las herramientas, la automatización y la validación de datos. de ciencia de datos.

Algunas de las técnicas probadas para hacer operativas las formas más frecuentes de Big Data en las empresas incluyen:

Creación de alertas tempranas para tiempo de inactividad de activos no planificado con modelado de comportamiento normal en datos de sensores digitales

Las operaciones industriales a menudo dependen de activos críticos de alto valor como las turbinas de gas. Un solo día de tiempo de inactividad o interrupción no planificada puede costarle a una compañía eléctrica o proveedor de servicios públicos ~ 300 000 en ingresos perdidos; la interrupción para los consumidores puede ser significativamente más grave. Debido a su naturaleza crítica, estos sistemas generalmente están sobrecargados con redundancia y tienen programas integrales de mantenimiento preventivo. Irónicamente, esto dificulta el aprendizaje automático supervisado tradicional, ya que hay muy pocas fallas durante la vida útil del sistema.

El modelado de comportamiento normal es una técnica de aprendizaje automático semisupervisado independiente del dominio que se puede utilizar para modelar rápidamente cualquier sistema representándolo como una combinación de parámetros de proceso. Las pymes identifican los períodos de tiempo del comportamiento normal del sistema en los datos históricos y luego la IA comienza a aprender las relaciones latentes entre los parámetros del proceso. Los codificadores automáticos son un tipo de red neuronal que se entrena con los datos históricos y almacena las relaciones latentes como un conjunto de pesos. Una vez que se entrena el codificador automático, se puede usar para predecir o regenerar los parámetros del proceso de entrada. Si y cuando los valores pronosticados o regenerados de los parámetros del proceso no coinciden con los valores históricos medidos, el error normalizado se usa como una medida de «anormalidad» o anomalía.

Antes de que este tipo de modelo de comportamiento normal se pueda producir, se debe realizar una prueba retrospectiva con un registro histórico de interrupciones y eventos reales en el sistema. Si los parámetros de proceso seleccionados representan bien el comportamiento del sistema, entonces antes de cualquier interrupción, algunos o todos los parámetros deberían comenzar a tener una tendencia en un rango anormal. El modelo de comportamiento normal debería predecir esto elevando el nivel de anormalidad. Si el nivel de anormalidad se eleva lo suficiente antes de una interrupción de manera consistente, se puede usar para crear un sistema de alerta temprana para interrupciones en el futuro.

En la práctica, se pueden entrenar automáticamente decenas o cientos de modelos de comportamiento normal mediante la optimización de hiperparámetros. Se crea una función objetivo para medir tanto la precisión de las predicciones como la duración de la alerta temprana. Esta función objetiva permite evaluar y clasificar mediante programación todas las variantes del modelo e implementar las mejores en producción. Se pueden agregar capas adicionales de ajuste para seleccionar los umbrales dinámicos correctos para emitir alertas según el nivel de anormalidad y la preferencia del usuario.

El modelo de comportamiento normal ofrece las siguientes ventajas sobre el modelado tradicional:

- Agnóstico de dominio. El enfoque se puede utilizar siempre que las variables del proceso se midan/registren con una frecuencia y precisión razonables.

- Aprendizaje sin supervisión. El esfuerzo inicial se limita a la selección de variables y la identificación de las condiciones operativas nominales y, por lo general, lo pueden realizar las PYME.

Búsqueda de patrones en registros de lenguaje natural mediante la agrupación en clústeres basada en la densidad ad-hoc

Los registros de lenguaje natural son muy comunes en entornos industriales y forman la base de una amplia gama de procesos, como pruebas de productos, registros de aplicación/seguridad, mantenimiento de equipos, logística, envío y más. En la práctica, la mayoría de los registros en las empresas son registros semiestructurados, con una o más columnas de datos estructurados (números, fechas, categorías) y una o más columnas o texto en lenguaje natural que generalmente se crean para consumo humano. La necesidad de registros semiestructurados es casi emergente en las empresas. En un mundo ideal, todos los datos recopilados sobre un proceso podrían ser números, fechas y elementos categóricos de opción múltiple. Sin embargo, en la práctica, existen múltiples razones por las que el lenguaje natural se introduce en los registros:

- No todas las modalidades de proceso se conocen en el momento del diseño, lo que lleva a «otros» o captura todas las categorías.

- Las instrucciones o procedimientos se representan mejor como lenguaje natural y se mejoran constantemente con el tiempo.

- La resolución de problemas, diagnósticos, investigaciones, y más suele generar conocimiento que antes desconocía haciendo necesario el lenguaje natural.

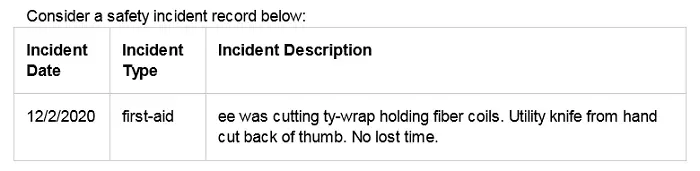

Los registros operativos en las empresas a menudo son funcionales/concisos, contienen errores tipográficos y coloquiales, y generalmente contienen acrónimos y jerga (por ejemplo, ty-wrap = Tyvek wrap, ee = empleado). Esto hace que las técnicas de modelado de lenguaje natural y de búsqueda estándar sean algo ineficaces. Además, puede haber una miríada de formas de usar el lenguaje natural, por lo que un esquema integral para la normalización es insostenible. P.ej. el incidente anterior puede clasificarse por su gravedad (es decir, lesión menor) o podría clasificarse por punto de lesión (es decir, lesión en la mano). Las dos categorías no son mutuamente excluyentes y deben considerarse como esquemas de categorización separados. Sin un gran esfuerzo por parte de las PYMES, la mayoría de los registros de lenguaje natural rara vez se analizan y no se utilizan.

Un enfoque práctico para encontrar patrones útiles en los registros de lenguaje natural es el agrupamiento ad-hoc. Para recuperar información, las PYMES primero utilizan técnicas comunes de búsqueda en sus registros. Sin embargo, leer los resultados en cientos suele ser tedioso y simplemente consumir los resultados «n» principales deja espacio para la información perdida. Para evitar estos peligros, la IA aplica una agrupación basada en la densidad en los resultados de búsqueda. Cuando se utilizan enfoques basados en la densidad como DBSCAN o HDBSCAN en incrustaciones de oraciones de registros, tienden a agrupar un lenguaje semánticamente similar sin ser muy sensibles a la ortografía, conjugaciones, errores tipográficos y coloquialismos. Las PYMES pueden leer fácilmente un par de registros representativos en un clúster para comprenderlo por completo. Además, el análisis de los principales «n» grupos generalmente expone todos los patrones predominantes de información en los resultados de búsqueda. Estos grupos ahora también pueden convertirse en candidatos iniciales para un esquema de clasificación que puede crear estructuras categóricas alrededor de los datos de manera progresiva. Esta técnica demuestra constantemente un alto valor en los problemas de búsqueda de cola larga cuando las intenciones de las PYMES no pueden conocerse con precisión y por completo de antemano, pero pueden definirse y aplicarse con el tiempo.

Recuperación de información o conocimiento de documentos usando Discovery Loops

Con el fin de impulsar decisiones críticas y sensibles al tiempo, los analistas de todos los verticales de la industria, agencias gubernamentales y ramas militares se encuentran con mangueras contra incendios masivas de contenido que deben procesar. Los ejecutivos cuentan con analistas para interpretar con precisión los informes, las noticias, los avisos y las investigaciones a fin de proporcionar apoyo para tomar decisiones seguras y bien pensadas. Buscar el contenido correcto a través de la lectura exploratoria es cognitivamente exigente y genera fatiga en la toma de decisiones. Además, los analistas suelen explorar conceptos esotéricos que son difíciles de articular claramente utilizando palabras clave y reglas lógicas requeridas por las herramientas de búsqueda estándar. Los analistas generalmente están de acuerdo en que “lo saben cuando lo ven”.

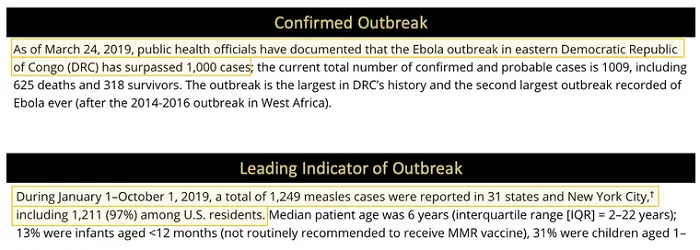

Al considerar el ejemplo de texto narrativo de los extractos de noticias anteriores:

El segundo ejemplo en realidad no usa la palabra «brote», pero una PYME podría evaluarlo rápidamente como un indicador principal de un brote. Para abordar estos escenarios esotéricos de captura de conocimiento, las PYME primero buscan en sus documentos una o más palabras clave que representen las ideas que desean encontrar. Discovery Loop AI luego selecciona 25-50 oraciones más representativas de los resultados y con simples gestos de apuntar y hacer clic, permite a la PYME clasificar los resultados en una o más categorías significativas. Alternativamente, el SME también puede indicar subcadenas de las oraciones para extraerlas textualmente. La IA entrena a un clasificador CNN para aprender las categorías asignadas por la SME. Las oraciones que quedan sin clasificar se asignan automáticamente a una categoría «no interesante». El modelo así entrenado ejecuta la inferencia contra todas las oraciones en los resultados de búsqueda originales. En función de las predicciones de categoría inferidas y su confianza de predicción relativa, la IA presenta al menos 2 grupos de oraciones para que el SME las revise y/o corrija: «más como la etiqueta x» y «menos como la etiqueta x» según las etiquetas de categoría asignadas. al grupo inicial de 25-50 oraciones. Dado que la IA solo entrena modelos en 25-50 oraciones y ejecuta inferencias en los resultados de la búsqueda, el ciclo generalmente toma solo unos minutos. De manera similar, cada grupo de revisión tiene solo 25-50 oraciones cada uno, lo que requiere solo minutos de revisión por parte del SME. Esta iteración rápida se conoce como Discovery Loop y permite que la PYME descubra información rápidamente sin centrarse en las palabras clave, sino simplemente leyendo y tomando decisiones puntuales. A medida que SME selecciona más oraciones etiquetadas, la IA vuelve a entrenar el modelo de clasificación o extracción para mejorar la precisión y aumenta la cobertura del conjunto de documentos al realizar la expansión de consultas utilizando palabras clave extraídas de oraciones etiquetadas. En cualquier momento, el modelo se puede comparar con todas las oraciones del conjunto de documentos para obtener un subconjunto completo de oraciones que coincidan con el concepto esotérico definido por el SME, que luego se puede citar o mencionar como evidencia en el informe del analista.

Tanto el agrupamiento ad-hoc basado en la densidad como Discovery Loop ofrecen las siguientes ventajas sobre los enfoques clásicos de clasificación supervisada:

- Reduzca la tediosa carga de etiquetado integral requerida por adelantado para los enfoques clásicos

- Permitir que las pymes desarrollen categorías progresivamente a medida que descubren nueva información

- Permita que las pymes solo modelen un subconjunto útil de los datos

Una característica común de todas las técnicas es el aumento del conocimiento y la intuición de las PYME con IA, lo que les permite centrarse en decisiones de alto valor. Al evitar los enfoques clásicos de modelado supervisado populares en el mundo académico, estas técnicas se centran en la utilidad rápida al proporcionar inteligencia justo a tiempo al alcance de la mano de la PYME.

Sobre el Autor

Jaidev Amrite es el jefe de producto de la IA de lenguaje natural de SparkCognition, DeepNLP. Antes de SparkCognition, Amrite lideró múltiples iniciativas de desarrollo de productos en IIoT, análisis de datos y sistemas integrados en National Instruments y Microsoft. Obtuvo su Maestría en Ingeniería Eléctrica e Informática de Georgia Tech y le apasiona hacer que la tecnología sea accesible a través del diseño centrado en el ser humano y la psicología social.

Regístrese para recibir el boletín gratuito insideBIGDATA.

Únase a nosotros en Twitter: @InsideBigData1 – https://twitter.com/InsideBigData1