En enero de 2012, escribía sobre el pasado y el futuro de la inteligencia artificial (IA). Reiteré la pregunta de Bill Joy de 2000: ¿El futuro nos necesita? Poco sabía entonces que ya se estaba gestando una revolución. Para 2011, las GPU habían acelerado considerablemente el entrenamiento de redes neuronales profundas, creando finalmente una tecnología cuyas raíces se remontan a principios de la década de 1940.b competitivo. Entre 2011 y 2012, AlexNet, una red neuronal profunda, ganó varios concursos internacionales y dio inicio a la revolución del aprendizaje profundo. Una década más tarde, la IA generativa, que se refiere a la IA que puede generar contenido novedoso en lugar de simplemente analizar o actuar sobre los datos existentes, se ha puesto de moda. En las últimas semanas, ChatGPT, el «chico más nuevo en el bloque de IA generativa», está prácticamente en todas partes.

Los informes de los medios sobre estas nuevas tecnologías de IA a menudo se centran en su riesgo social, y se han presentado varias propuestas con el objetivo de contener el riesgo de la IA. En octubre de 2022, la Oficina de Política Científica y Tecnológica de los Estados Unidos (OSTP), que forma parte de la Oficina Ejecutiva del Presidente de los Estados Unidos, publicó un Plan para una Declaración de Derechos de AI. Este proyecto de ley identificó cinco principios que «deberían guiar el diseño, uso y despliegue de sistemas automatizados para proteger al público estadounidense en la era de la inteligencia artificial». En noviembre de 2022, el Consejo de política tecnológica de ACM publicó una declaración sobre los principios para los sistemas algorítmicos responsables, identificando nueve principios «destinados a fomentar la toma de decisiones algorítmicas justa, precisa y beneficiosa».

principialismo es un enfoque desarrollado en la ética biomédica que utiliza un marco de principios éticos universales que deben ser la base de las decisiones biomédicas. Sin embargo, su reciente aumento en la informática ha sido criticado:C «Son principios aislados situados en una industria y un sistema educativo que en gran medida ignora la ética; y son principios sin dientes que carecen de consecuencias y se adhieren a las agendas corporativas».

Considere la declaración de política de ACM. La declaración se dirige a los constructores y operadores de sistemas, desarrolladores de sistemas de IA y operadores de sistemas de IA. En otras palabras, la declaración no se trata de sistemas algorítmicos responsables, sino de personas y corporaciones responsables. Sin embargo, como he señalado anteriormente,d ACM se ha mostrado renuente a abordar el comportamiento poco ético de las corporaciones de tecnología y sus líderes, incluso cuando estas corporaciones violan flagrantemente el Código de Ética y Conducta Profesional de ACM.

La misión de OSTP es «maximizar los beneficios de la ciencia y la tecnología para promover la salud, la prosperidad, la seguridad, la calidad ambiental y la justicia para todos los estadounidenses». OSTP, sin embargo, es un órgano de gobierno, no un departamento de filosofía. La gobernabilidad ocurre a través de acciones, ya sea por acciones ejecutivas o proyectos de ley del Congreso. Hasta ahora, OSTP no ha compartido nada sobre un plan para convertir la Declaración de derechos de AI en una política procesable.

Las preocupaciones sobre el daño social causado por la IA no son nuevas. Hace aproximadamente una década, el filósofo Nick Bostrom se preocupó por el riesgo existencial de la IA superinteligente. En su experimento mental «Paperclip Maximizer», planteó la hipótesis de un agente superinteligente cuyo objetivo es maximizar la cantidad de clips en su colección. En su afán por cumplir su misión, el agente puede transformar «primero toda la tierra y luego porciones cada vez mayores del espacio en instalaciones de fabricación de clips». El propósito de este experimento era demostrar que un agente artificial con valores aparentemente inocuos podría representar una amenaza existencial para la humanidad. El alineación de valores El enfoque es una respuesta al riesgo del agente superinteligente. La investigación de alineación de IA tiene como objetivo dirigir los sistemas de IA hacia los objetivos e intereses previstos de sus diseñadores. En su informe de 2021, Nuestra agenda comúnel Secretario General de la ONU pidió garantizar que la IA esté «alineada con los valores globales compartidos».

Los agentes de IA, sin embargo, son desarrollados por corporaciones tecnológicas. Nuestro problema fundamental no es la maximización del clip, sino la maximización de las ganancias sin regulación. El argumento de Adam Smith en 1759 a favor de la mano invisible del libre mercado fue «promover los intereses de la sociedad en su conjunto». Desde entonces, se ha demostrado que el argumento de que la maximización de ganancias no regulada promueve los intereses de la sociedad en su conjunto, por ejemplo, por parte del ex presidente de la Reserva Federal de EE. UU., Alan Greenspan, falla tanto teóricamentemi y prácticamente.F Si bien la maximización de las ganancias ha generado algunos beneficios sociales impresionantes, por ejemplo, vacunas de ARNm, también ha tenido consecuencias adversas graves, por ejemplo, crisis financieras. En general, la tecnología avanza más rápido que la regulación. El uso no regulado de la IA en publicidad dirigida y moderación de contenido ha generado una profunda polarización en nuestra sociedad, amenazando seriamentegramo democracia.

Así que dejemos de hablar de IA responsable. Nosotros, los profesionales de la computación, todos deberíamos aceptar la responsabilidad. ahoracomenzando con ACM!

Volver arriba

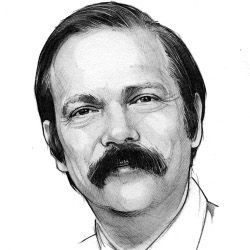

Autor

Moshe Y Vardi (vardi@cs.rice.edu) es Profesor Universitario y Profesor de Servicio Distinguido Karen Ostrum George en Ingeniería Computacional en la Universidad Rice, Houston, TX, EE. UU. Es el ex editor en jefe de Comunicaciones.

Volver arriba

©2023 ACM 0001-0782/23/03

Se otorga permiso para hacer copias digitales o impresas de parte o la totalidad de este trabajo para uso personal o en el aula sin cargo, siempre que las copias no se hagan o distribuyan con fines de lucro o ventaja comercial y que las copias lleven este aviso y la cita completa en la primera página. Deben respetarse los derechos de autor de los componentes de este trabajo que no pertenezcan a ACM. Se permite hacer resúmenes con crédito. Para copiar de otro modo, volver a publicar, publicar en servidores o redistribuir a listas, se requiere un permiso y/o tarifa específicos previos. Solicite permiso para publicar a permisos@acm.org o envíe un fax al (212) 869-0481.

La Biblioteca digital es una publicación de la Association for Computing Machinery. Derechos de autor © 2023 ACM, Inc.

entradas no encontradas