La era de la inteligencia artificial está aquí, y la IA generativa está desempeñando un papel fundamental para traer avances sin precedentes a la tecnología cotidiana. Ya existen varias herramientas de IA gratuitas que pueden ayudarlo a generar imágenes, textos, música, videos increíbles y mucho más en unos pocos segundos. El relleno generativo AI de Adobe en Photoshop y las asombrosas capacidades de Midjourney nos han sorprendido. Pero, ¿qué es exactamente la IA generativa y cómo está impulsando una innovación tan rápida? Para obtener más información, siga nuestro explicador detallado sobre IA generativa.

Definición: ¿Qué es la IA generativa?

Como sugiere el nombre, IA generativa significa un tipo de tecnología de IA que puede generar nuevo contenido en base a los datos con los que ha sido entrenado. Puede generar textos, imágenes, audio, videos y datos sintéticos. La IA generativa puede producir una amplia gama de resultados basados en la entrada del usuario o lo que llamamos «indicaciones». La IA generativa es básicamente un subcampo del aprendizaje automático que puede crear nuevos datos a partir de un conjunto de datos determinado.

Si el modelo ha sido entrenado en grandes volúmenes de texto, puede producir nuevas combinaciones de textos que suenan naturales. Cuanto más grandes sean los datos, mejor será la salida. Si el conjunto de datos se limpió antes del entrenamiento, es probable que obtenga una respuesta matizada.

De manera similar, si ha entrenado un modelo con un gran corpus de imágenes con etiquetado de imágenes, subtítulos y muchos ejemplos visuales, el modelo de IA puede aprende de estos ejemplos y realizar clasificación y generación de imágenes. Este sofisticado sistema de IA programado para aprender de ejemplos se llama red neuronal.

Dicho esto, existen diferentes tipos de modelos de IA generativa. Estas son Redes adversas generativas (GAN), Autocodificador variacional (VAE), Transformadores preentrenados generativos (GPT), modelos autorregresivos, y mucho más. Vamos a discutir brevemente estos modelos generativos a continuación.

Actualmente, modelos GPT se han vuelto populares después del lanzamiento de GPT-4/3.5 (ChatGPT), PaLM 2 (Google Bard), GPT-3 (DALL – E), LLaMA (Meta), Stable Diffusion y otros. Todas estas interfaces de inteligencia artificial fáciles de usar se basan en la arquitectura Transformer. Entonces, en esta explicación, nos centraremos principalmente en IA generativa y GPT (Transformador preentrenado generativo).

¿Cuáles son los diferentes tipos de modelos de IA generativa?

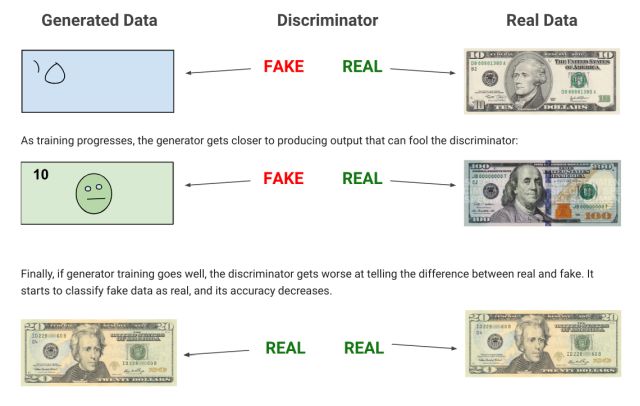

Entre todos los modelos de IA generativa, muchos prefieren GPT, pero comencemos con GAN (Red Adversaria Generativa). En esta arquitectura se entrenan dos redes paralelas, de las cuales una se utiliza para generar contenido (llamado generador) y la otra evalúa el contenido generado (llamado discriminador).

Básicamente, el objetivo es enfrentar dos redes neuronales entre sí para producir resultados que reflejen datos reales. Los modelos basados en GAN se han utilizado principalmente para tareas de generación de imágenes.

A continuación, tenemos el Codificador automático variacional (VAE), que implica el proceso de codificación, aprendizaje, decodificación y generación de contenido. Por ejemplo, si tiene una imagen de un perro, describe la escena como color, tamaño, orejas y más, y luego aprende qué tipo de características tiene un perro. Después de eso, recrea una imagen aproximada usando puntos clave dando una imagen simplificada. Finalmente, genera la imagen final tras añadir más variedad y matices.

Moviéndose a Modelos autorregresivos, está cerca del modelo Transformer pero carece de autoatención. Se usa principalmente para generar textos al producir una secuencia y luego predecir la siguiente parte en función de las secuencias que ha generado hasta el momento. A continuación, también tenemos flujos de normalización y modelos basados en energía. Pero finalmente, vamos a hablar en detalle sobre los populares modelos basados en Transformer a continuación.

¿Qué es un modelo de transformador preentrenado generativo (GPT)?

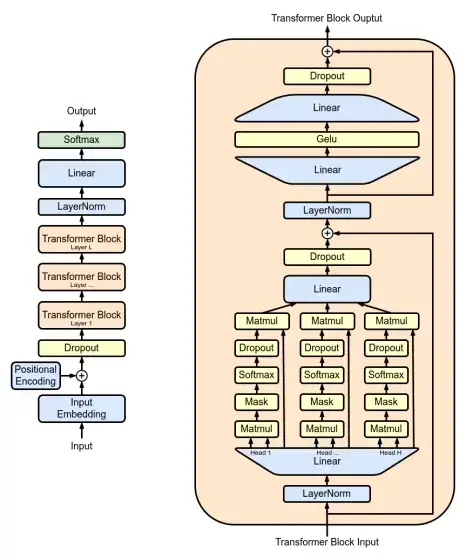

Antes de que llegara la arquitectura Transformer, las redes neuronales recurrentes (RNN) y las redes neuronales convolucionales (CNN) como GAN y VAE se usaban ampliamente para la IA generativa. En 2017, los investigadores que trabajan en Google publicaron un artículo seminal “Atención es todo lo que necesitas” (Vaswani, Uszkoreit, et al., 2017) para avanzar en el campo de la IA generativa y hacer algo así como un modelo de lenguaje grande (LLM).

Google posteriormente lanzó el modelo BERT (Representaciones de codificador bidireccional de Transformers) en 2018 implementando la arquitectura Transformer. Al mismo tiempo, OpenAI lanzó su primer modelo GPT-1 basado en la arquitectura Transformer.

Entonces, ¿cuál fue el ingrediente clave en la arquitectura de Transformer que lo convirtió en un favorito para la IA generativa? Como correctamente se titula el artículo, introdujo la autoatención, que faltaba en arquitecturas de redes neuronales anteriores. Lo que esto significa es que básicamente predice la siguiente palabra en una oración usando un método llamado Transformador. Presta mucha atención a las palabras vecinas para comprender el contexto y establecer una relación entre las palabras.

A través de este proceso, el Transformador desarrolla una comprensión razonable del idioma y utiliza este conocimiento para predecir la siguiente palabra de forma fiable. Todo este proceso se llama el mecanismo de Atención. Dicho esto, tenga en cuenta que los LLM son desdeñosamente llamado Loros estocásticos (Bender, Gebru, et al., 2021) porque el modelo simplemente imita palabras aleatorias basadas en decisiones probabilísticas y patrones que ha aprendido. No determina la siguiente palabra basándose en la lógica y no tiene una comprensión genuina del texto.

Llegando al término «preentrenado» en GPT, significa que el modelo tiene ya ha sido entrenado en una cantidad masiva de datos de texto incluso antes de aplicar el mecanismo de atención. Al entrenar previamente los datos, aprende qué es la estructura de una oración, patrones, hechos, frases, etc. Permite que el modelo obtenga una buena comprensión de cómo funciona la sintaxis del lenguaje.

¿Cómo abordan Google y OpenAI la IA generativa?

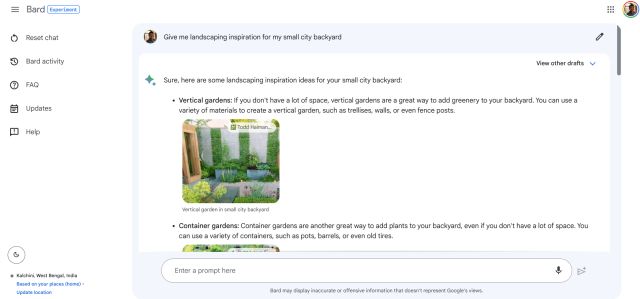

Tanto Google como OpenAI utilizan modelos basados en Transformer en Google Bard y ChatGPT, respectivamente. Sin embargo, hay alguno diferencias clave en el acercamiento. El último modelo PaLM 2 de Google utiliza un codificador bidireccional (mecanismo de autoatención y una red neuronal de avance), lo que significa que pesa en todas las palabras circundantes. Esencialmente trata de entender el contexto de la oración y luego genera todas las palabras a la vez. El enfoque de Google es esencialmente predecir las palabras que faltan en un contexto dado.

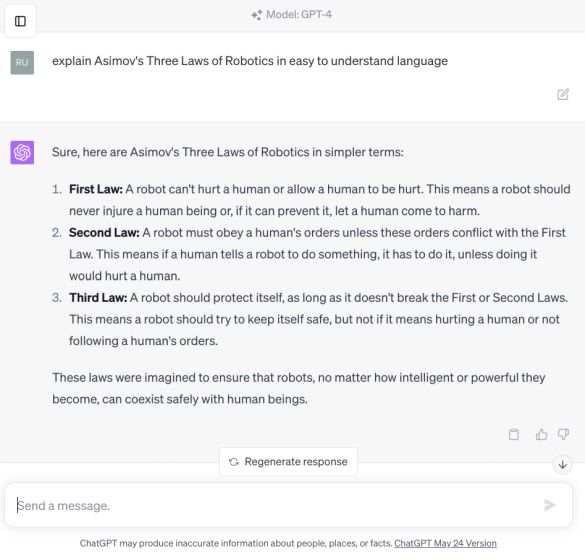

Por el contrario, ChatGPT de OpenAI aprovecha la arquitectura de Transformer para predecir la siguiente palabra en una secuencia: de izquierda a derecha. Es un modelo unidireccional diseñado para generar oraciones coherentes. Continúa la predicción hasta que ha generado una oración completa o un párrafo. Quizás, esa es la razón por la que Google Bard puede generar textos mucho más rápido que ChatGPT. Sin embargo, ambos modelos se basan en la arquitectura Transformer en su núcleo para ofrecer interfaces de IA generativa.

Aplicaciones de la IA Generativa

Todos sabemos que la IA generativa tiene una gran aplicación no solo para texto, sino también para imágenes, videos, generación de audio y mucho más. Los chatbots de IA como ChatGPT, Google Bard, Bing Chat, etc. aprovechan la IA generativa. También se puede utilizar para autocompletar, resumen de textoasistente virtual, traducción, etc. Para generar música, hemos visto ejemplos como Google MusicLM y recientemente Meta lanzó MusicGen para la generación de música.

Aparte de eso, de DALL-E 2 a Stable Diffusion, todos usan IA generativa para crear imágenes realistas a partir de descripciones de texto. En la generación de videos también, los modelos Gen-1, StyleGAN 2 y BigGAN de Runway se basan en las redes adversas generativas para generar videos realistas. Además, la IA generativa tiene aplicaciones en las generaciones de modelos 3D y algunos de los modelos populares son DeepFashion y ShapeNet.

No solo eso, la IA generativa puede ser de gran ayuda en descubrimiento de medicamento también. Puede diseñar nuevos fármacos para una enfermedad específica. Ya hemos visto modelos de descubrimiento de fármacos como AlphaFold, desarrollado por Google DeepMind. Finalmente, la IA generativa se puede usar para el modelado predictivo para pronosticar eventos futuros en finanzas y clima.

Limitaciones de la IA generativa

Si bien la IA generativa tiene capacidades inmensas, no está exenta de fallas. En primer lugar, requiere un gran corpus de datos. entrenar a un modelo. Para muchas pequeñas empresas emergentes, es posible que los datos de alta calidad no estén fácilmente disponibles. Ya hemos visto empresas como Reddit, Stack Overflow y Twitter cerrando el acceso a sus datos o cobrando altas tarifas por el acceso. Recientemente, The Internet Archive informó que su sitio web se había vuelto inaccesible durante una hora porque una startup de IA comenzó a forzar su sitio web para obtener datos de entrenamiento.

Aparte de eso, los modelos de IA generativa también han sido muy criticados por la falta de control y el sesgo. Los modelos de IA entrenados con datos sesgados de Internet pueden representar en exceso una sección de la comunidad. Hemos visto cómo los generadores de fotos de IA en su mayoría renderizan imágenes en tonos de piel más claros. Entonces, hay un gran problema de video deepfake y generación de imágenes utilizando modelos de IA generativa. Como se indicó anteriormente, los modelos de IA generativa no comprenden el significado o el impacto de sus palabras y, por lo general, imitan la salida en función de los datos con los que se ha entrenado.

Es muy probable que, a pesar de los mejores esfuerzos y la alineación, la desinformación, la generación de deepfakes, el jailbreak y sofisticados intentos de phishing Usando su capacidad persuasiva de lenguaje natural, las empresas tendrán dificultades para dominar las limitaciones de la IA generativa.