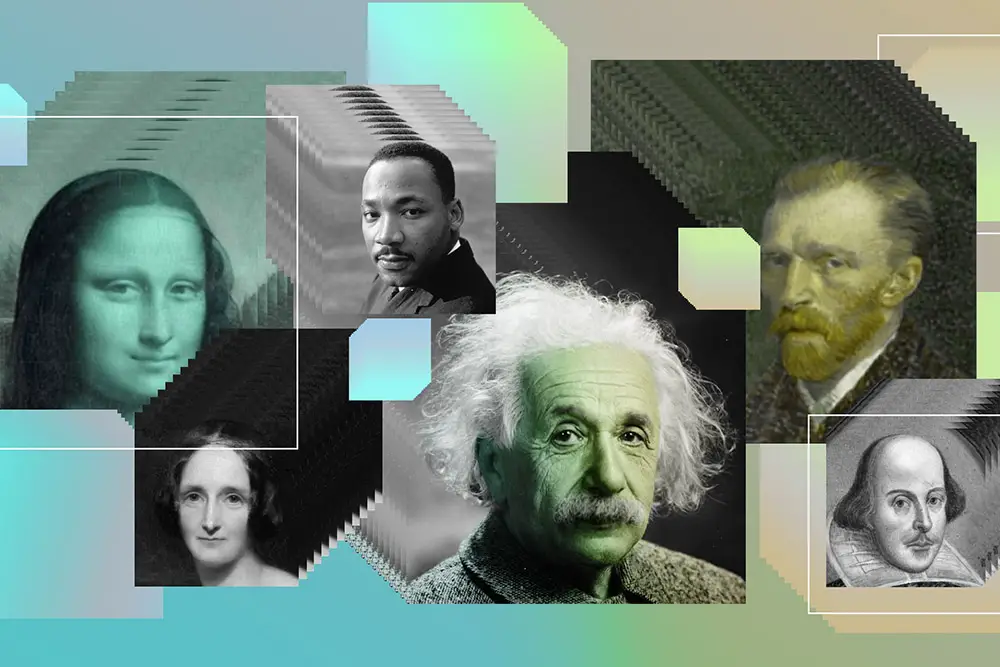

A medida que se vuelve más fácil crear personajes digitales hiperrealistas utilizando inteligencia artificial, gran parte de la conversación en torno a estas herramientas se ha centrado en contenido deepfake engañoso y potencialmente peligroso. Pero la tecnología también se puede utilizar con fines positivos: revivir a Albert Einstein para que enseñe una clase de física, hablar sobre un cambio de carrera con su yo mayor o anonimizar a las personas mientras se conserva la comunicación facial.

Para fomentar las posibilidades positivas de la tecnología, los investigadores del MIT Media Lab y sus colaboradores en la Universidad de California en Santa Bárbara y la Universidad de Osaka han compilado un canal de generación de caracteres de código abierto y fácil de usar que combina modelos de inteligencia artificial para gestos faciales, voz, y movimiento y se puede utilizar para crear una variedad de salidas de audio y video.

La canalización también marca la salida resultante con una marca de agua rastreable, así como legible por humanos, para distinguirlo del contenido de video auténtico y para mostrar cómo se generó, una adición para ayudar a prevenir su uso malicioso.

Al hacer que esta tubería esté fácilmente disponible, los investigadores esperan inspirar a los maestros, estudiantes y trabajadores de la salud a explorar cómo tales herramientas pueden ayudarlos en sus respectivos campos. Si más estudiantes, educadores, trabajadores de la salud y terapeutas tienen la oportunidad de construir y usar estos personajes, los resultados podrían mejorar la salud y el bienestar y contribuir a la educación personalizada, escriben los investigadores en Inteligencia de la máquina de la naturaleza.

“Será un mundo realmente extraño cuando las IA y los humanos comiencen a compartir identidades. Este documento hace un trabajo increíble de liderazgo de pensamiento, trazando el espacio de lo que es posible con personajes generados por IA en dominios que van desde la educación a la salud y las relaciones cercanas, al tiempo que brinda una hoja de ruta tangible sobre cómo evitar los desafíos éticos en torno a la privacidad y la tergiversación. ”, Dice Jeremy Bailenson, director fundador del Laboratorio Virtual de Interacción Humana de Stanford, que no estuvo asociado con el estudio.

Aunque el mundo conoce principalmente la tecnología de los deepfakes, «vemos su potencial como una herramienta para la expresión creativa», dice el primer autor del artículo, Pat Pataranutaporn, estudiante de doctorado en el grupo de investigación Fluid Interfaces de la profesora de tecnología de medios Pattie Maes.

Otros autores del artículo incluyen Maes; El estudiante de maestría de Fluid Interfaces, Valdemar Danry, y la estudiante de doctorado Joanne Leong; El científico investigador del Media Lab, Dan Novy; La profesora asistente de la Universidad de Osaka, Parinya Punpongsanon; y la profesora asistente Misha Sra. de la Universidad de California en Santa Bárbara.

Verdades más profundas y un aprendizaje más profundo

Las redes generativas de adversario, o GAN, una combinación de dos redes neuronales que compiten entre sí, han facilitado la creación de imágenes fotorrealistas, clones de voces y caras animadas. Pataranutaporn, con Danry, exploró por primera vez sus posibilidades en un proyecto llamado Machinoia, donde generó múltiples representaciones alternativas de sí mismo – como niño, como anciano, como mujer – para tener un auto-diálogo de opciones de vida desde diferentes perspectivas. La inusual experiencia de deepfaking lo hizo consciente de su «viaje como persona», dice. “Era una verdad profunda: descubrir algo sobre ti mismo en lo que nunca antes habías pensado, usando tus propios datos sobre ti mismo”.

La autoexploración es solo una de las aplicaciones positivas de los personajes generados por IA, dicen los investigadores. Los experimentos muestran, por ejemplo, que estos personajes pueden hacer que los estudiantes se entusiasmen más con el aprendizaje y mejorar el desempeño de las tareas cognitivas. La tecnología ofrece una manera de que la instrucción sea “personalizada según sus intereses, sus ídolos, su contexto, y se puede cambiar con el tiempo”, explica Pataranutaporn, como complemento de la instrucción tradicional.

Por ejemplo, los investigadores del MIT utilizaron su canalización para crear una versión sintética de Johann Sebastian Bach, que tuvo una conversación en vivo con el renombrado violonchelista Yo Yo Ma en la clase de interfaces musicales del profesor de Media Lab Tod Machover, para el deleite tanto de los estudiantes como de Ma.

Otras aplicaciones pueden incluir personajes que ayudan a brindar terapia, para aliviar la creciente escasez de profesionales de la salud mental y llegar al 44 por ciento estimado de estadounidenses con problemas de salud mental que nunca reciben asesoramiento, o contenido generado por IA que brinda terapia de exposición a personas con ansiedad social. . En un caso de uso relacionado, la tecnología se puede usar para anonimizar rostros en video mientras se preservan las expresiones faciales y las emociones, lo que puede ser útil para sesiones en las que las personas desean compartir información personal sensible, como experiencias de salud y traumas, o para denunciantes y testimonios. .

Pero también hay casos de uso más artísticos y divertidos. En la clase Experiments in Deepfakes de este otoño, dirigida por Maes y el investigador asociado Roy Shilkrot, los estudiantes utilizaron la tecnología para animar las figuras en una pintura china histórica y para crear un «simulador de ruptura» de citas, entre otros proyectos.

Desafíos legales y éticos

Muchas de las aplicaciones de personajes generados por IA plantean problemas legales y éticos que deben discutirse a medida que evoluciona la tecnología, señalan los investigadores en su artículo. Por ejemplo, ¿cómo decidiremos quién tiene derecho a recrear digitalmente un personaje histórico? ¿Quién es legalmente responsable si un clon de IA de una persona famosa promueve un comportamiento dañino en línea? ¿Y existe algún peligro de que prefiramos interactuar con personajes sintéticos antes que con humanos?

“Uno de nuestros objetivos con esta investigación es crear conciencia sobre lo que es posible, hacer preguntas e iniciar conversaciones públicas sobre cómo esta tecnología puede usarse de manera ética para beneficio social. ¿Qué acciones técnicas, legales, políticas y educativas podemos tomar para promover casos de uso positivos mientras reducimos la posibilidad de daño? » afirma Maes.

Al compartir la tecnología ampliamente, mientras la etiqueta claramente como sintetizada, Pataranutaporn dice, «esperamos estimular casos de uso más creativos y positivos, al mismo tiempo que educamos a las personas sobre los posibles beneficios y daños de la tecnología».