ChatGPT come caníbales

La exageración de ChatGPT está comenzando a disminuir, con búsquedas en Google de «ChatGPT» un 40% menos que su pico en abril, mientras que el tráfico web al sitio web ChatGPT de OpenAI ha disminuido casi un 10% en el último mes.

Esto es de esperar; sin embargo, los usuarios de GPT-4 también informan que el modelo parece considerablemente más tonto (pero más rápido) que antes.

Una teoría es que OpenAI lo ha dividido en múltiples modelos más pequeños capacitados en áreas específicas que pueden actuar en conjunto, pero no al mismo nivel.

Pero una posibilidad más intrigante también puede estar jugando un papel: el canibalismo de la IA.

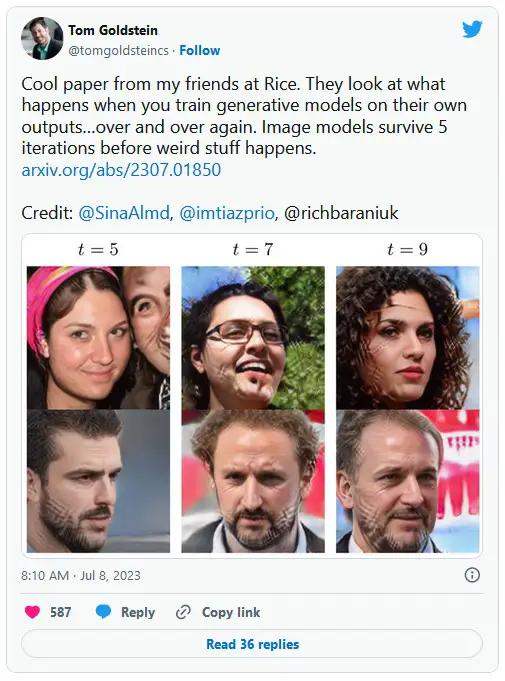

La web ahora está inundada de texto e imágenes generados por IA, y estos datos sintéticos se recopilan como datos para entrenar IA, lo que provoca un ciclo de retroalimentación negativa. Cuantos más datos de IA ingiera un modelo, peor será el resultado en cuanto a coherencia y calidad. Es un poco como lo que pasa cuando haces una fotocopia de una fotocopia, y la imagen va empeorando progresivamente.

Si bien los datos de capacitación oficiales de GPT-4 finalizan en septiembre de 2021, claramente sabe mucho más que eso, y OpenAI cerró recientemente su complemento de navegación web.

Un nuevo artículo de científicos de Rice y la Universidad de Stanford presentó un lindo acrónimo para el problema: Modelo de trastorno de autofagia o MAD.

“Nuestra conclusión principal en todos los escenarios es que sin suficientes datos reales nuevos en cada generación de un bucle autófago, los modelos generativos futuros están condenados a que su calidad (precisión) o diversidad (recuperación) disminuya progresivamente”, dijeron.

Esencialmente, los modelos comienzan a perder los datos más exclusivos pero menos representados y fortalecen sus resultados en datos menos variados, en un proceso continuo. La buena noticia es que esto significa que las IA ahora tienen una razón para mantener a los humanos informados si podemos encontrar una manera de identificar y priorizar el contenido humano para los modelos. Ese es uno de los planes del jefe de OpenAI, Sam Altman, con su proyecto de cadena de bloques de escaneo ocular, Worldcoin.

¿Es Threads solo un líder de pérdida para entrenar modelos de IA?

El clon de Twitter Threads es un movimiento un poco extraño de Mark Zuckerberg, ya que canibaliza a los usuarios de Instagram. La plataforma para compartir fotos gana hasta $ 50 mil millones al año, pero puede ganar alrededor de una décima parte de Threads, incluso en el escenario poco realista de que toma el 100% de la participación de mercado de Twitter. Alex Valaitis de Big Brain Daily predice que se cerrará o se reincorporará a Instagram dentro de 12 meses, y argumenta que la verdadera razón por la que se lanzó ahora «fue para tener más contenido basado en texto para entrenar los modelos de IA de Meta».

ChatGPT fue entrenado en grandes volúmenes de datos de Twitter, pero Elon Musk ha tomado varios pasos impopulares para evitar que eso suceda en el futuro (cobrar por el acceso a la API, limitar la tasa, etc.).

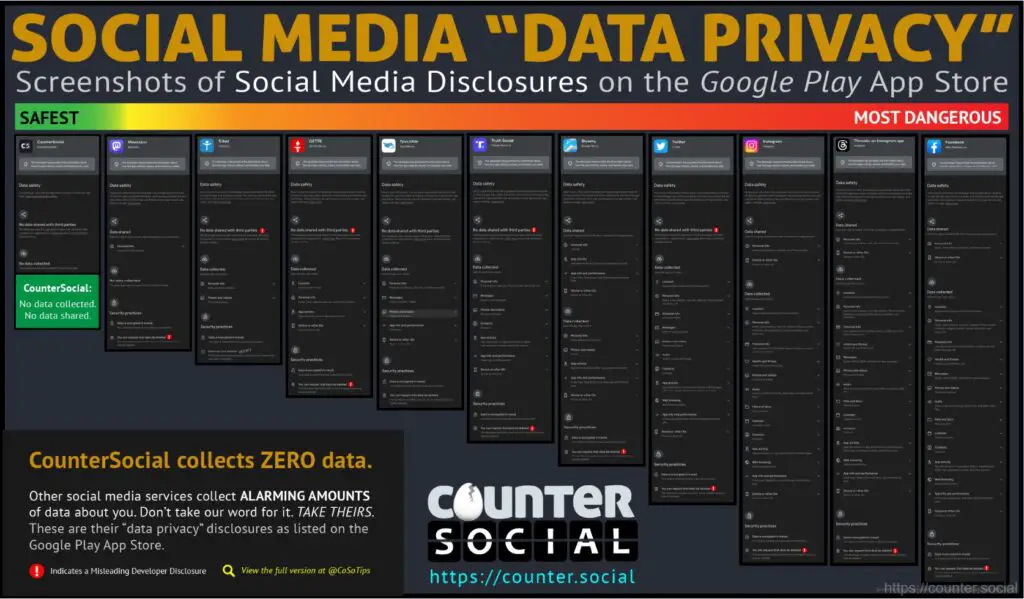

Zuck tiene forma en este sentido, ya que el software de IA de reconocimiento de imágenes SEER de Meta se entrenó en mil millones de fotos publicadas en Instagram. Los usuarios aceptaron eso en la política de privacidad, y muchos han notado que la aplicación Threads recopila datos sobre todo lo posible, desde datos de salud hasta creencias religiosas y raza. Esos datos se utilizarán inevitablemente para entrenar modelos de IA como LLaMA (Large Language Model Meta AI) de Facebook.

Musk, mientras tanto, acaba de lanzar un competidor de OpenAI llamado xAI que extraerá los datos de Twitter para su propio LLM.

Los chatbots religiosos son fundamentalistas

¿Quién hubiera imaginado que entrenar IA en textos religiosos y hablar con la voz de Dios resultaría ser una idea terrible? En India, los chatbots hindúes que se hacen pasar por Krishna han estado advirtiendo constantemente a los usuarios que matar personas está bien si es su dharma o deber.

En los últimos meses han aparecido al menos cinco chatbots entrenados en el Bhagavad Gita, una escritura de 700 versos, pero el gobierno indio no tiene planes de regular la tecnología, a pesar de las preocupaciones éticas.

“Es falta de comunicación, información errónea basada en textos religiosos”, dijo la abogada Lubna Yusuf, con sede en Mumbai, coautora del Libro AI. “Un texto le da mucho valor filosófico a lo que están tratando de decir, y ¿qué hace un bot? Te da una respuesta literal y ese es el peligro aquí”.

Leer también

Características

Préstamos hipotecarios que usan criptomonedas como garantía: ¿los riesgos superan la recompensa?

Características

Bitcoin está en curso de colisión con las promesas de ‘Net Zero’

Doomers de IA versus optimistas de IA

El principal condenador de la IA del mundo, el teórico de la decisión Eliezer Yudkowsky, ha publicado una charla TED advirtiendo que la IA superinteligente nos matará a todos. No está seguro de cómo o por qué, porque cree que un AGI será mucho más inteligente que nosotros y ni siquiera entenderemos cómo y por qué nos está matando, como un campesino medieval tratando de entender el funcionamiento de un acondicionador de aire. Podría matarnos como un efecto secundario de perseguir algún otro objetivo, o porque “no quiere que hagamos otras superinteligencias para competir con él”.

Señala que “Nadie entiende cómo los sistemas modernos de IA hacen lo que hacen. Son matrices gigantes e inescrutables de números de punto flotante”. No espera «ejércitos de robots en marcha con ojos rojos brillantes», pero cree que una «entidad más inteligente e indiferente descubrirá estrategias y tecnologías que pueden matarnos de manera rápida y confiable y luego matarnos». Lo único que podría evitar que ocurra este escenario es una moratoria mundial sobre la tecnología respaldada por la amenaza de la Tercera Guerra Mundial, pero no cree que eso suceda.

En su ensayo “Por qué la IA salvará el mundo”, Marc Andreessen de A16z argumenta que este tipo de posición no es científica: “¿Cuál es la hipótesis comprobable? ¿Qué falsearía la hipótesis? ¿Cómo sabemos cuándo nos estamos metiendo en una zona de peligro? Estas preguntas quedan mayoritariamente sin respuesta aparte de ‘¡No puedes probar que no sucederá!’”

El jefe de Microsoft, Bill Gates, publicó un ensayo propio, titulado «Los riesgos de la IA son reales pero manejables», argumentando que, desde los automóviles hasta Internet, «las personas se las han arreglado en otros momentos transformadores y, a pesar de muchas turbulencias, salen mejor parados». fuera al final.”

“Es la innovación más transformadora que cualquiera de nosotros verá en nuestras vidas, y un debate público saludable dependerá de que todos conozcan la tecnología, sus beneficios y sus riesgos. Los beneficios serán enormes y la mejor razón para creer que podemos manejar los riesgos es que lo hemos hecho antes”.

El científico de datos Jeremy Howard ha publicado su propio artículo, argumentando que cualquier intento de prohibir la tecnología o mantenerla confinada a unos pocos modelos grandes de IA será un desastre, comparando la respuesta basada en el miedo a la IA con la era anterior a la Ilustración cuando la humanidad intentó restringir la educación y el poder a la élite.

Leer también

Características

La teoría de juegos se encuentra con DeFi: Ideas que rebotan en torno al diseño tokenómico

Características

Crypto en Filipinas: la necesidad es la madre de la adopción

“Entonces surgió una nueva idea. ¿Qué pasa si confiamos en el bien general de la sociedad en general? ¿Qué pasaría si todos tuvieran acceso a la educación? ¿A la votación? ¿A la tecnología? Esta fue la Era de la Ilustración”.

Su contrapropuesta es alentar el desarrollo de IA de código abierto y tener fe en que la mayoría de las personas aprovechará la tecnología para siempre.

“La mayoría de la gente usará estos modelos para crear y proteger. ¿Qué mejor para estar seguro que tener la enorme diversidad y experiencia de la sociedad humana en general haciendo todo lo posible para identificar y responder a las amenazas, con todo el poder de la IA detrás de ellas?

Intérprete de código de OpenAI

El nuevo intérprete de código de GPT-4 es una excelente actualización nueva que permite que la IA genere código a pedido y lo ejecute. Entonces, cualquier cosa que puedas soñar, puede generar el código y ejecutarlo. A los usuarios se les han ocurrido varios casos de uso, incluida la carga de informes de la empresa y hacer que la IA genere gráficos útiles de los datos clave, convertir archivos de un formato a otro, crear efectos de video y transformar imágenes fijas en video. Un usuario subió un archivo de Excel de cada ubicación de faro en los EE. UU. y obtuvo GPT-4 para crear un mapa animado de las ubicaciones.

Todo asesino, sin noticias de IA de relleno

— Una investigación de la Universidad de Montana encontró que la inteligencia artificial obtiene puntajes en el 1% superior en una prueba estandarizada de creatividad. Scholastic Testing Service otorgó a las respuestas de GPT-4 las mejores calificaciones en creatividad, fluidez (la capacidad de generar muchas ideas) y originalidad.

— La comediante Sarah Silverman y los autores Christopher Golden y Richard Kadrey están demandando a OpenAI y Meta por violaciones de derechos de autor, por entrenar sus respectivos modelos de IA en los libros del trío.

— AI Copilot para Windows de Microsoft eventualmente será increíble, pero Windows Central descubrió que la vista previa interna es realmente solo Bing Chat ejecutándose a través del navegador Edge y puede activar Bluetooth.

— antrópicoEl competidor de ChatGPT, Claude 2, ahora está disponible de forma gratuita en el Reino Unido y EE. UU., y su ventana de contexto puede manejar 75 000 palabras de contenido frente al máximo de 3000 palabras de ChatGPT. Eso lo hace fantástico para resumir textos largos, y no está mal para escribir ficción.

vídeo de la semana

El canal de noticias satelital indio OTV News ha presentado a su presentadora de noticias de inteligencia artificial llamada Lisa, quien presentará las noticias varias veces al día en una variedad de idiomas, incluidos inglés y odia, para la red y sus plataformas digitales. “Los nuevos presentadores de IA son compuestos digitales creados a partir de imágenes de un anfitrión humano que lee las noticias usando voces sintetizadas”, dijo el director gerente de OTV, Jagi Mangat Panda.

Suscribir

Las lecturas más atractivas en blockchain. Entregado una vez por semana.

andres fenton

Con sede en Melbourne, Andrew Fenton es un periodista y editor que cubre criptomonedas y blockchain. Ha trabajado como escritor de entretenimiento nacional para News Corp Australia, en SA Weekend como periodista de cine y en The Melbourne Weekly.

Sigue al autor @andrewfenton