El avance más reciente y más increíble en el dominio de la inteligencia artificial es el desarrollo de modelos de lenguaje grande (LLM). El muy famoso ChatGPT desarrollado por OpenAI, que se basa en la arquitectura GPT 3.5 y GPT 4, es de gran utilidad y aparece principalmente en los titulares para generar contenido y responder preguntas como lo haría un humano. Su capacidad para imitar a los humanos en la generación de contenido creativo y preciso le permite sumergirse en la resolución de problemas en casi todas las industrias. Con la incorporación de las indicaciones de Chain-of-Thought (CoT), el impacto de los LLM como GPT 3.5 ha mejorado, lo que ha dado lugar a cambios significativos en la industria del procesamiento de la información. CoT mejora los LLM y los ayuda a generar procesos de razonamiento más completos y elaborados en una serie de pasos intermedios.

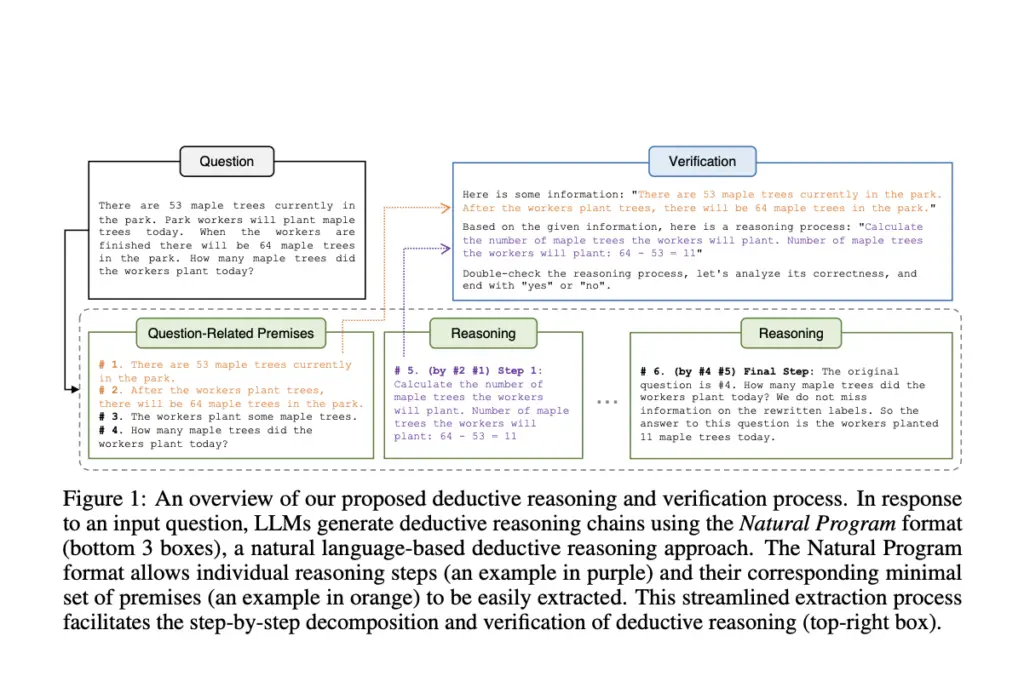

Aunque CoT ofrece muchas ventajas, su énfasis en las fases intermedias de razonamiento ocasionalmente provoca alucinaciones y errores compuestos, lo que dificulta que los modelos generen procesos de razonamiento consistentes y precisos. Se han realizado muchos esfuerzos para permitir que los LLM realicen un razonamiento deductivo explícito y riguroso inspirándose en cómo los humanos se involucran en procedimientos de razonamiento lógico deductivo deliberado para resolver problemas. Para hacer frente a estos desafíos, un equipo de investigadores ha presentado el Programa Natural, un formato de razonamiento deductivo basado en el lenguaje natural que utiliza el poder inherente del lenguaje natural para lograr el razonamiento deductivo.

El equipo ha mencionado que este enfoque divide el proceso de verificación del razonamiento en varios subprocesos secuenciales. Solo se proporciona a cada subproceso el contexto y las premisas requeridas para el paso en particular, y la descomposición hace que el proceso de verificación sea más accesible. Los autores han utilizado modelos de acceso público como GPT-3.5-turbo (175B) de OpenAI para realizar pruebas en conjuntos de datos de aritmética y sentido común para mostrar la eficacia de su técnica de verificación natural basada en programas. Los resultados demostraron qué tan bien funcionó su estrategia para aumentar la confiabilidad de los procesos de razonamiento producidos por grandes modelos de lenguaje.

🚀 ÚNETE a la comunidad subreddit de ML más rápida

El formato de programa natural permite que los modelos de lenguaje generen pasos de razonamiento precisos, lo que garantiza que los pasos posteriores se basen de manera más rigurosa en los pasos anteriores. Los modelos de lenguaje realizan la autoverificación del razonamiento paso a paso utilizando esta estructura, y las etapas de razonamiento resultantes son más rigurosas y confiables ya que se integra un procedimiento de verificación en cada nivel de razonamiento deductivo.

Algunas de las contribuciones clave mencionadas por el equipo son:

- Con la introducción del formato del Programa Natural, el equipo ha propuesto un marco para el razonamiento deductivo riguroso, que es adecuado para la verificación y puede producirse simplemente mediante el aprendizaje en contexto.

- Se ha demostrado que los extensos procesos de razonamiento deductivo escritos en el formato propuesto del Programa Natural pueden autoverificarse de manera confiable mediante el uso de subprocesos paso a paso que solo cubren el contexto y las premisas de requisitos previos.

- A través de experimentos, el equipo ha demostrado la eficacia con la que el marco mejora la precisión, la confiabilidad y la interpretabilidad de las etapas y soluciones de razonamiento generadas por LLM.

En conclusión, este marco parece prometedor para mejorar las capacidades de razonamiento deductivo de los modelos de lenguaje.

Revisar la Papel y Github. No olvides unirte nuestro SubReddit de 24k+ ML, Canal de discordiay Boletín electrónico, donde compartimos las últimas noticias de investigación de IA, interesantes proyectos de IA y más. Si tiene alguna pregunta sobre el artículo anterior o si nos perdimos algo, no dude en enviarnos un correo electrónico a Asif@marktechpost.com

Herramientas destacadas Del club de herramientas de IA

🚀 Echa un vistazo a las herramientas de IA de 100 en AI Tools Club

Tanya Malhotra es estudiante de último año de la Universidad de Estudios de Petróleo y Energía, Dehradun, y cursa BTech en Ingeniería Informática con especialización en Inteligencia Artificial y Aprendizaje Automático.

Es una entusiasta de la ciencia de datos con buen pensamiento analítico y crítico, junto con un gran interés en adquirir nuevas habilidades, liderar grupos y administrar el trabajo de manera organizada.

➡️ Meet Notion: su wiki, documentos y proyectos juntos