En breve

En un pasado no muy lejano, muchos estaban convencidos de que la Inteligencia Artificial (IA) o el Aprendizaje Automático (ML) no cambiarían sustancialmente la práctica del derecho. Se consideró que la profesión legal, por su propia naturaleza, requería habilidades especializadas y un juicio matizado que solo los humanos podían proporcionar y, por lo tanto, serían inmunes a los cambios disruptivos provocados por la transformación digital. Sin embargo, la aplicación de la tecnología ML en el sector legal ahora es cada vez más común, particularmente como una herramienta para ahorrar tiempo a los abogados y proporcionar un análisis más completo de conjuntos de datos cada vez más grandes para ayudar a la toma de decisiones legales en los sistemas judiciales de todo el mundo.

Con más detalle

Un área clave de la aplicación del LA en los sistemas judiciales es la “justicia predictiva”. Esto implica el uso de algoritmos de ML que realizan un análisis probabilístico de cualquier disputa legal en particular utilizando precedentes de jurisprudencia. Para funcionar correctamente, estos sistemas deben apoyarse en enormes bases de datos de decisiones judiciales anteriores que deben traducirse a un lenguaje estandarizado que, a su vez, sea capaz de crear modelos predeterminados. En última instancia, ayudarán al software de aprendizaje automático a generar la predicción.

¿Esta tecnología significa que los juicios terminan a la velocidad de la luz, que los abogados pueden saber de antemano si iniciar o no una demanda, que los tribunales deciden un caso de inmediato? Bueno, todavía queda un largo camino por recorrer y también debemos equilibrar los riesgos inherentes al uso de estas herramientas tecnológicas. Por ejemplo, los datos utilizados para entrenar el sistema ML podrían generar sesgos y consolidar estereotipos y desigualdades que se validarían simplemente porque la IA los produjo varias veces. ¡Cuidado, entonces, con la posible complejidad añadida en la creación de nuevos precedentes y jurisprudencia contra viento y marea!

Para evaluar las oportunidades y los desafíos que presentan los sistemas de justicia predictiva que utilizan herramientas de ML, es instructivo observar ejemplos de jurisprudencia, ya que a menudo la historia es un indicador para comprender el futuro.

Machine Learning en los sistemas judiciales

La primera vez que la “justicia predictiva” empezó a ver la luz fue en Estados Unidos allá por 2013 en Estado contra Loomis donde fue utilizado por el tribunal en el contexto de la sentencia. En ese caso, el Sr. Loomis, un ciudadano estadounidense, fue acusado de conducir un automóvil en un tiroteo, recibir bienes robados y resistirse al arresto. Durante el juicio, el tribunal de circuito fue asistido en su decisión de sentencia por una herramienta de aprendizaje automático predictivo y el resultado final fue que el juez impuso una sentencia privativa de libertad. Aparentemente, el juez estaba convencido por el hecho de que la herramienta de software de aprendizaje automático había sugerido que había una alta probabilidad de que el acusado volviera a delinquir de la misma manera.

En apelación, la Corte Suprema de Wisconsin afirmó la legitimidad del software ya que el juez habría llegado al mismo resultado con o sin el software de aprendizaje automático. La decisión incluyó la determinación de que la evaluación de riesgos proporcionada por el software de IA, aunque no es determinante en sí misma, puede usarse como una herramienta para mejorar la evaluación de un juez, sopesando la aplicación de otras pruebas de sentencia al decidir la sentencia adecuada para un acusado.

En esencia, la Corte Suprema de Wisconsin reconoció la importancia de la función del juez y afirmó que este tipo de software de aprendizaje automático no reemplazaría su función, pero puede usarse para ayudarlo. Como podemos imaginar, este caso abrió la puerta a una nueva forma de impartir justicia.

De hecho, avanzamos rápidamente hasta hoy y leemos noticias de Shanghái que nos cuentan la historia del primer robot jamás creado para analizar archivos de casos y acusar a los acusados en función de una descripción verbal del caso. Los científicos de IA perfeccionaron el robot utilizando una gran cantidad de casos para que la máquina pudiera identificar varios tipos de delitos (es decir, fraude, robo, apuestas) con una precisión del 97 %.

Las predicciones basadas en IA utilizadas para ayudar a los tribunales son cada vez más frecuentes y pueden generar preocupaciones importantes (incluidos el sesgo y la transparencia). Varias autoridades reguladoras están cooperando para promover un conjunto de reglas, principios y orientación para regular las plataformas de IA en los sistemas judiciales y en general.

Por ejemplo, en Europa, se dio un paso significativo hacia la innovación digital en los sistemas judiciales con la creación de la Comisión Europea para la Eficiencia de la Justicia (CEPEJ) que publicó la “Carta Ética Europea sobre el uso de la Inteligencia Artificial en los sistemas judiciales y su medio ambiente”, uno de los primeros documentos normativos sobre IA (“Carta“). La Carta proporciona un conjunto de principios que deben utilizar los legisladores, los profesionales del derecho y los responsables políticos cuando trabajen con herramientas de IA/ML destinadas a garantizar que el uso de la IA en los sistemas judiciales sea compatible con los derechos fundamentales, incluidos los del Convenio Europeo de Derechos Humanos. Derechos y el Convenio para la Protección de las Personas con respecto al Tratamiento Automatizado de Datos Personales.

Recientemente, la CEPEJ ha establecido su Plan de acción 2022 a 2025 para la «Digitalización para una mejor justicia» que identifica un camino de tres pasos destinado a garantizar un uso justo de la IA en los tribunales según la representación visual a continuación:

Fuente: COMISIÓN EUROPEA PARA LA EFICIENCIA DE LA JUSTICIA (CEPEJ) – Hoja de ruta revisada para asegurar un adecuado seguimiento de la Carta Ética de la CEPEJ sobre el uso de la inteligencia artificial en los sistemas judiciales y su entorno.

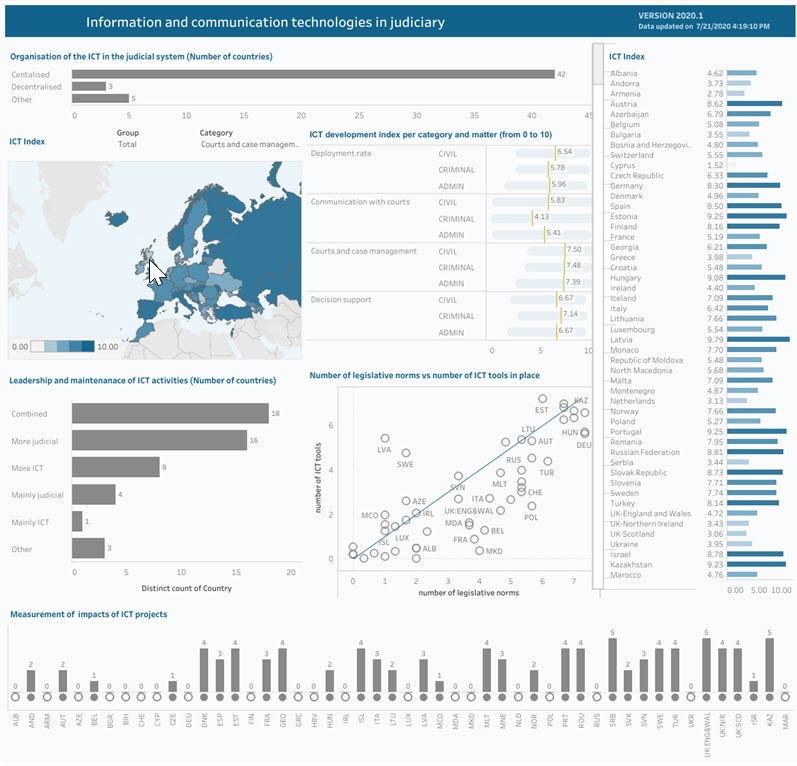

El compromiso de CEPEJ no queda ahí. De hecho, la siguiente tabla muestra un vistazo de cómo las herramientas de tecnología de la información se están imponiendo en los sistemas judiciales de los Estados miembros de la UE (civil y penal) y cómo se está acelerando el uso de TI en los tribunales de la UE.

Fuente: Base de datos dinámica de los sistemas judiciales europeos.

En términos más generales, la Comisión Europea se centra actualmente en el desarrollo de un conjunto de disposiciones para regular los sistemas de IA que se describen en un proyecto de Reglamento de IA («Regulación“) publicado en 2021. El Reglamento propone normas armonizadas para las aplicaciones de los sistemas de IA. Sigue un enfoque proporcional basado en el riesgo que diferencia entre usos prohibidos, de alto riesgo, limitados y de riesgo mínimo de los sistemas de IA. La intervención regulatoria, por lo tanto, aumenta junto con el aumento del potencial de los sistemas algorítmicos para causar daño. Para obtener más información, consulte nuestra alerta Nuevo borrador de normas sobre el uso de la inteligencia artificial.

Los sistemas de IA utilizados para hacer cumplir la ley o en la administración de justicia se definen como sistemas de IA de alto riesgo en virtud del Reglamento. Tenga en cuenta que el uso de sistemas de identificación biométrica en tiempo real en lugares públicos por parte de las fuerzas del orden está prohibido (sujeto a ciertas excepciones). Los sistemas de IA de alto riesgo están sujetos a requisitos, incluida la garantía de la calidad de los conjuntos de datos utilizados para entrenar los sistemas de IA, la aplicación de supervisión humana, la creación de registros para permitir las verificaciones de cumplimiento y el suministro de información relevante a los usuarios. Varias partes interesadas, incluidos proveedores, importadores, distribuidores y usuarios de sistemas de IA, están sujetas a requisitos individuales, incluso en relación con el cumplimiento de los sistemas de IA con los requisitos del Reglamento y el marcado CE de dichos sistemas para indicar la conformidad con el Reglamento.

El Reglamento aún tiene un largo camino por recorrer antes de ser finalmente aprobado y convertirse en vinculante para los Estados miembros, pero ya es un paso adelante en la regulación de la IA, no solo porque puede usarse en la administración de justicia, sino porque también puede impactar profundamente en la forma en que trabajamos, nos comunicamos, jugamos, vivimos en la era digital.

Camila Ambrosino ha ayudado en la preparación de este editorial.

Este artículo se publicó originalmente en la edición de enero de 2022 de LegalBytes.