Imagen por editor

Hemos estado viendo modelos de lenguaje grande (LLM) escupiendo cada semana, con más y más chatbots para que los usemos. Sin embargo, puede ser difícil determinar cuál es el mejor, el progreso de cada uno y cuál es más útil.

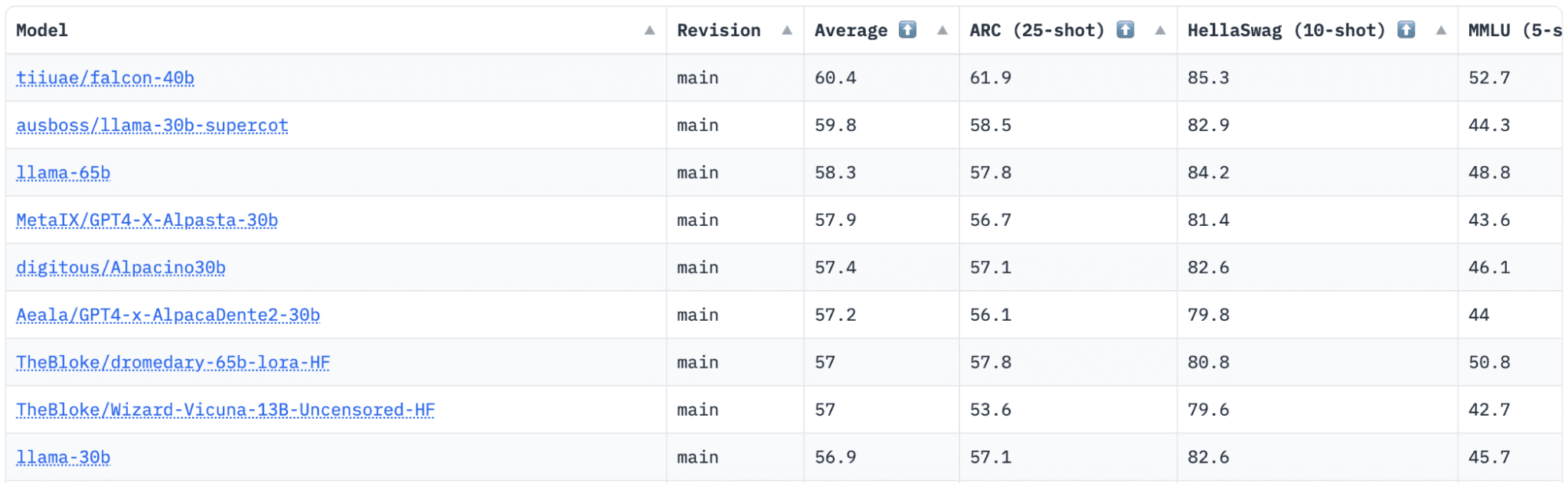

HuggingFace tiene un Open LLM Leaderboard que rastrea, evalúa y clasifica los LLM a medida que se lanzan. Utilizan un marco único que se utiliza para probar modelos de lenguaje generativo en diferentes tareas de evaluación.

Recientemente, LLaMA (Large Language Model Meta AI) estuvo en la cima de la clasificación y recientemente fue destronado por un nuevo LLM pre-entrenado: Falcon 40B.

Imagen de HuggingFace Open LLM Leaderboard

Falcon LLM fue fundado y construido por el Instituto de Innovación Tecnológica (TII), una empresa que forma parte del Consejo de Investigación de Tecnología Avanzada del Gobierno de Abu Dhabi. El gobierno supervisa la investigación tecnológica en la totalidad de los Emiratos Árabes Unidos, donde el equipo de científicos, investigadores e ingenieros se centran en ofrecer tecnologías transformadoras y descubrimientos en la ciencia.

Falcon-40B es un LLM fundamental con parámetros 40B, que se entrena en un billón de tokens. Falcon 40B es un modelo solo de decodificador autorregresivo. Un modelo solo de decodificador autorregresivo significa que el modelo está entrenado para predecir el siguiente token en una secuencia dados los tokens anteriores. El modelo GPT es un buen ejemplo de esto.

Se ha demostrado que la arquitectura de Falcon supera significativamente a GPT-3 por solo el 75 % del presupuesto de cómputo de entrenamiento, además de solo requerir ? del cálculo en el momento de la inferencia.

La calidad de los datos a escala fue un enfoque importante del equipo del Technology Innovation Institute, ya que sabemos que los LLM son muy sensibles a la calidad de los datos de capacitación. El equipo creó una canalización de datos que se escaló a decenas de miles de núcleos de CPU para un procesamiento rápido y pudo extraer contenido de alta calidad de la web mediante filtrado y deduplicación extensivos.

También tienen otra versión más pequeña: Falcon-7B que tiene parámetros 7B, entrenados en tokens 1,500B. Además de los modelos Falcon-40B-Instruct y Falcon-7B-Instruct disponibles, si está buscando un modelo de chat listo para usar.

¿Qué puede hacer Falcon 40B?

Al igual que otros LLM, Falcon 40B puede:

- Genera contenido creativo

- Resolver problemas complejos

- operaciones de servicio al cliente

- asistentes virtuales

- Traducción de idiomas

- Análisis de los sentimientos.

- Reduzca y automatice el trabajo “repetitivo”.

- Ayudar a las empresas emiratíes a ser más eficientes

¿Cómo se entrenó el Falcon 40B?

Al estar capacitado en 1 billón de tokens, requirió 384 GPU en AWS, durante dos meses. Entrenado en 1,000B tokens de RefinedWeb, un conjunto de datos web masivo en inglés creado por TII.

Los datos de preentrenamiento consistieron en una recopilación de datos públicos de la web, utilizando CommonCrawl. El equipo pasó por una fase de filtrado exhaustiva para eliminar el texto generado por la máquina, y se reunió el contenido para adultos, así como cualquier deduplicación para producir un conjunto de datos previo al entrenamiento de casi cinco billones de tokens.

Construido sobre CommonCrawl, el conjunto de datos de RefinedWeb ha demostrado que los modelos logran un mejor rendimiento que los modelos entrenados en conjuntos de datos seleccionados. RefinedWeb también es multimodal.

Una vez que estuvo listo, Falcon se validó con puntos de referencia de código abierto como EAI Harness, HELM y BigBench.

Tienen Falcon LLM de código abierto para el público, lo que hace que Falcon 40B y 7B sean más accesibles para investigadores y desarrolladores, ya que se basa en la versión 2.0 de Apache License.

El LLM, que alguna vez fue solo para investigación y uso comercial, ahora se ha convertido en código abierto para satisfacer la demanda global de acceso inclusivo a la IA. Ahora está libre de regalías por restricciones de uso comercial, ya que los EAU están comprometidos a cambiar los desafíos y los límites dentro de la IA y cómo juega un papel importante en el futuro.

Con el objetivo de cultivar un ecosistema de colaboración, innovación e intercambio de conocimientos en el mundo de la IA, Apache 2.0 garantiza la seguridad y el software de código abierto seguro.

Si desea probar una versión más simple de Falcon-40B que se adapta mejor a las instrucciones genéricas al estilo de un chatbot, debe usar Falcon-7B.

Entonces empecemos…

Si aún no lo ha hecho, instale los siguientes paquetes:

!pip install transformers

!pip install einops

!pip install accelerate

!pip install xformers

Una vez que haya instalado estos paquetes, puede pasar a ejecutar el código provisto para Falcon 7-B Instruct:

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch

model = "tiiuae/falcon-7b-instruct"

tokenizer = AutoTokenizer.from_pretrained(model)

pipeline = transformers.pipeline(

"text-generation",

model=model,

tokenizer=tokenizer,

torch_dtype=torch.bfloat16,

trust_remote_code=True,

device_map="auto",

)

sequences = pipeline(

"Girafatron is obsessed with giraffes, the most glorious animal on the face of this Earth. Giraftron believes all other animals are irrelevant when compared to the glorious majesty of the giraffe.nDaniel: Hello, Girafatron!nGirafatron:",

max_length=200,

do_sample=True,

top_k=10,

num_return_sequences=1,

eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences:

print(f"Result: {seq['generated_text']}")

Falcon, que se erige como el mejor modelo de código abierto disponible, se ha llevado la corona de LLaMA y la gente está sorprendida con su arquitectura altamente optimizada, de código abierto con una licencia única y está disponible en dos tamaños: parámetros 40B y 7B.

¿Has probado? Si es así, háganos saber en los comentarios lo que piensa.

nisha aria es científico de datos, escritor técnico independiente y administrador de la comunidad en KDnuggets. Ella está particularmente interesada en proporcionar consejos o tutoriales sobre la carrera de Data Science y conocimiento basado en la teoría sobre Data Science. También desea explorar las diferentes formas en que la Inteligencia Artificial es o puede beneficiar la longevidad de la vida humana. Una estudiante entusiasta que busca ampliar sus conocimientos tecnológicos y sus habilidades de escritura, mientras ayuda a guiar a otros.