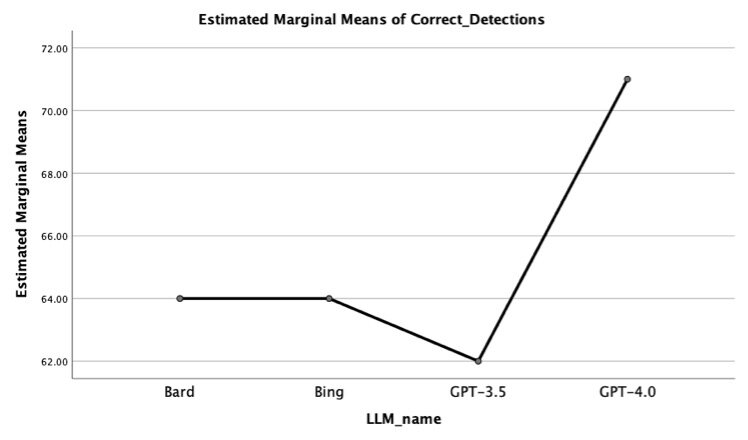

Gráfico que resume el resultado del estudio Crédito: Kevin Matthe Caramancion

Los modelos de lenguaje extenso (LLM) son una evolución de las técnicas de procesamiento de lenguaje natural (NLP) que pueden generar rápidamente textos muy parecidos a los escritos por humanos y completar otras tareas simples relacionadas con el lenguaje. Estos modelos se han vuelto cada vez más populares después del lanzamiento público de Chat GPT, un LLM de alto rendimiento desarrollado por OpenAI.

Los estudios recientes que evalúan los LLM hasta ahora han probado principalmente su capacidad para crear textos bien escritos, definir términos específicos, escribir ensayos u otros documentos y producir códigos de computadora efectivos. No obstante, estos modelos podrían ayudar potencialmente a los humanos a abordar varios otros problemas del mundo real, incluidas las noticias falsas y la información errónea.

Kevin Matthe Caramancion, investigador de la Universidad de Wisconsin-Stout, llevó a cabo recientemente un estudio que evalúa la capacidad de los LLM más conocidos publicados hasta la fecha para detectar si una noticia es verdadera o falsa. Sus hallazgos, en un artículo en el servidor de preimpresión arXivofrece información valiosa que podría contribuir al uso futuro de estos modelos sofisticados para contrarrestar la desinformación en línea.

«La inspiración para mi artículo reciente surgió de la necesidad de comprender las capacidades y limitaciones de varios LLM en la lucha contra la desinformación», dijo Caramancion a Tech Xplore. «Mi objetivo era probar rigurosamente la competencia de estos modelos para distinguir los hechos de la fabricación, utilizando una simulación controlada y agencias de verificación de hechos establecidas como punto de referencia».

«Evaluamos el desempeño de estos grandes modelos de lenguaje utilizando un conjunto de pruebas de 100 noticias verificadas por agencias independientes de verificación de hechos», dijo Caramancion. «Presentamos cada una de estas noticias a los modelos bajo condiciones controladas y luego clasificamos sus respuestas en una de tres categorías: verdadero, falso y parcialmente verdadero/falso. La efectividad de los modelos se midió en función de la precisión con la que clasificaron estos elementos. en comparación con los hechos verificados proporcionados por las agencias independientes».

La desinformación se ha convertido en un desafío crucial en las últimas décadas, ya que Internet y las redes sociales han permitido la difusión cada vez más rápida de información, independientemente de si es verdadera o falsa. Por lo tanto, muchos científicos informáticos han estado tratando de diseñar mejores herramientas y plataformas de verificación de hechos que permitan a los usuarios verificar las noticias que leen en línea.

A pesar de las muchas herramientas de verificación de hechos creadas y probadas hasta la fecha, todavía falta un modelo confiable y ampliamente adoptado para combatir la desinformación. Como parte de su estudio, Caramancion se dispuso a determinar si los LLM existentes podrían abordar de manera efectiva este problema mundial.

Específicamente evaluó el desempeño de cuatro LLM, a saber, Chat GPT-3.0 y Chat GPT-4.0 de Open AI, Bard/LaMDA de Google y Bing AI de Microsoft. Caramanción alimentó a estos modelos con las mismas noticias, que previamente fueron verificadas y luego compararon su capacidad para determinar si eran verdaderas, falsas o parcialmente verdaderas/falsas.

«Realizamos una evaluación comparativa de los principales LLM en su capacidad para diferenciar los hechos del engaño», dijo Caramancion. «Descubrimos que GPT-4.0 de OpenAI superó a los demás, lo que sugiere los avances en los LLM más nuevos. Sin embargo, todos los modelos quedaron rezagados con respecto a los verificadores de hechos humanos, lo que enfatiza el valor insustituible de la cognición humana. Estos hallazgos podrían conducir a un mayor enfoque en el desarrollo de las capacidades de IA en el campo de la verificación de hechos al tiempo que garantiza una integración simbiótica y equilibrada con las habilidades humanas».

La evaluación realizada por Caramancion mostró que ChatGPT 4.0 supera significativamente a otros LLM destacados en tareas de verificación de hechos. Otros estudios que prueben los LLM en un grupo más amplio de noticias falsas podrían ayudar a verificar este hallazgo.

El investigador también descubrió que los verificadores de hechos humanos aún superan a todos los LLM primarios que evaluó. Su trabajo destaca la necesidad de mejorar aún más estos modelos o combinarlos con el trabajo de agentes humanos si se van a aplicar a la verificación de hechos.

«Mis planes de investigación futuros giran en torno al estudio de la progresión de las capacidades de la IA, centrándose en cómo podemos aprovechar estos avances sin pasar por alto las capacidades cognitivas únicas de los humanos», agregó Caramancion. «Nuestro objetivo es refinar nuestros protocolos de prueba, explorar nuevos LLM e investigar más a fondo la dinámica entre la cognición humana y la tecnología de inteligencia artificial en el dominio de la verificación de noticias».

Más información:

Kevin Matthe Caramancion, News Verifiers Showdown: una evaluación comparativa del rendimiento de ChatGPT 3.5, ChatGPT 4.0, Bing AI y Bard en News Fact-Checking, arXiv (2023). DOI: 10.48550/arxiv.2306.17176

arXiv

© 2023 Ciencia X Red

Citación: Evaluación de la capacidad de ChatGPT y otros modelos de lenguaje extenso para detectar noticias falsas (17 de julio de 2023) consultado el 17 de julio de 2023 en https://techxplore.com/news/2023-07-ability-chatgpt-large-language-fake. html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.