ISaac Newton descubrió apócrifamente su segunda ley, la de la gravedad, después de que una manzana cayera sobre su cabeza. Después de mucha experimentación y análisis de datos, se dio cuenta de que había una relación fundamental entre la fuerza, la masa y la aceleración. Formuló una teoría para describir esa relación, una que podría expresarse como una ecuación, F=ma, y la usó para predecir el comportamiento de otros objetos además de las manzanas. Sus predicciones resultaron ser correctas (aunque no siempre lo suficientemente precisas para los que vinieron después).

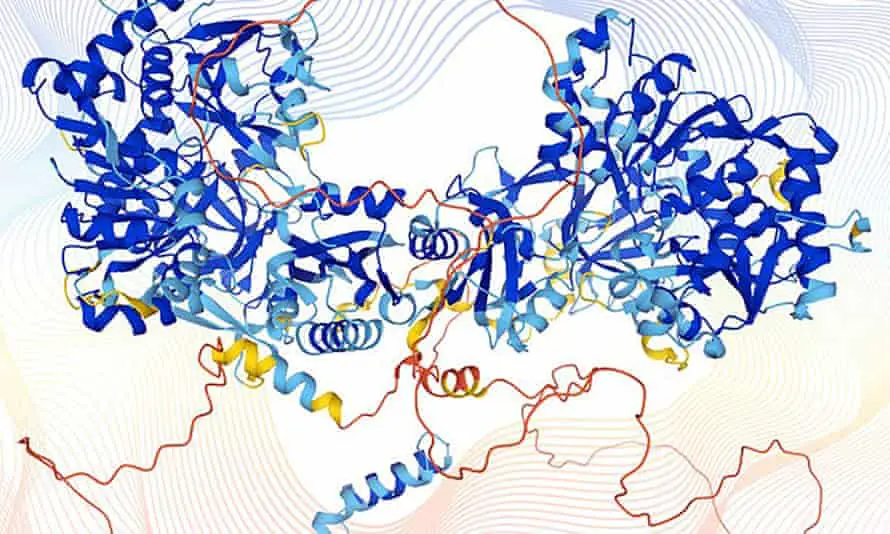

Compare cómo la ciencia se hace cada vez más en la actualidad. Las herramientas de aprendizaje automático de Facebook predicen tus preferencias mejor que cualquier psicólogo. AlphaFold, un programa construido por DeepMind, ha producido las predicciones más precisas hasta el momento de las estructuras de proteínas basadas en los aminoácidos que contienen. Ambos guardan silencio total sobre por qué funcionan: por qué prefieres esta o aquella información; por qué esta secuencia genera esa estructura.

No puedes levantar una cortina y mirar dentro del mecanismo. No ofrecen ninguna explicación, ningún conjunto de reglas para convertir esto en aquello; ninguna teoría, en una palabra. Simplemente funcionan y lo hacen muy bien. Somos testigos de los efectos sociales de las predicciones de Facebook a diario. AlphaFold aún no ha dejado sentir su impacto, pero muchos están convencidos de que cambiará la medicina.

En algún lugar entre Newton y Mark Zuckerberg, la teoría pasó a un segundo plano. En 2008, Chris Anderson, el entonces editor en jefe de cableado revista, predijo su desaparición. Se habían acumulado tantos datos, argumentó, y las computadoras ya eran mucho mejores que nosotros para encontrar relaciones dentro de ellos, que nuestras teorías estaban siendo expuestas por lo que eran: simplificaciones excesivas de la realidad. Pronto, el viejo método científico (hipótesis, predicción, prueba) sería relegado al basurero de la historia. Dejaríamos de buscar las causas de las cosas y nos contentaríamos con las correlaciones.

Con el beneficio de la retrospectiva, podemos decir que lo que vio Anderson es cierto (no estaba solo). La complejidad que nos ha revelado esta riqueza de datos no puede ser capturada por la teoría tal como se entiende tradicionalmente. “Hemos superado nuestra capacidad para escribir incluso las teorías que serán útiles para la descripción”, dice el neurocientífico computacional Peter Dayan, director del Instituto Max Planck de Cibernética Biológica en Tübingen, Alemania. “Ni siquiera sabemos cómo se verían”.

Pero la predicción de Anderson sobre el final de la teoría parece haber sido prematura, o tal vez su tesis fue en sí misma una simplificación excesiva. Hay varias razones por las que la teoría se niega a morir, a pesar de los éxitos de los motores de predicción sin teoría como Facebook y AlphaFold. Todos son esclarecedores, porque nos obligan a preguntar: ¿cuál es la mejor manera de adquirir conocimiento y hacia dónde va la ciencia a partir de aquí?

La primera razón es que nos hemos dado cuenta de que las inteligencias artificiales (IA), en particular una forma de aprendizaje automático llamada redes neuronales, que aprenden de los datos sin tener que recibir instrucciones explícitas, son en sí mismas falibles. Piense en el prejuicio que se ha documentado en los motores de búsqueda de Google y las herramientas de contratación de Amazon.

La segunda es que los humanos se sienten profundamente incómodos con la ciencia libre de teorías. No nos gusta lidiar con una caja negra, queremos saber por qué.

Y en tercer lugar, todavía puede haber muchas teorías del tipo tradicional, es decir, comprensibles para los humanos, que explican mucho de manera útil pero aún no se han descubierto.

Así que la teoría aún no está muerta, pero está cambiando, tal vez más allá del reconocimiento. “Las teorías que tienen sentido cuando tienes grandes cantidades de datos se ven bastante diferentes de aquellas que tienen sentido cuando tienes pequeñas cantidades”, dice Tom Griffiths, psicólogo de la Universidad de Princeton.

Griffiths ha estado usando redes neuronales para ayudarlo a mejorar las teorías existentes en su dominio, que es la toma de decisiones humana. Una teoría popular de cómo las personas toman decisiones cuando hay riesgo económico es la teoría de las perspectivas, que fue formulada por los economistas conductuales Daniel Kahneman y Amos Tversky en la década de 1970 (luego Kahneman ganó un premio Nobel). La idea central es que las personas a veces, pero no siempre, son racionales.

En Ciencias En junio pasado, el grupo de Griffiths describió cómo entrenaron una red neuronal en un vasto conjunto de datos de decisiones que las personas tomaron en 10,000 escenarios de elección arriesgada, luego compararon la precisión con la que predijo futuras decisiones con respecto a la teoría prospectiva. Descubrieron que la teoría prospectiva funcionaba bastante bien, pero la red neuronal mostró su valor al resaltar dónde fallaba la teoría, es decir, dónde fallaban sus predicciones.

Estos contraejemplos fueron muy informativos, dice Griffiths, porque revelaron más de la complejidad que existe en la vida real. Por ejemplo, los humanos sopesan constantemente las probabilidades en función de la información entrante, como describe la teoría de la perspectiva. Pero cuando hay demasiadas probabilidades en competencia para que el cerebro las calcule, es posible que cambien a una estrategia diferente, guiándose por una regla general, por ejemplo, y la regla general de un corredor de bolsa podría no ser la misma que la de un comerciante adolescente de bitcoins. , ya que se extrae de diferentes experiencias.

“Básicamente estamos usando el sistema de aprendizaje automático para identificar aquellos casos en los que estamos viendo algo que es inconsistente con nuestra teoría”, dice Griffiths. Cuanto más grande es el conjunto de datos, más inconsistencias aprende la IA. El resultado final no es una teoría en el sentido tradicional de una afirmación precisa sobre cómo las personas toman decisiones, sino un conjunto de afirmaciones sujetas a ciertas restricciones. Una forma de imaginarlo podría ser como un árbol ramificado de reglas del tipo «si… entonces», que es difícil de describir matemáticamente, y mucho menos con palabras.

Lo que los psicólogos de Princeton están descubriendo todavía se puede explicar, por extensión, a partir de las teorías existentes. Pero a medida que revelan más y más complejidad, será menos; la culminación lógica de ese proceso son los motores predictivos sin teoría incorporados por Facebook o AlphaFold.

Algunos científicos se sienten cómodos con eso, incluso ansiosos por ello. Cuando el pionero del software de reconocimiento de voz, Frederick Jelinek, dijo: «Cada vez que despido a un lingüista, el rendimiento del reconocedor de voz aumenta», quiso decir que la teoría estaba frenando el progreso, y eso fue en la década de 1980.

O tomar estructuras de proteínas. La función de una proteína está determinada en gran medida por su estructura, por lo que si desea diseñar un fármaco que bloquee o mejore la acción de una proteína determinada, debe conocer su estructura. AlphaFold se entrenó en estructuras que se derivaron experimentalmente, utilizando técnicas como la cristalografía de rayos X y, en este momento, sus predicciones se consideran más confiables para proteínas donde hay algunos datos experimentales disponibles que para aquellas donde no los hay. Pero su confiabilidad está mejorando todo el tiempo, dice Janet Thornton, ex directora del Instituto Europeo de Bioinformática EMBL (EMBL-EBI) cerca de Cambridge, y no es la falta de una teoría lo que impedirá que los diseñadores de fármacos lo usen. “Lo que hace AlphaFold también es descubrir”, dice, “y solo mejorará nuestra comprensión de la vida y la terapéutica”.

Otros se sienten claramente menos cómodos con el rumbo que toma la ciencia. Los críticos señalan, por ejemplo, que las redes neuronales pueden arrojar correlaciones falsas, especialmente si los conjuntos de datos en los que se entrenan son pequeños. Y todos los conjuntos de datos están sesgados, porque los científicos no recopilan datos de manera uniforme o neutral, sino siempre con ciertas hipótesis o suposiciones en mente, suposiciones que se abrieron paso de manera perjudicial en las IA de Google y Amazon. Como explica la filósofa de la ciencia Sabina Leonelli de la Universidad de Exeter: «El panorama de datos que estamos utilizando es increíblemente sesgado».

Pero aunque estos problemas ciertamente existen, Dayan no cree que sean insuperables. Señala que los humanos también están sesgados y, a diferencia de las IA, «en formas que son muy difíciles de interrogar o corregir». En última instancia, si una teoría produce predicciones menos confiables que una IA, será difícil argumentar que la máquina es la más sesgada de las dos.

Un obstáculo más difícil para la nueva ciencia puede ser nuestra necesidad humana de explicar el mundo, de hablar en términos de causa y efecto. En 2019, los neurocientíficos Bingni Brunton y Michael Beyeler de la Universidad de Washington, Seattle, escribieron que esta necesidad de interpretabilidad puede haber impedido a los científicos obtener nuevos conocimientos sobre el cerebro, del tipo que solo surge de grandes conjuntos de datos. Pero también se solidarizaron. Si esos conocimientos se van a traducir en cosas útiles, como medicamentos y dispositivos, escribieron, «es imperativo que los modelos computacionales produzcan conocimientos que sean explicables y confiables para los médicos, los usuarios finales y la industria».

La «IA explicable», que aborda cómo cerrar la brecha de interpretabilidad, se ha convertido en un tema candente. Pero esa brecha solo se ampliará y, en cambio, podríamos enfrentarnos a una compensación: ¿cuánta previsibilidad estamos dispuestos a sacrificar por la interpretabilidad?

Sumit Chopra, un científico de inteligencia artificial que piensa en la aplicación del aprendizaje automático a la atención médica en la Universidad de Nueva York, da el ejemplo de una imagen de resonancia magnética. Se necesitan muchos datos sin procesar, y por lo tanto tiempo de escaneo, para producir una imagen de este tipo, que no es necesariamente el mejor uso de esos datos si su objetivo es detectar con precisión, por ejemplo, el cáncer. Podría entrenar una IA para identificar qué porción más pequeña de los datos sin procesar es suficiente para producir un diagnóstico preciso, validado por otros métodos, y de hecho el grupo de Chopra lo ha hecho. Pero los radiólogos y los pacientes siguen apegados a la imagen. “Los humanos nos sentimos más cómodos con una imagen 2D que nuestros ojos pueden interpretar”, dice.

La objeción final a la ciencia posterior a la teoría es que es probable que exista una teoría útil al estilo antiguo, es decir, generalizaciones extraídas de ejemplos discretos, que aún está por descubrir y solo los humanos pueden hacer eso porque requiere intuición. En otras palabras, requiere una especie de búsqueda instintiva de aquellas propiedades de los ejemplos que son relevantes para la regla general. Una razón por la que consideramos brillante a Newton es que para llegar a su segunda ley tuvo que ignorar algunos datos. Tenía que imaginar, por ejemplo, que las cosas caían en el vacío, libres de los efectos de interferencia de la resistencia del aire.

En Naturaleza el mes pasado, el matemático Christian Stump, de la Ruhr University Bochum en Alemania, llamó a este paso intuitivo “el núcleo del proceso creativo”. Pero la razón por la que estaba escribiendo sobre eso era para decir que, por primera vez, una IA lo había logrado. DeepMind había construido un programa de aprendizaje automático que había llevado a los matemáticos hacia nuevos conocimientos, nuevas generalizaciones, en las matemáticas de los nudos.

En 2022, por lo tanto, casi no hay etapa del proceso científico en la que la IA no haya dejado su huella. Y cuanto más lo atraemos a nuestra búsqueda de conocimiento, más cambia esa búsqueda. Tendremos que aprender a vivir con eso, pero podemos estar seguros de una cosa: todavía estamos haciendo las preguntas. Como dijo Pablo Picasso en la década de 1960, “las computadoras son inútiles. Solo pueden darte respuestas”.