Actualmente, los métodos de aprendizaje automático están experimentando un desarrollo explosivo. No dejan de aparecer nuevas ideas y soluciones, que en muchos ámbitos ya han puesto patas arriba las reglas del juego para que las redes neuronales superen a los humanos. Por ejemplo, las redes neuronales gráficas, si bien aún no han sido reemplazadas por los artistas, se hicieron cargo de al menos parte de su trabajo rutinario, especialmente en la industria de los juegos de computadora. ChatGPT es una amenaza para los redactores publicitarios y muchas otras profesiones, desde abogados hasta maestros.

Un impacto significativo en el rápido crecimiento en el campo del aprendizaje automático lo proporcionan varios concursos que se llevan a cabo en diferentes áreas del conocimiento. A menudo, los ganadores de la competencia reciben un importante premio en efectivo, pero no es raro que no implique apoyo financiero. Para un equipo, la participación en tales competencias puede ser solo una oportunidad para obtener nuevos conocimientos, obtener exposición y obtener acceso a un buen conjunto de datos en esta o aquella área.

Concursos de aprendizaje automático

Entonces, ¿dónde tienen lugar estas competiciones? Todo el mundo conoce los concursos en la plataforma multitemática kaggle.com, pero hay otros. De entrada, podemos nombrar trustii.io, codalab, bitgrit.net y eval.ai. Además, varias plataformas tienen su propia especialización. Por ejemplo, aicrowd.com ydrivendata.org se posicionan como competencias de aprendizaje automático con impacto social, mientras que xeek.ai se dedica a la geociencia y miccai.org a la computación de imágenes médicas, CrunchDAO.com analiza los mercados financieros y zindi.africa es una competición relacionada con el continente africano. Algunos concursos se realizan en el marco de congresos científicos, como NeurIPS. Incluso hay sitios como mlcontests.com que reúnen las competencias más interesantes en todas las plataformas.

Desafío VOT

En este blog, le presentaremos una competencia de ML no muy conocida (pero bastante interesante). Si está investigando en el campo de la visión por computadora, probablemente se haya encontrado con VOTXXXX Benchmarks. Estos son los resultados de The Visual Object Tracking Challenge (VOT Challenge; votchallenge.net).

Este desafío tiene lugar en primavera y verano y está relacionado con el desarrollo de algoritmos para rastrear objetos en videos. Su lado fuerte es que proporciona un marco estandarizado para evaluar y comparar algoritmos de seguimiento al proporcionar un conjunto de datos de videos anotados con anotaciones. Están disponibles una biblioteca preparada y preparaciones de casos de prueba adaptadas para Python y Matlab. Además, hay documentación bastante detallada; hay disponibles ejemplos de rastreadores de competencias anteriores, y los organizadores se comunican activamente con la comunidad a través de foros y listas de correo.

Al mismo tiempo, el desafío está dirigido a los entusiastas: no hay valor de premio excepto la oportunidad de convertirse en coautor o ser mencionado en la publicación anual basada en los resultados de la competencia.

volver al pasado

Ahora, solo unas pocas palabras sobre la historia de la competencia y sus características específicas.

2013: La idea de la competencia surgió de la ausencia de una evaluación estándar para los rastreadores de objetos visuales. Se necesitaba con urgencia una metodología de evaluación para el seguimiento visual de objetos. Para esto, se crearon un pequeño conjunto de datos anotados y un conjunto de herramientas de evaluación dedicado, y este último se desarrolló específicamente para el desafío, que se llevó a cabo como parte de la conferencia ICCV2013.

2014: El kit de herramientas de evaluación obtuvo el protocolo de integración TraX que ofrecía más libertad para la integración y rastreadores de ejecución más rápidos. El conjunto de datos se amplió.

2015: Se agregaron nuevas medidas de evaluación: robustez y precisión. El conjunto de datos se incrementó aún más y se anunció el subdesafío de seguimiento basado en imágenes térmicas.

2016-2019: Se desarrolló el desafío, se modificó el procedimiento de anotación, aparecieron nuevos sub-desafíos, incluidos los relacionados con el seguimiento a largo plazo y las secuencias multimodales. Los conjuntos de datos siguieron desarrollándose y, entre ellos, había conjuntos de datos basados en imágenes térmicas e imágenes RGB+profundidad.

2020-2021: El kit de herramientas de evaluación finalmente se implementó en Python, lo que abrió la posibilidad de que participaran nuevos equipos. Además, los organizadores se dedicaron a la complicación de conjuntos de datos, eliminando y reemplazando secuencias simples de imágenes.

2022: El desafío VOT se caracterizó por una gran cantidad de sub-desafíos especializados. El énfasis se puso en diferentes variaciones de rastreadores a corto plazo y un rastreador a largo plazo. Se desarrolló una tarea de localización que utilizaba una máscara de segmentación y no solo un cuadro delimitador.

2023 (actual)

Este año, los organizadores cambiaron drásticamente las reglas del juego, lo que afectó los resultados de muchos participantes. Solo se propuso una tarea para la competencia que, de hecho, cubría todas las subtareas proporcionadas anteriormente: era necesario predecir pistas a largo plazo en video RGB para objetos dados arbitrariamente. El objeto estaba marcado con una máscara solo en el primer cuadro del video.

El conjunto de datos también se ha renovado por completo. En el conjunto de validación, cuatro videos y nueve objetos para seguimiento estaban disponibles con marcado completo, y el conjunto de prueba contenía 144 videos y un total de más de 200 000 fotogramas.

Los videos fueron bastante diversos; diferían en las siguientes características:

- Distintas resoluciones, desde 180 х 320 hasta 1920 х 1080. De estos, 94 videos tenían una resolución de 1280 х 720.

- Múltiples objetos para rastrear en video: del 1 al 8.

- Muchos videos largos. Número promedio de fotogramas por video: 2073; número máximo de fotogramas: 10.699 (es decir, más de siete minutos).

- Algunos videos tenían muchos objetos muy similares (cebras, pelotas, etc.) que debían rastrearse de forma independiente.

- Había muchas escenas dinámicas con movimiento de cámara activo.

- Muy a menudo, hubo escenarios en los que un objeto desapareció durante bastante tiempo y luego reapareció.

- Hubo algunos videos con un objeto muy pequeño para rastrear.

- A juzgar por los videos de validación, las máscaras de verdad en tierra no describieron con precisión el objeto de seguimiento.

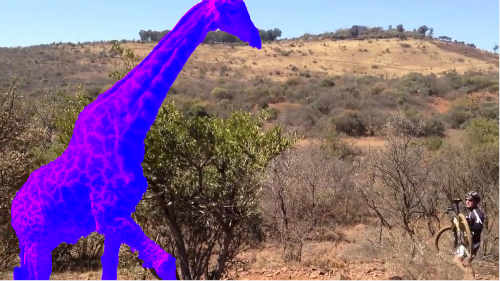

Ejemplo: primeros cuadros en cuatro videos de validación con uno de los objetos para el seguimiento (el objeto de destino está marcado en púrpura):

Los organizadores sugirieron utilizar una métrica especializada, que es muy diferente de las generalmente aceptadas. Se llama Calidad y es la base para los cálculos de LeaderBoard. Hay algunas métricas adicionales: precisión, solidez, etc. Los organizadores del desafío describieron las métricas en detalle en el siguiente documento: https://data.votchallenge.net/vots2023/measures.pdf

Nuestra solución

Hemos seguido este desafío desde el principio, sin embargo, no podíamos prestarle suficiente atención todos los años porque se lleva a cabo en el momento de la sesión «más caliente» para los docentes universitarios. Sin embargo, analizamos casos exitosos y tareas de la competencia y los usamos para capacitar a los estudiantes y realizar nuestras competencias locales.

Este año armamos un equipo y decidimos participar en la competencia a lo grande. En primer lugar, acordamos la siguiente estrategia: no utilizaremos soluciones listas de concursos anteriores; todo lo contrario, deberíamos tratar de aplicar herramientas novedosas que se hayan desarrollado recientemente.

Tomamos la nueva red de Facebook «Segment Anything» [Kirillov A. et al. Segment anything //arXiv preprint arXiv:2304.02643. 2023, https://github.com/facebookresearch/segment-anything] para la segmentación intelectual de la imagen inicial. Después de crear una partición para compararla con el objeto original para el seguimiento, usamos la red neuronal Open CLIP [Radford A. et al. Learning transferable visual models from natural language supervision. International conference on machine learning. PMLR, 2021. Pp. 8748-8763, https://github.com/mlfoundations/open_clip]. Esta red se desempeñó bien en la competencia Google Universal Image Embedding [https://www.kaggle.com/competitions/google-universal-image-embedding] en la plataforma Kaggle sin formación adicional. Open CLIP permite al usuario obtener incrustaciones para cada parte de la imagen segmentada e incrustaciones para los objetos deseados. Luego, después de encontrar la similitud del coseno por pares entre las partes de la imagen, uno puede encontrar el objeto con la métrica máxima y seleccionarlo como parte de la pista.

Además, probamos otra red, Dinov2 [Oquab M. et al. Dinov2: Learning robust visual features without supervision. arXiv preprint arXiv:2304.07193. 2023, https://github.com/facebookresearch/dinov2], que también debería proporcionar una buena incrustación para la comparación de objetos. El resultado es similar a OpenCLIP, pero un poco peor.

Nuestra solución está disponible aquí: https://github.com/ZFTurbo/VOTS2023-Challenge-Tracker

Resultados

El código proporcionado por los organizadores permite a los usuarios medir las métricas localmente para los videos de validación. Para verificar las métricas de los videos de prueba, los resultados apropiados deben cargarse en el servidor.

Resultados de la validación

|

Rastreador |

Calidad |

Exactitud |

Robustez |

NRE |

DRE |

ADQ |

|

Segmento Cualquier Cosa y CLIP |

0.332 |

0.671 |

0.510 |

0.002 |

0.488 |

0.000 |

|

SegmentAnything y Dinov2 |

0.326 |

0.663 |

0.520 |

0.002 |

0.478 |

0.000 |

Resultados de la prueba

|

Rastreador |

Calidad |

Exactitud |

Robustez |

NRE |

DRE |

ADQ |

|

Segmento Cualquier Cosa y CLIP |

0.25 |

0,66 |

0.37 |

0.01 |

0,62 |

0.00 |

Problemas conocidos

La idea principal de nuestro rastreador es que nuestra solución es un predictor de tiro cero porque estamos usando redes neuronales que no están capacitadas para la tarea de rastreo. Por lo tanto, ahorramos tiempo y recursos informáticos costosos para entrenar al rastreador. Esto es especialmente importante en presencia de restricciones muy serias sobre los conjuntos de datos utilizados que fueron anunciadas por los organizadores.

Debido a la corta duración de la competición, no tuvimos tiempo de hacer todo lo que queríamos. En la implementación actual, seleccionamos el siguiente objeto simplemente por la métrica de similitud de coseno máximo. Pero con este enfoque, no resolvemos dos problemas:

1. En caso de que haya objetos muy similares en la imagen, saltaremos entre ellos.

2. En caso de que el objeto no esté a la vista, seguimos eligiendo un objeto al azar.

Resultados

Basándonos en la experiencia de concursos anteriores, partimos del postulado de que la tarea es marcar el objeto rastreado con la mayor precisión posible. Consideramos que la desaparición de la visibilidad es a corto plazo y puede despreciarse. Esto resultó ser un error grave, ya que la nueva métrica de calidad está construida de tal manera que los fotogramas sin objeto se tienen en cuenta con un alto peso, y el rastreador no reconoció esos casos. Además, el conjunto de datos de prueba en sí contenía una cantidad significativa de secuencias en las que no había ningún objeto para rastrear durante mucho tiempo.

En consecuencia, bastó con un simple rastreador de línea de base creado en cuadros delimitadores (que tuvo en cuenta las peculiaridades de la métrica y el conjunto de datos de prueba) para mostrar mejores resultados que nuestro rastreador. Por supuesto, es frustrante que los organizadores no informaran a la comunidad sobre el umbral de calidad por adelantado, especialmente cuando cambiaron abruptamente el enfoque de la evaluación y sugirieron que todos hicieran solo un seguimiento a largo plazo, aunque antes el énfasis estaba en el corto plazo. . Pero por otro lado, no fue solo nuestro equipo el que cayó en esta trampa, ya que nuestro resultado aún aparecía en la clasificación, donde solo se ubica el 40% de los mejores participantes de la competencia.

Trabajo futuro

Para mejorar significativamente los resultados de nuestro rastreador, se requiere una red neuronal adicional basada en capas LSTM recurrentes. Recibirá datos de N fotogramas anteriores como entrada:

El área incrustada, x, y se define para el marco actual de cada objeto. La red neuronal predice si un objeto es un elemento rastreado. Si la probabilidad es baja para todos los objetos, proponemos que el objeto se ha salido de la pantalla.

Podemos entrenar en conjuntos de datos de seguimiento disponibles con marcado conocido (segmentación). Por lo tanto, podremos utilizar los modelos ML listos para usar más avanzados en forma preentrenada, y entrenaremos solo esta malla adicional.

Conclusión

A pesar de no ser el mejor resultado obtenido este año, estamos satisfechos con nuestra participación en VOT Challenge. Confirmó la reputación de una excelente competencia de visión por computadora debido a tareas interesantes, buena documentación y herramientas convenientes para comenzar. Recomendamos a todos los especialistas en visión artificial y equipos académicos tener en cuenta el VOT Challenge.

Aleksandr Romanov (a.romanov@hse.ru) es profesor asociado y director del Laboratorio CAD de la Universidad HSE de Moscú, Rusia. Roman Soloviev (roman.solovyev.zf@gmail.com) es investigador principal en IPPM RAS, Moscú, Rusia.

entradas no encontradas