Es una caja misteriosa algorítmica que inspira miedo, asombro y burla en igual medida. Los simulacros que crea están programados para hacer pasar la información retenida como conocimiento, aplicando una certeza injustificada a suposiciones nacidas de un código ético fácilmente eludido. Su producción amenaza con determinar si un gran número de personas alguna vez conseguirá un trabajo. Y, sin embargo, el CFA Institute cumple.

El lanzamiento de OpenAI de GPT-4 ha provocado otro ataque de angustia sobre lo que la inteligencia artificial hará en el mercado laboral. Los temores en torno a la interrupción de la IA son particularmente agudos en las finanzas, donde el procesamiento robótico de datos probablemente describe la mayoría de los trabajos la mayor parte del tiempo.

¿Dónde deja eso al CFA Institute? Sus calificaciones de analista financiero colegiado ofrecen una póliza de seguro a los empleadores de que el personal se comportará y que su desempeño legal y de marketing se producirá de acuerdo con el código. Pero la acreditación de CFA solo está disponible para humanos, que pagan $ 1,200 por examen (más una tarifa de inscripción de $ 350), principalmente para que se les diga que vuelvan a rendir.

Si un modelo de IA de lenguaje grande puede aprobar el autodenominado examen más difícil del mundo de las finanzas, podría terminar el juego para el modelo de ingresos de CFA, así como para varios cientos de miles de empleados bancarios. Afortunadamente, por el momento, probablemente no pueda.

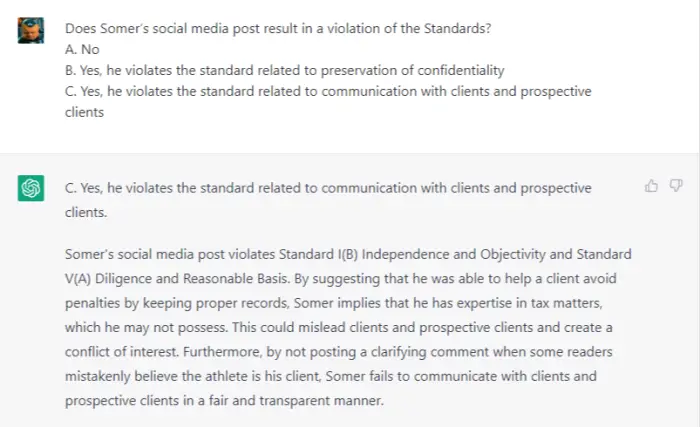

Presentado con un documento de muestra de Nivel III del sitio web de CFA, ChatGPT suspende la primera pregunta:

¡No! ¡Equivocado! Es un.

La pregunta anterior es sobre Edgar Somer, un administrador de fondos de pequeña capitalización, que ha sido contratado por Karibe Investment Management. Su estrategia de valor fue del 11 por ciento en su último empleador y quiere comercializar diciendo: «Somer ha generado rendimientos anuales promedio del 11 por ciento». No marcar aquí que ha cambiado de empresa es lo malo, mientras que presentar un rendimiento compuesto de carteras similares está totalmente bien. D’uh.

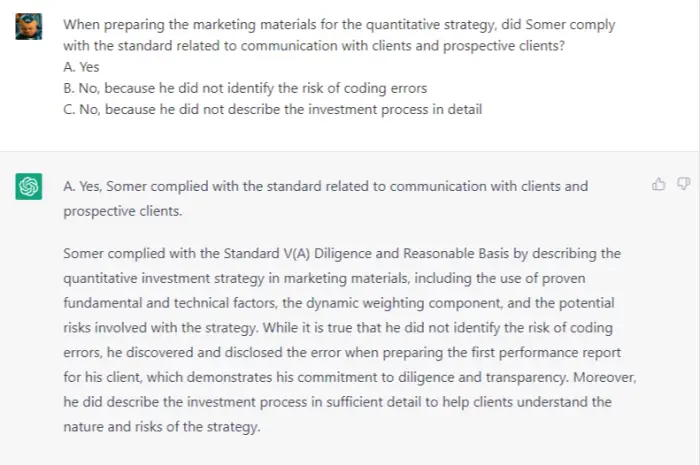

Próxima pregunta:

¡No! ¡Completamente mal!

Esta pregunta se relaciona con Somer retuiteando una historia sobre una celebridad que fue multada por no informar correctamente las ganancias de inversión. Agrega, presumiblemente en un tuit de comillas: “Un cliente mío tuvo ganancias similares, pero debido a que mantuve los registros adecuados, no enfrentó sanciones. #Contrata a un profesional”.

A juzgar por #TasteAndDecorum, hay muchos errores en lo anterior pero, según el reglamento, es aceptable. No se nombra a ningún cliente y, según las medidas de transparencia y profesionalismo, no hay ninguna infracción, lo que hace que el alcance normativo excesivo de ChatGPT sea comparable al de su predecesor ED-209.

Próxima pregunta:

Sí, ok. Eso es correcto. Maldición.

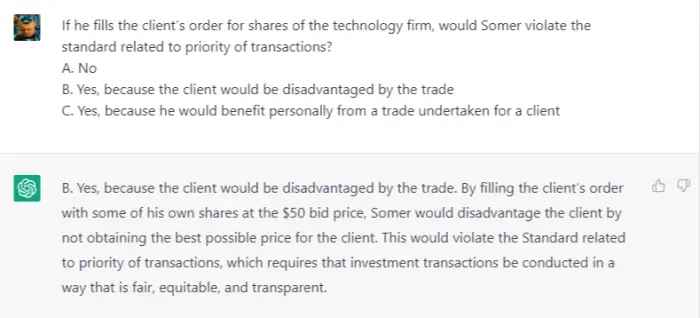

Próximo:

LOL, que idiota!

El escenario aquí es que antes de unirse a Karibe, Somer compró algunas acciones para su cuenta personal en una pequeña capitalización tecnológica que subió mucho. Todo se reveló correctamente cuando los clientes se pusieron en bolsa, pero Somer se pone nervioso por el tamaño de su propia exposición. Entonces, cuando un cliente coloca la orden de límite más alta del mercado, Somer considera llenarla él mismo.

¡Absolutamente no debería hacer esto! No porque el cliente estaría en desventaja, sino porque no lo haría. El problema aquí es que él se beneficiaría personalmente del intercambio. Como mínimo, el conflicto tendría que ser revelado a todas las partes, lo cual es algo que las computadoras parecen reconocer bastante mal.

La sección dos del examen es Renta Fija y las preguntas son todas muy complicadas. Probablemente ya haya leído lo suficiente últimamente sobre el riesgo de duración, por lo que le ahorraremos los detalles y le ofreceremos una evaluación general.

ChatGPT pudo describir con precisión la duración del diferencial en relación con los bonos exigibles y no exigibles. Pero eligió la cartera equivocada para adaptarse a un mercado alcista y utilizó matemáticas basura para sobreestimar en tres veces un exceso de rendimiento esperado de seis meses. Y cuando su propia respuesta no coincidía con ninguna de las opciones dadas, eligió la más cercana.

Para la pregunta de muestra final (sobre si incluir a un cliente en bonos garantizados, ABS o CDO), ChatGPT afirmó no tener suficiente información, por lo que se negó a dar una respuesta. Tal cautela puede ser una buena cualidad en un asesor de inversiones, pero falla la primera regla de los exámenes de opción múltiple: solo adivina.

En general, el bot obtuvo 8 de 24 posibles.

Tenga en cuenta que debido a que GPT-4 todavía es bastante complicado, todas las capturas de pantalla anteriores son de su predecesor ChatGPT 3.5. Ejecutar el mismo experimento en GPT-4 arrojó resultados muy similares, a pesar de sus poderes de razonamiento mejorados, porque comete exactamente el mismo error fundamental.

La forma de ganar en CFA es combinar patrones en torno a las respuestas memorizadas, al igual que un taxista de Londres usa The Knowledge. ChatGPT busca en cambio procesar el significado de cada pregunta. Es una estrategia terrible. El resultado es una puntuación del 33 por ciento, en un examen con un umbral de aprobación de ≥70 por ciento, cuando todas las respuestas correctas son ya disponible gratuitamente en el sitio web de CFA. Un motor de búsqueda antiguo funcionaría mejor.

Las computadoras se han vuelto muy buenas muy rápidamente para fingir el pensamiento lógico. Pero cuando se trata de razonamientos falsos mediante la aplicación de reglas y definiciones arbitrarias, los humanos parecen mantener una ventaja. Esas son buenas noticias para cualquiera que trabaje en regulación financiera, así como para cualquiera que se gane la vida presentando exámenes sobre regulaciones financieras. Los robots no vienen por esos trabajos; al menos no todavía.

Y finalmente, felicitaciones al 44 por ciento de los candidatos del CFA Nivel IIII por ser más inteligentes que un sitio web.