Si bien puede no parecer tan central para la seguridad como la protección contra malware y la detección de infracciones, el filtrado de contenido web desempeña un papel importante para garantizar el cumplimiento normativo y la seguridad de los lugares de trabajo, así como la seguridad de la red. A diferencia de la clasificación de seguridad de las URL, que detecta contenido malicioso como malware o phishing, el filtrado web tiene que etiquetar el contenido en función no de los mecanismos de ataque sino de la naturaleza de su contenido, un problema mucho más generalizado que buscar patrones maliciosos en el contenido detrás del URL

Las etiquetas de categoría del sitio web generalmente describen cuál es el contenido o el propósito del sitio. Algunas categorías son clasificaciones amplias como «negocios», «computadoras e Internet», «comida y comedor» y «entretenimiento». Otros se centran en la intención, como «banca», «compras», «motores de búsqueda», «redes sociales», «búsqueda de empleo» y «educación». Y luego están las categorías que pueden incluir contenido de interés: «sexualmente explícito», «alcohol», «marihuana» y «armas», por ejemplo. Las organizaciones pueden querer establecer varias políticas para filtrar o medir los tipos de sitios web a los que se accede desde sus redes.

Sophos X-Ops ha estado investigando formas de aplicar el aprendizaje automático del modelo de lenguaje grande (LLM) al filtrado web para ayudar a detectar la «cola larga» de los sitios web: esos millones de dominios que tienen relativamente pocos visitantes y poca o ninguna visibilidad para los analistas humanos. Los LLM en sí mismos no son prácticos para esta aplicación debido a su tamaño y costo de recursos computacionales. Pero se pueden usar a su vez como modelos «maestros» para entrenar modelos más pequeños en categorización, lo que reduce los recursos computacionales necesarios para generar etiquetas sobre la marcha para dominios recién encontrados.

Mediante el uso de LLM como GPT-3 de OpenAI y T5 Large de Google, el equipo de SophosAI pudo entrenar modelos mucho más pequeños para clasificar sobre la marcha URL nunca antes analizadas. Lo que es más importante, la metodología utilizada aquí podría usarse para crear modelos pequeños y económicamente implementables basados en el resultado de los LLM para otras tareas de seguridad.

La investigación del equipo, detallada en un artículo publicado recientemente titulado «Filtrado de contenido web a través de la destilación del conocimiento de modelos de lenguaje extenso», explora las formas en que los LLM se pueden usar para reforzar la clasificación de sitios impulsada por humanos y crear sistemas que se pueden implementar para realice el etiquetado en tiempo real de URL nunca antes vistas.

El problema de la “cola larga”

La categorización de los sitios se ha basado en gran medida en el mapeo de dominio a categoría basado en reglas, donde las firmas elaboradas por analistas se utilizan para buscar indicadores en las URL para asignar rápidamente etiquetas a nuevos dominios. Este tipo de mapeo es vital para el etiquetado rápido de URL en sitios conocidos y para evitar falsos positivos que bloqueen contenido importante. La identificación humana práctica de los patrones de clasificación de sitios se vuelve a incluir en los conjuntos de características de las herramientas de mapeo de dominios.

El problema surge con la «cola larga» de los sitios web: esos dominios menos visitados que normalmente no reciben firmas asignadas. Con la aparición diaria de miles de nuevos sitios web y con más de mil millones de sitios web existentes, mantener y escalar enfoques basados en firmas manualmente para la cola larga se ha vuelto cada vez más desafiante. Eso es evidente en la fuerte caída del etiquetado para los dominios menos visitados, mientras que los sitios muy conocidos y de alto tráfico obtienen casi el 100 por ciento de cobertura en la mayoría de los esquemas de etiquetado, como se muestra en el diagrama a continuación, la proporción de dominios etiquetados por analistas comienza caer rápidamente más allá de los cien dominios más visitados. Los sitios clasificados por debajo de los primeros 5000 tienen menos del 50 por ciento de probabilidades de haber sido etiquetados por su contenido.

Figura 1. Etiquetado de contenido relativo a la popularidad de los dominios, derivado de la telemetría. Una forma de solucionar esto es a través de la aplicación de aprendizaje automático para procesar dominios previamente no etiquetados. Pero hasta ahora, la mayoría de los esfuerzos de aprendizaje automático (como URLTran de Microsoft) han utilizado modelos de aprendizaje profundo para centrarse en la tarea de detectar amenazas de seguridad, en lugar de clasificar los sitios por contenido. Estos modelos podrían volver a entrenarse para realizar una clasificación de múltiples categorías, pero requerirían conjuntos de datos de entrenamiento extremadamente grandes. URLTran usó más de 1 millón de muestras solo para capacitarse en la detección de URLS maliciosas.

Automatización con IA

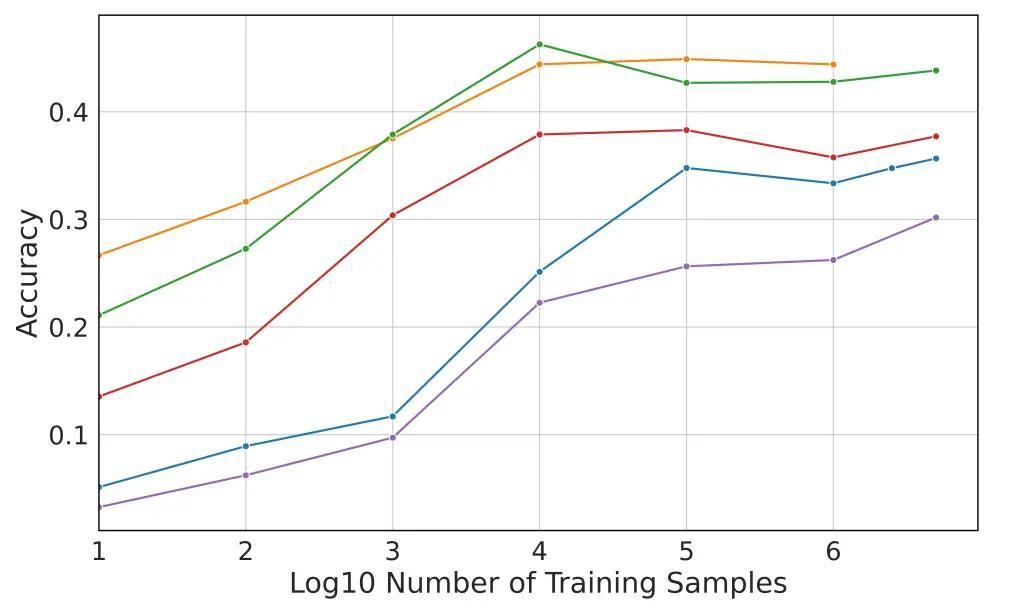

Ahí es donde entran los LLM. Debido a que están entrenados previamente en cantidades masivas de texto sin etiquetar, el equipo de SophosAI creyó que los LLM podrían usarse para realizar el etiquetado de URL con mayor precisión y con muchos menos datos iniciales. Cuando ajustó los datos etiquetados con firmas de propagación de dominio, el equipo de SophosAI descubrió que los LLM tienen una ventaja de precisión del 9 % sobre la arquitectura de modelo de última generación de Microsoft al abordar el problema de categorización de «cola larga», y solo requería una capacitación. conjunto de miles de URL, en lugar de millones.

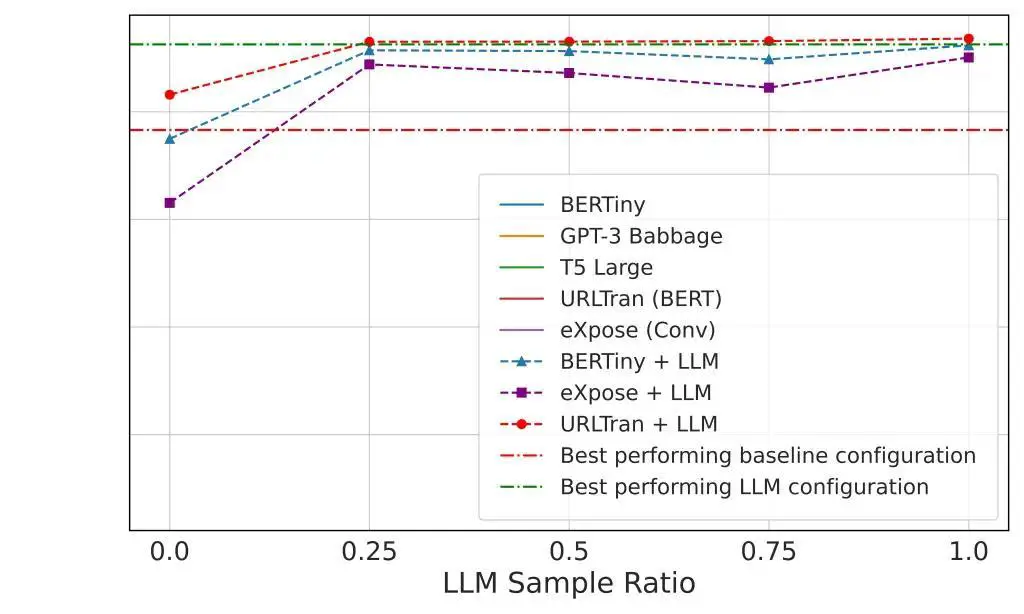

Los LLM, que utilizan relaciones semánticas entre las clases de sitio y las palabras clave dentro de las URL en un conjunto de datos más pequeño, se usaron luego para crear etiquetas para un conjunto de datos sin etiquetar de sitios de cola larga que, a su vez, se usaron para entrenar modelos más pequeños (BERTiny y BERT modelos de transformador URLTran basados en 1D y el modelo convolucional 1D eXpose). Este enfoque de «destilación de conocimiento» permitió al equipo alcanzar niveles de rendimiento similares a los del LLM con modelos 175 veces más pequeños, reduciendo la cantidad de parámetros de 770 millones a solo 4 millones.

Si bien los conjuntos de modelos más precisos creados funcionaron mucho mejor que los modelos entrenados solo mediante «aprendizaje profundo», su precisión no llegó a la perfección, incluso los mejores modelos obtuvieron una precisión inferior al 50 por ciento. Muchas URL no se etiquetaron correctamente simplemente porque no tenían suficientes «señales» integradas en ellas, mientras que otras tenían palabras clave que podían asociarse con múltiples clasificaciones, lo que creaba una incertidumbre que solo podía aclararse mediante un examen más profundo del contenido detrás de la URL. .

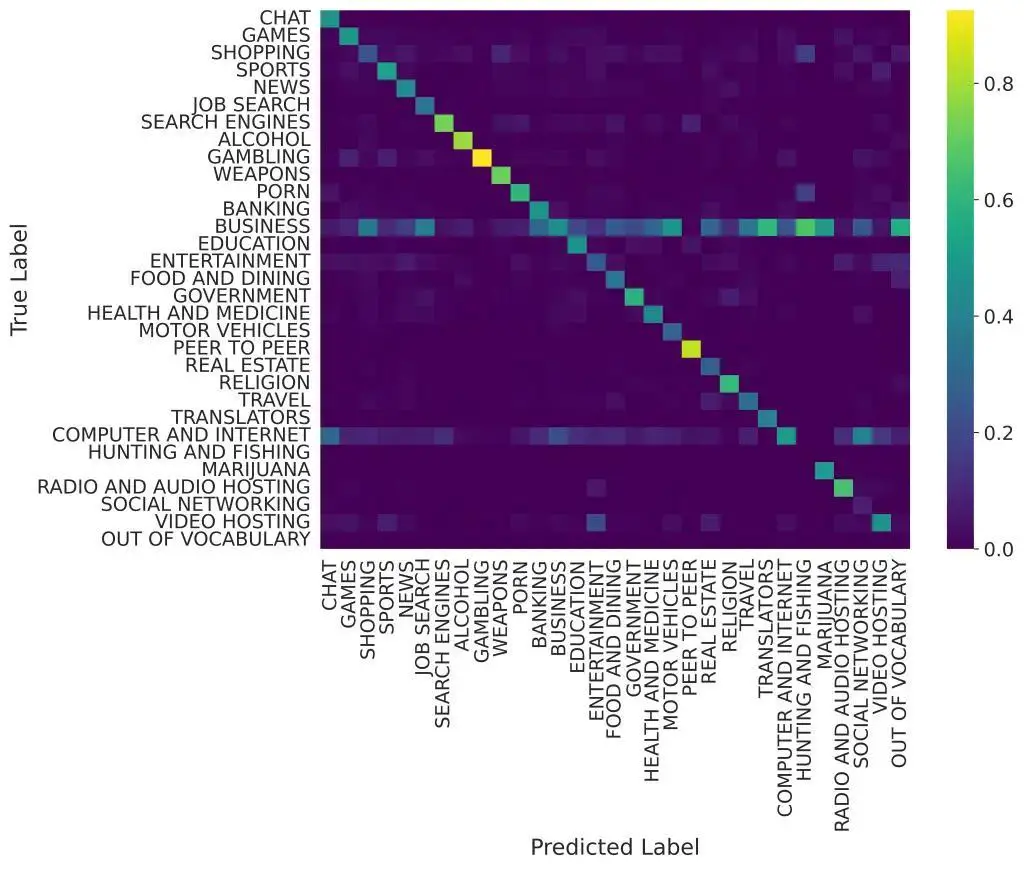

Sin embargo, el modelo T5 Large se desempeñó razonablemente bien en las categorías que potencialmente se filtrarían, como se muestra en la siguiente matriz de confusión: los sitios de juego y de intercambio entre pares tienen un etiquetado casi perfecto en los datos de prueba. Los sitios de alcohol, armas y pornografía también tuvieron tasas de detección de verdaderos positivos superiores al 60 %.

Hay varias formas de mejorar esta precisión en el futuro que ha sugerido el equipo de SophosAI. En primer lugar, permitir la asignación de varias categorías a un sitio eliminaría los problemas de superposición de categorías. Aumentar las muestras de URL con HTML recuperado e imágenes de ellas también podría proporcionar un mejor reconocimiento de su categorización, y los LLM más nuevos, como GPT-4, podrían usarse como maestros.

Cuando se combina con los procesos existentes, esta forma de clasificación basada en IA puede mejorar en gran medida el manejo de los sitios web de cola larga. Y hay otras tareas relacionadas con la seguridad a las que podría aplicarse la metodología de «destilación de conocimiento» probada en este experimento.

Por Sean Gallagher

Para obtener más detalles, consulte el artículo escrito por Tamas Voros, Sean Bergeron y el director de SophosAI Konstantin Berlin aquí en arxiv.org.