Pulgar humano junto a nuestro sensor OmniTact, y un centavo para la escala.

Se ha demostrado que el tacto es importante para la manipulación diestra en …la robótica. Recientemente, el sensor GelSight ha despertado un gran interés para la robótica basada en el aprendizaje debido a su bajo costo y rica señal. Por ejemplo, Los sensores GelSight se han utilizado para aprender a insertar los cables USB (Li et al, 2014), tirar un dado (Tian et al. 2019) o agarrar objetos (Calandra et al. 2017).

La razón por la que los métodos basados en el aprendizaje funcionan bien con los sensores de GelSight es que producen imágenes táctiles de alta resolución de las cuales una variedad de características como la geometría del objeto, la textura de la superficie, las fuerzas normales y de corte pueden ser que a menudo resultan ser críticos para el control robótico. Las imágenes táctiles

pueden ser introducidos en los conductos de visión computarizada estándar de la CNN permitiendo el uso de una variedad de diferentes técnicas basadas en el aprendizaje: En Calandra et al.

2017 se capacita a un clasificador de agarre y éxito en los datos de GelSight recopilados en manera auto-supervisada, en Tian et al. 2019 Visual Foresight, un El algoritmo de control basado en la video-predicción se usa para hacer que un robot tire un dado basado puramente en imágenes táctiles, y en Lambeta et al. 2020 un modelo basado en El algoritmo RL se aplica a la manipulación en mano usando imágenes de GelSight.

Desafortunadamente, la aplicación de los sensores GelSight en escenarios prácticos del mundo real es todavía es un reto debido a su gran tamaño y al hecho de que sólo es sensible en un lado. Aquí presentamos un nuevo y más compacto diseño de sensor táctil basado en GelSight que permite la detección omnidireccional, es decir, hacer que el sensor sensible por todos lados como un dedo humanoy mostrar cómo esto abre nuevas posibilidades de aprendizaje sensorial-motor. Lo demostramos enseñando una robot para recoger los enchufes eléctricos e insertarlos basado puramente en el tacto retroalimentación.

Un sensor GelSight estándar, que se muestra en la figura de abajo a la izquierda, usa un webcam para capturar imágenes de alta resolución de las deformaciones en la piel de gel de silicona. La superficie interior de la piel de gel se ilumina con LEDs de color, proporcionando suficiente iluminación para la imagen táctil.

Comparación del sensor estilo GelSight (lado izquierdo) con nuestro sensor OmniTact (lado derecho) lado).

Los diseños existentes de GelSight son planos, tienen pequeños campos sensibles o sólo proporcionan señales de baja resolución. Por ejemplo, las versiones anteriores del GelSight proporcionan imágenes de alta resolución (400×400 píxeles) pero son grandes y planas, proporcionando sensibilidad en un solo lado, mientras que la OptoForce comercial El sensor (recientemente escontinuado por OnRobot) es curvo, pero sólo proporciona fuerza como un único vector de fuerza tridimensional.

Nuestro diseño del sensor OmniTact tiene como objetivo abordar estas limitaciones. Proporciona tanto multidireccional y de alta resolución en su superficie curva en un …un factor de forma compacto. Similar a GelSight, OmniTact utiliza cámaras integradas en una piel de gel de silicona para capturar la deformación de la piel, proporcionando una rica señal de la cual una amplia gama de características como el corte y las fuerzas normales, objeto se puede inferir la postura, la geometría y las propiedades de los materiales. OmniTact utiliza múltiples cámaras que le dan capacidades de alta resolución y multidireccionales. El El propio sensor puede ser usado como un «dedo» y puede ser integrado en una pinza o mano robótica. Es más compacta que los anteriores sensores GelSight, que es se logra utilizando microcámaras típicamente usadas en endoscopios, y por …echando el gel de silicona directamente a las cámaras. Las imágenes táctiles de OmniTact se muestran en las figuras de abajo.

Lecturas táctiles de OmniTact con varios objetos. De izquierda a derecha: M3 Cabeza de tornillo, rosca de tornillo M3, cerradura de combinación con números 4 3 9, impreso Placa de circuito impreso (PCB), ratón inalámbrico USB. Todas las imágenes se toman desde el cámara orientada hacia arriba.

Lecturas táctiles del OmniTact que se enrollan sobre un portaequipajes. El Las capacidades multidireccionales de OmniTact mantienen la cremallera de engranajes a la vista como la El sensor está girado.

Uno de nuestros principales objetivos a lo largo del proceso de diseño fue hacer de OmniTact como lo más compacto posible. Para lograr este objetivo, usamos microcámaras con grandes ángulos de visión y una pequeña distancia de enfoque. Específicamente elegimos cámaras que se utilizan comúnmente en los endoscopios médicos que miden sólo (1,35 x 1,35 x 5 mm) en con una distancia de enfoque de 5 mm. Estas cámaras fueron dispuestas en una impresión 3D de la cámara como se muestra en la figura de abajo, lo que nos permitió reducir al mínimo manchas en la superficie del sensor y reducir el diámetro (D) del sensor a 30 mm.

Esta imagen muestra los campos de visión y la disposición de las 5 microcámaras dentro del sensor. Usando este arreglo, la mayor parte de la punta del dedo puede ser hecha sensible de manera efectiva. En el plano vertical, mostrado en la A, obtenemos $alpha=270$ grados de sensibilidad. En el plano horizontal, mostrado en B, nosotros obtener 360 grados de sensibilidad, excepto por pequeños puntos ciegos entre el campos de visión.

Mostramos que las capacidades de detección táctil multidireccional de OmniTact pueden ser para resolver un desafiante problema de control robótico: Insertar un conector eléctrico a ciegas en un enchufe de pared basado puramente en la información del sensor táctil multidireccional (mostrado en la figura de abajo). Esta tarea es un desafío ya que requiere localizar el conector eléctrico relativo a la pinza y localizando la pinza en relación con el enchufe de la pared.

Para aprender la tarea de inserción, usamos un simple algoritmo de aprendizaje de imitación que estima el desplazamiento del efector final necesario para insertar el enchufe en la salida basada en las imágenes táctiles del sensor OmniTact. Nuestro modelo fue entrenado con sólo 100 demostraciones de inserción controlando el robot usando el control del teclado. Las inserciones exitosas obtenidas mediante la ejecución de los entrenados se muestran en los siguientes gifs.

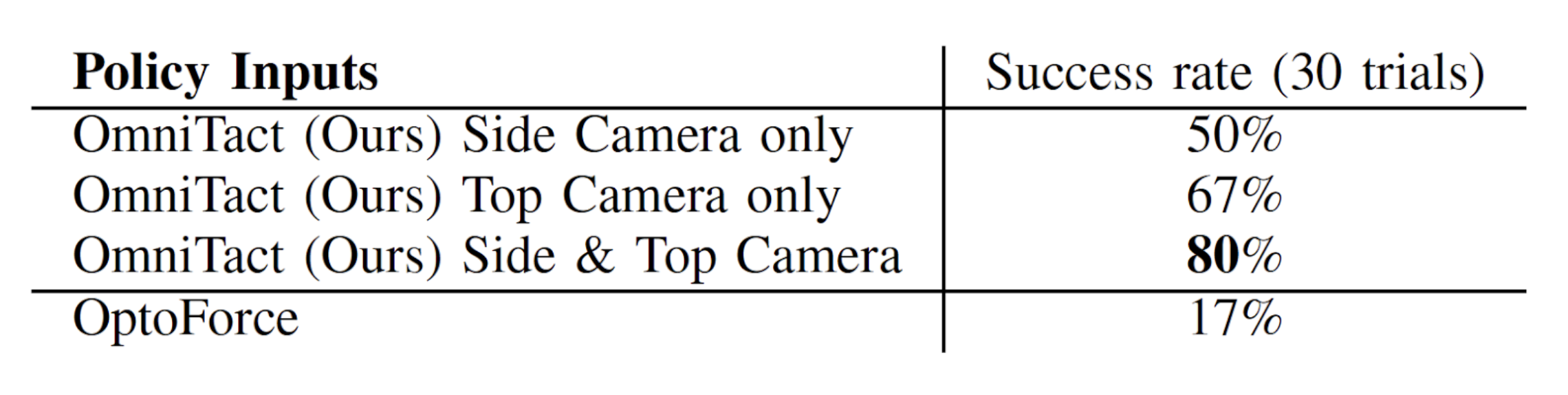

Como se muestra en la tabla siguiente, utilizando las capacidades multidireccionales (tanto la cámara superior y lateral) de nuestro sensor permitió la mayor tasa de éxito (80%) en comparación con el uso de una sola cámara del sensor, lo que indica que la detección multidireccional de tacto es de hecho crucial para resolver esta tarea. Nosotros además comparó el rendimiento con otro táctil multidireccional el sensor OptoForce, que sólo tuvo una tasa de éxito del 17%.

Creemos que la detección táctil compacta, de alta resolución y multidireccional tiene el potencial de transformar las capacidades de la actual manipulación robótica sistemas. Sospechamos que la detección táctil multidireccional podría ser una elemento esencial en la manipulación robótica de propósito general además de aplicaciones como la teleoperación robótica en cirugía, así como en el mar y misiones espaciales. En el futuro, planeamos hacer que OmniTact sea más barato y más compacto, lo que permite que se utilice en una gama más amplia de tareas. Nuestro equipo

además planea llevar a cabo más investigación sobre manipulación robótica que informar a las futuras generaciones de sensores táctiles.

Esta entrada en el blog se basa en el siguiente artículo que será presentado en el Conferencia Internacional sobre Robótica y Automatización 2020:

Queremos agradecer al profesor Sergey Levine, a la profesora Chelsea Finn, y a Stephen Tian por sus valiosos comentarios al preparar esta entrada de blog.