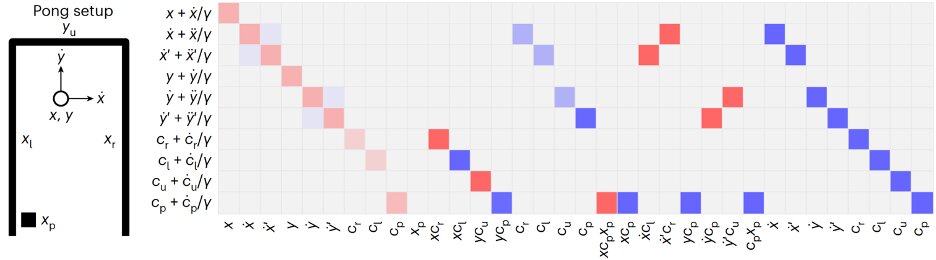

El diagrama y el código fuente en el framework de programación RNN para un juego de pong. Crédito: Kim y Bassett

La computación de reservorio es un marco computacional prometedor basado en redes neuronales recurrentes (RNN), que esencialmente mapea los datos de entrada en un espacio computacional de alta dimensión, manteniendo fijos algunos parámetros de las redes neuronales artificiales (ANN) mientras actualiza otros. Este marco podría ayudar a mejorar el rendimiento de los algoritmos de aprendizaje automático, al mismo tiempo que reduce la cantidad de datos necesarios para entrenarlos adecuadamente.

Los RNN esencialmente aprovechan las conexiones recurrentes entre sus diferentes unidades de procesamiento para procesar datos secuenciales y hacer predicciones precisas. Si bien se ha descubierto que los RNN se desempeñan bien en numerosas tareas, optimizar su rendimiento al identificar los parámetros que son más relevantes para la tarea que abordarán puede ser un desafío y llevar mucho tiempo.

Jason Kim y Dani S. Bassett, dos investigadores de la Universidad de Pensilvania, introdujeron recientemente un enfoque alternativo para diseñar y programar computadoras de reservorio basadas en RNN, que se inspira en cómo funcionan los lenguajes de programación en el hardware de la computadora. Este enfoque, publicado en Naturaleza Máquina Inteligenciapuede identificar los parámetros apropiados para una red determinada, programando sus cálculos para optimizar su rendimiento en los problemas de destino.

«Ya sea calculando una propina o simulando múltiples movimientos en un juego de ajedrez, siempre nos ha interesado cómo el cerebro representa y procesa la información», dijo Kim a Tech Xplore. «Nos inspiramos en el éxito de las redes neuronales recurrentes (RNN) tanto para modelar la dinámica del cerebro como para aprender cálculos complejos. Basándonos en esa inspiración, hicimos una pregunta simple: ¿qué pasaría si pudiéramos programar las RNN de la misma manera que hacemos con las computadoras? Antes El trabajo en teoría de control, sistemas dinámicos y física nos dijo que no era un sueño imposible».

El código de máquina neuronal introducido por Kim y Bassett se logró descompilando las representaciones internas y la dinámica de los RNN para guiar su análisis de los datos de entrada. Su enfoque se asemeja al proceso de compilar un algoritmo en el hardware de una computadora, lo que implica detallar las ubicaciones y los tiempos en los que se deben encender y apagar los transistores individuales.

«En una RNN, estas operaciones se especifican simultáneamente en los pesos distribuidos por la red, y las neuronas ejecutan las operaciones en paralelo y almacenan la memoria», explicó Kim. «Usamos las matemáticas para definir el conjunto de operaciones (pesos de conexión) que ejecutarán un algoritmo deseado (por ejemplo, resolver una ecuación, simular un videojuego) y para extraer el algoritmo que se está ejecutando en un conjunto de pesos existente. Las ventajas únicas de nuestro enfoque son que no requiere datos ni muestreo, y que define no solo una conectividad, sino un espacio de patrones de conectividad que ejecutan el algoritmo deseado».

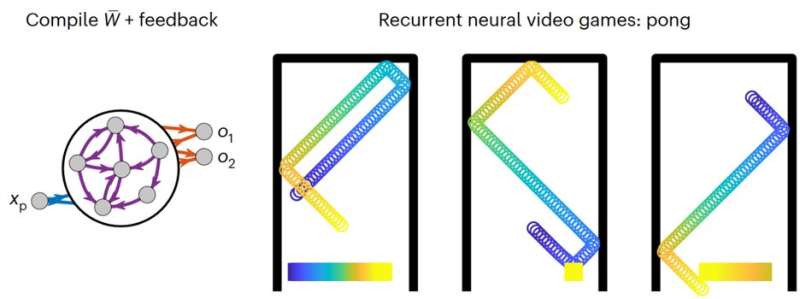

Jugar un juego de pong que está siendo simulado por una red neuronal recurrente. Crédito: Naturaleza Máquina Inteligencia (2023). DOI: 10.1038/s42256-023-00668-8

Los investigadores demostraron las ventajas de su marco usándolo para desarrollar RNN para diversas aplicaciones, incluidas máquinas virtuales, puertas lógicas y un videojuego de ping-pong impulsado por IA. Se encontró que todos estos algoritmos funcionan notablemente bien, sin requerir ajustes de prueba y error en sus parámetros.

«Una contribución notable de nuestro trabajo es un cambio de paradigma en la forma en que entendemos y estudiamos las RNN desde las herramientas de procesamiento de datos hasta las computadoras completas», dijo Kim. «Este cambio significa que podemos examinar un RNN entrenado y saber qué problema está resolviendo, y podemos diseñar RNN para realizar tareas sin datos de entrenamiento o retropropagación. En la práctica, podemos inicializar nuestras redes con un algoritmo basado en hipótesis en lugar de pesos aleatorios. o un RNN pre-entrenado, y podemos extraer directamente el modelo aprendido del RNN».

El marco de programación y el código de máquina neuronal presentado por este equipo de investigadores pronto podrían ser utilizados por otros equipos para diseñar RNN de mejor rendimiento y ajustar fácilmente sus parámetros. Kim y Bassett finalmente esperan usar su marco para crear un software completo que se ejecute en hardware neuromórfico. En sus próximos estudios, también planean idear un enfoque para extraer algoritmos aprendidos por computadoras de reservorio entrenadas.

«Si bien las redes neuronales son excepcionales en el procesamiento de datos complejos y de gran dimensión, estas redes tienden a costar mucha energía para funcionar, y comprender lo que han aprendido es excepcionalmente desafiante», dijo Kim. «Nuestro trabajo proporciona un trampolín para descompilar y traducir directamente los pesos entrenados en un algoritmo explícito que se puede ejecutar de manera mucho más eficiente sin necesidad de la RNN, y se puede analizar más a fondo para obtener comprensión y rendimiento científicos».

El grupo de investigación de Bassett en la Universidad de Pensilvania también está trabajando en el uso de enfoques de aprendizaje automático, particularmente RNN, para reproducir procesos y habilidades mentales humanos. El código de máquina neuronal que crearon recientemente podría respaldar sus esfuerzos en esta área de investigación.

«Una segunda dirección de investigación emocionante es diseñar RNN para realizar tareas características de la función cognitiva humana», agregó Dani S. Bassett, el profesor que supervisa el estudio. «Usando teorías, modelos o definiciones de procesos cognitivos derivadas de datos, imaginamos diseñar RNN para participar en la atención, la propiocepción y la curiosidad. Al hacerlo, estamos ansiosos por comprender los perfiles de conectividad que respaldan procesos cognitivos tan distintos».

Más información:

Jason Z. Kim et al, Un código de máquina neuronal y un marco de programación para la computadora del yacimiento, Naturaleza Máquina Inteligencia (2023). DOI: 10.1038/s42256-023-00668-8

© 2023 Ciencia X Red

Citación: Un nuevo código de máquina neuronal para programar computadoras de reservorio (2023, 7 de julio) recuperado el 8 de julio de 2023 de https://techxplore.com/news/2023-07-neural-machine-code-reservoir.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.