Hace pocos meses, APUNTAR hizo que GPT-4 tomara el examen más difícil de la India: UPSC. ChatGPT, impulsado por GPT-4, pudo descifrar el examen con 162,76 puntos. Notamos que al alterar la consulta, eventualmente podríamos hacer que el modelo generara respuestas precisas. Sin embargo, en el experimento, solo consideramos las primeras respuestas del bot.

Recientemente, un artículo de investigadores del MIT llamado Exploring the MIT Mathematics and EECS Curriculum Using Large Language Models fue tendencia. El documento afirmó que GPT-4 obtuvo una puntuación del 100 % en el plan de estudios EECS del MIT con un conjunto de datos de 4550 preguntas y soluciones. Sonaba como una gran hazaña antes de que algunos investigadores decidieran profundizar más.

Raunak Chowdhari, Neil Deshmukh, y David Koplow de MIT EECS seniors decidieron investigar el artículo y quedaron decepcionados con los resultados. Los investigadores descubrieron que las preguntas del documento estaban incompletas y que no había forma de que GPT-4 pudiera haber encontrado las respuestas correctas, y no lo hizo.

Un trabajo reciente de @Lo haría afirmó que GPT4 puede obtener una puntuación del 100 % en el plan de estudios EECS del MIT con las indicaciones adecuadas.

Mis amigos y yo estábamos emocionados de leer el análisis detrás de tal hazaña, pero después de investigar más a fondo, lo que encontramos nos dejó sorprendidos y decepcionados.https://t.co/mpDqlenk04

🧵 https://t.co/EVTToZUzL8

— Raunak Chowdhuri (@sauhaarda) 17 de junio de 2023

Además, los investigadores del artículo utilizaron GPT-4 para evaluar y calificar las respuestas generadas por GPT-4. Incluso solicitaron continuamente GPT-4 hasta que se logró la respuesta correcta. Y cuando las respuestas no se corrigieron, se proporcionaron respuestas completas a GPT-4 en el conjunto de datos cargado, para que el modelo pueda generarlo como propio. Cuando los tres investigadores intentaron corriendo tiro cero GPT-4 en el conjunto de datos, los resultados fueron solo del 62,5 %, significativamente peores que el 90 % de corrección que afirma el artículo.

El artículo tiene 15 autores. Se vuelve imperdonable para ellos rechazar las críticas diciendo que el artículo no está revisado por pares. Cualquiera de ellos podría haber señalado y corregido los problemas con el conjunto de datos y la metodología. Pero parece ser un «error» intencional publicar información falsa solo por aparecer en los titulares.

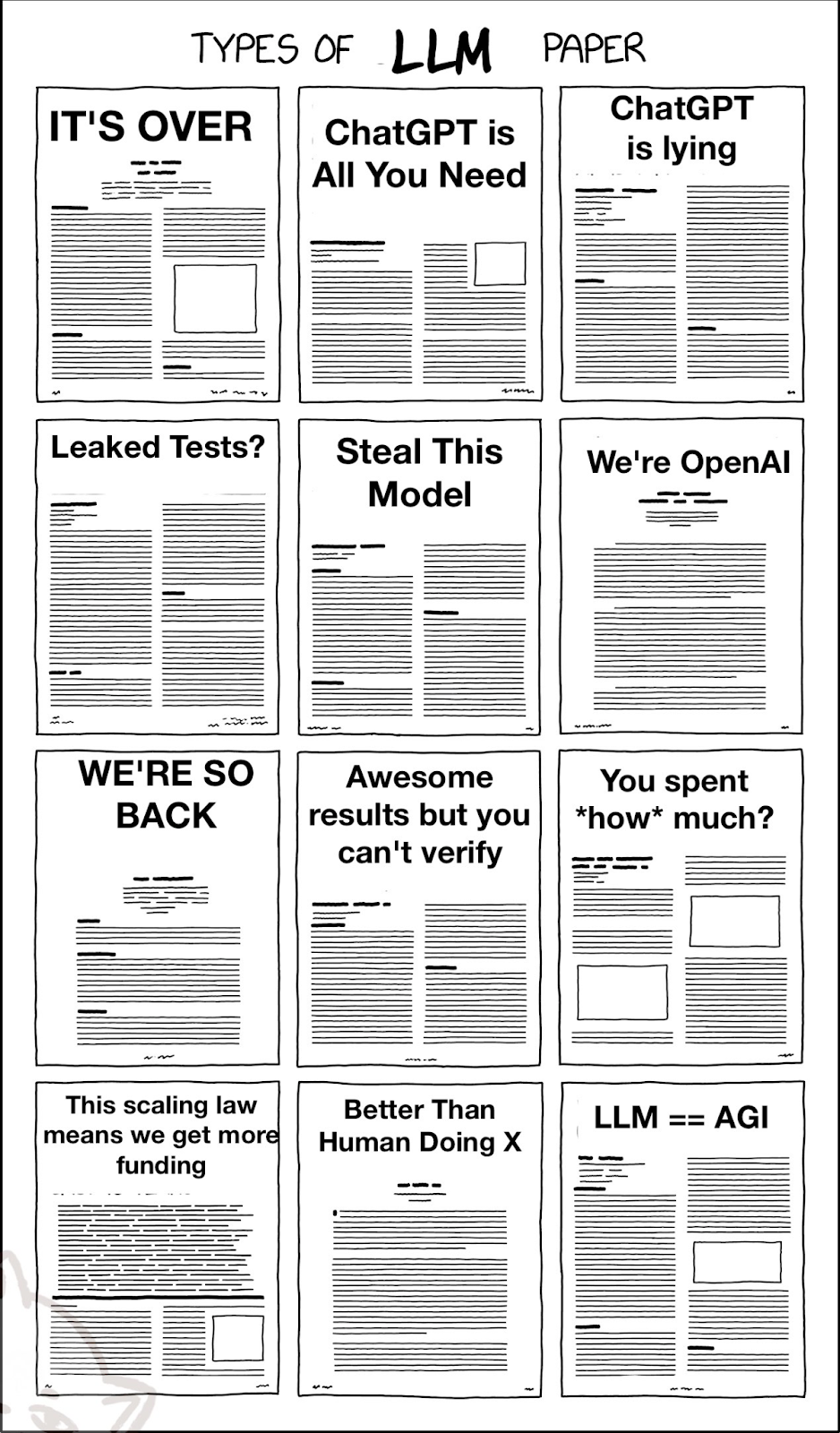

Los investigadores concluyeron que recientemente ha habido esta tendencia en el campo de la investigación de la IA: la reducción del cronograma para la investigación ha resultado en la búsqueda de atajos en la investigación. Esto, junto con tomar GPT-4 como punto de referencia para probar LLM, conlleva muchos problemas, ya que la confiabilidad no se mide contra una contraparte humana, solo otro modelo LLM, que también es alucinante.

donde empezó todo

OpenAI tampoco es ajeno a la publicación de artículos aburridos. Anteriormente, los investigadores criticaron la política de puertas cerradas de la empresa por no publicar absolutamente ningún tecnicismo en el documento GPT-4. Luego vino el documento que intentaba calificar a GPT como una tecnología de propósito general y midiendo el impacto de la tecnología en los trabajos a lo largo de los años, al mismo tiempo que promovía a todos para que la usaran.

En el campo de la investigación, la tendencia y las capacidades promocionadas de GPT-4 han hecho que todos comparen sus investigaciones con él. GPT-4 en este punto se considera como «verdad en el terreno» para cada nuevo avance tecnológico, específicamente en el campo de LLM.

Además, el enfoque de caja negra del documento GPT-4 ha sido seguido por todos y cada uno. Un usuario en la discusión de HackerNews sobre el artículo del MIT dice que el aprendizaje automático ya no es un campo científico, por lo tanto, «cualquiera puede decir y hacer lo que quiera y no hay forma de decirles que lo que están haciendo está mal». Se ha vuelto como las ciencias sociales: investigación infalsable e irreproducible construida sobre otra investigación infalsable e irreproducible.

Vale la pena señalar que no ha habido buenas métricas ni puntos de referencia significativos para los modelos de generación de lenguaje durante décadas. Las personas terminan citando y eligiendo cualquier enfoque y modelo para comparar los resultados, lo que da como resultado que no haya una métrica estandarizada para las capacidades de un enfoque específico.

Persiguiendo la fiebre del oro

Actualmente, gran parte de la investigación en el campo de LLM y la IA generativa después del lanzamiento de los modelos GPT de OpenAI solo sigue la tendencia y la exageración en un intento por mantenerse relevante. Esto da como resultado una gran cantidad de investigaciones matizadas sin una base o credibilidad adecuadas, lo que lleva a una avalancha de documentos falsos en Internet.

Esto definitivamente sienta un mal precedente en el campo de la investigación de IA, haciendo que todos cuestionen la autenticidad de los trabajos de investigación. Esto también hace que uno se pregunte: ¿qué fracción de los documentos en Internet son realmente aburridos pero no se han enfrentado a un escrutinio similar? Y con la tendencia actual de los papeles de escritura GPT-4 de «verdad en el terreno», se espera que la calidad baje aún más.