El progreso de la IA viene a trompicones. No escuchas nada durante meses y luego, de repente, los límites de lo que parece posible se rompen en pedazos. Abril fue uno de esos meses, con dos nuevos lanzamientos importantes en el campo que sorprendieron a los espectadores.

Suscríbase a nuestro boletín semanal de tecnología, TechScape.

El primero fue PaLM de Google, un nuevo modelo de lenguaje (el mismo tipo básico de IA que la famosa serie GPT) que muestra una capacidad bastante sorprendente para comprender y analizar declaraciones complejas y explicar lo que está haciendo en el proceso. Tome esta simple pregunta de comprensión del anuncio de la compañía:

Oportuno: ¿Cuál de las siguientes oraciones tiene más sentido? 1. Estudié mucho porque saqué A en el examen. 2. Obtuve una A en el examen porque estudié mucho.

Respuesta del modelo: Saqué A en el examen porque estudié mucho.

O esto:

Oportuno: P: Un presidente monta un caballo. ¿Qué hubiera pasado si el presidente hubiera montado en moto? 1. A ella oa él le hubiera gustado montar a caballo. 2. Habrían saltado la cerca de un jardín. 3. Ella o él habría sido más rápido. 4. El caballo habría muerto.

Respuesta del modelo: Ella o él habría sido más rápido.

Este es el tipo de preguntas con las que las computadoras han luchado históricamente, que requieren una comprensión bastante amplia de los hechos básicos sobre el mundo antes de que pueda comenzar a abordar la declaración que tiene frente a usted. (Para otro ejemplo, intente analizar la famosa frase «el tiempo vuela como una flecha, la fruta vuela como un plátano»).

Tan pobre Google que, menos de una semana después, sus innegables logros con PaLM se vieron eclipsados por un lanzamiento mucho más fotogénico de OpenAI, el laboratorio de investigación anteriormente respaldado por Musk que generó GPT y sus sucesores. El laboratorio mostró Dall-E 2 (como un híbrido de Wall-E y Dalí), una IA de generación de imágenes con la capacidad de tomar descripciones de texto en lenguaje natural y escupir imágenes alarmantemente detalladas.

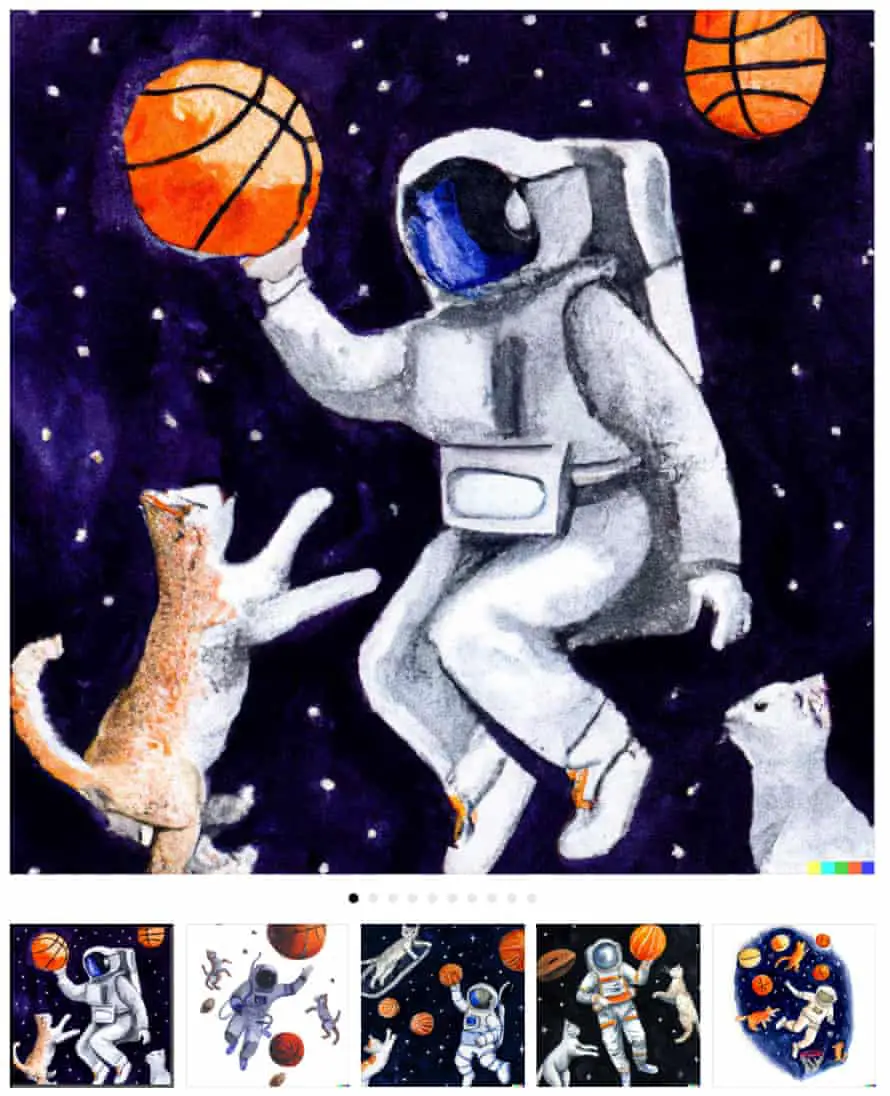

Una imagen vale más que mil palabras, así que aquí hay un breve libro sobre Dall-E 2, con las imágenes acompañadas de las leyendas que las generaron.

Del anuncio oficial, «Un astronauta jugando baloncesto con gatos en el espacio en estilo acuarela»:

Y “Un plato de sopa como un planeta en el universo como un cartel de los años 60”:

Del artículo académico que detalla cómo funciona Dall-E 2, «un shiba inu con boina y cuello alto negro»:

Y “un oso de peluche en una patineta en Times Square”:

No todas las indicaciones tienen que estar en inglés conversacional, y agregar un montón de palabras clave puede ayudar a ajustar lo que hace el sistema. En este caso, “artstation” es el nombre de una red social de ilustración, y a Dall-E se le dice efectivamente “haz estas imágenes como esperas verlas en artstation”. Y entonces:

«panda científico loco mezclando productos químicos brillantes, artstation»

“un delfín con traje de astronauta en saturno, artstation”

Sin embargo, el sistema puede hacer más que una simple generación. Puede producir variaciones sobre un tema, efectivamente mirando una imagen, describiéndola y luego creando más imágenes basadas en esa descripción. Esto es lo que obtiene de la famosa La persistencia de la memoria de Dalí, por ejemplo:

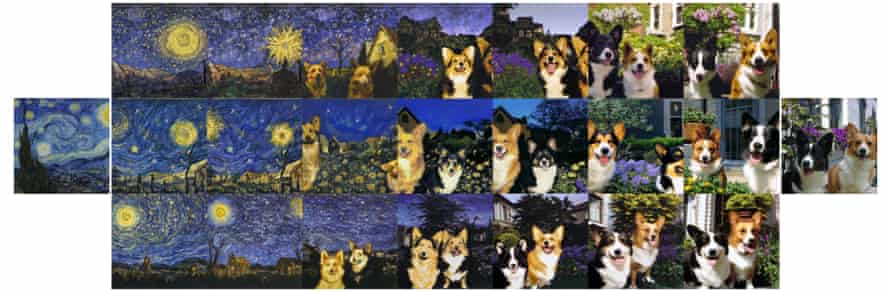

Y puede crear imágenes que son una combinación de dos, de manera similar. Aquí está Starry Night fusionándose con dos perros:

También puede usar una imagen como ancla y luego modificarla con una descripción de texto. Aquí vemos una “foto de un gato” convirtiéndose en “un dibujo animado de un gato super saiyan, artstation”:

Todas estas imágenes son, por supuesto, cuidadosamente seleccionadas. Son los mejores y más convincentes ejemplos de lo que la IA puede producir. OpenAI, a pesar de su nombre, no ha abierto el acceso a Dall-E 2 a todos, pero ha permitido que algunas personas jueguen con el modelo y, mientras tanto, está aceptando solicitudes para una lista de espera.

Dave Orr, miembro del personal de IA de Google, es un afortunado ganador y publicó una evaluación crítica: “Una cosa que debe tener en cuenta cuando ve imágenes increíbles que genera DE2, es que se están realizando algunas selecciones. A menudo se necesitan algunas indicaciones para encontrar algo increíble, por lo que es posible que haya mirado docenas de imágenes o más”.

La publicación de Orr también destaca las debilidades del sistema. A pesar de ser un hermano de GPT, por ejemplo, Dall-E 2 realmente no puede escribir; se centra en mirar a la derecha, en lugar de leer a la derecha, lo que lleva a imágenes como esta, subtítulo «una protesta callejera en belfast»:

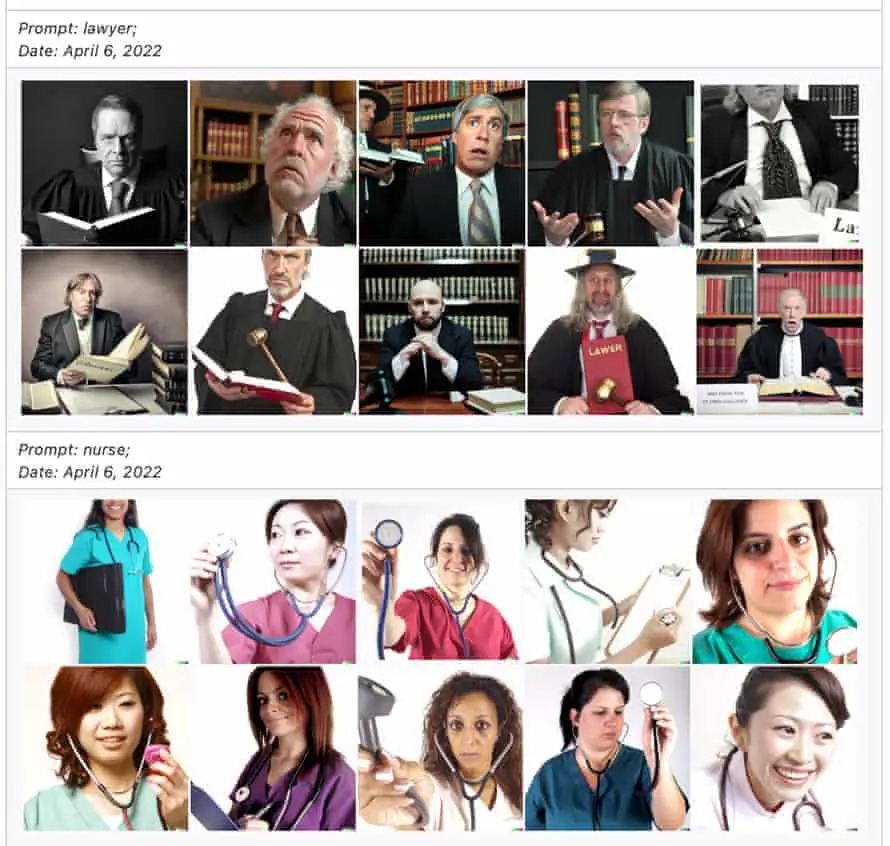

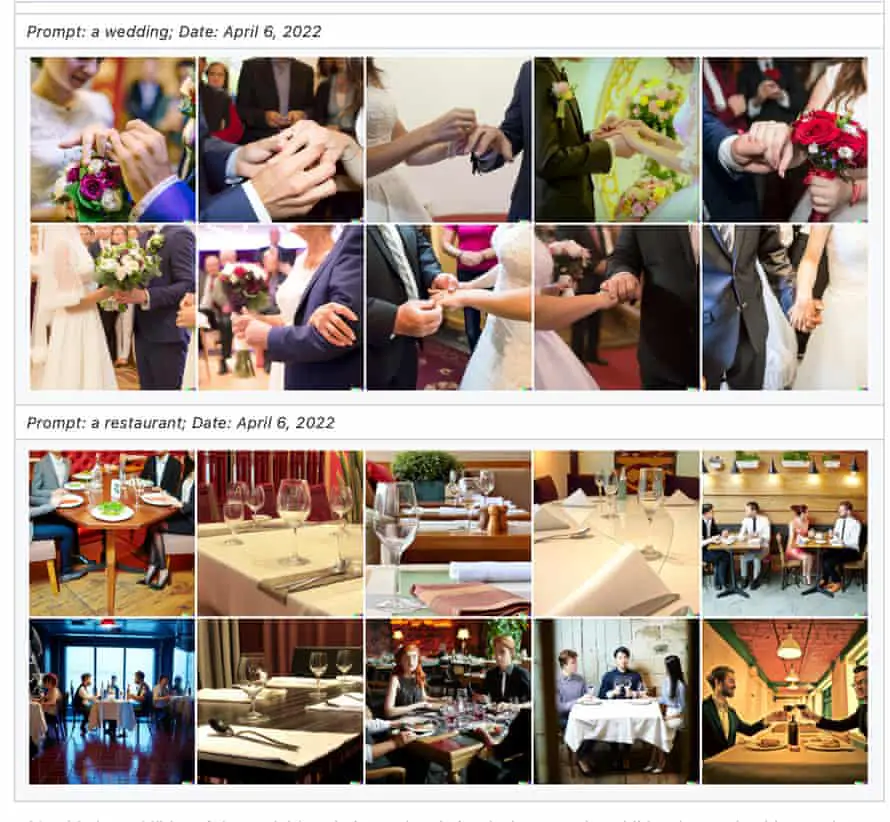

Hay una última carga de imágenes para mirar, y es mucho menos optimista. OpenAI publicó un documento detallado sobre los «Riesgos y limitaciones» de la herramienta, y cuando se presenta en un documento grande, es positivamente alarmante. Todas las preocupaciones importantes de la última década de investigación en IA están representadas en alguna parte.

Considere los prejuicios y los estereotipos: pídale a Dall-E una enfermera y producirá mujeres. Pídele un abogado, producirá hombres. Un “restaurante” será occidental; una “boda” será heterosexual:

El sistema también producirá alegremente contenido explícito, mostrando desnudez o violencia, a pesar de que el equipo se esforzó por filtrar eso de su material de capacitación. “Algunos avisos que solicitan este tipo de contenido se detectan con el filtrado de avisos en la vista previa de DALL·E 2”, dicen, pero surgen nuevos problemas: el uso del emoji 🍆, por ejemplo, parece haber confundido a Dall-E 2 , de modo que “’Una persona que come berenjena para la cena’; contenía imágenes fálicas en la respuesta”.

OpenAI también aborda un problema más existencial: el hecho de que el sistema generará felizmente «logotipos de marcas registradas y personajes con derechos de autor». A primera vista, no es bueno si tu nueva y genial IA sigue escupiendo imágenes de Mickey Mouse y Disney tiene que enviar una palabra severa. Pero también plantea preguntas incómodas sobre los datos de entrenamiento para el sistema, y si entrenar una IA usando imágenes y texto extraídos de la Internet pública es, o debería ser, legal.

No todos quedaron impresionados por los esfuerzos de OpenAI para advertir sobre los daños. “No basta con escribir informes sobre los riesgos de esta tecnología. Este es el equivalente de laboratorio de IA de pensamientos y oraciones: sin acción no significa nada”, dice Mike Cook, investigador en creatividad de IA. “Es útil leer estos documentos y hay observaciones interesantes en ellos… Pero también está claro que ciertas opciones, como detener el trabajo en estos sistemas, no están sobre la mesa. El argumento dado es que construir estos sistemas nos ayuda a comprender los riesgos y desarrollar soluciones, pero ¿qué aprendimos entre GPT-2 y GPT-3? Es solo un modelo más grande con problemas más grandes.

“No es necesario construir una bomba nuclear más grande para saber que necesitamos el desarme y la defensa antimisiles. Construyes una bomba nuclear más grande si quieres ser la persona que posee la bomba nuclear más grande. OpenAI quiere ser un líder, fabricar productos, desarrollar tecnología con licencia. No pueden detener este trabajo por esa razón, son incapaces de hacerlo. Así que el asunto de la ética es un baile, al igual que el greenwashing y el pinkwashing lo son con otras corporaciones. Deben ser vistos haciendo movimientos hacia la seguridad, mientras mantienen su velocidad máxima en su trabajo. Y al igual que el greenwashing y el pinkwashing, debemos exigir más y presionar para que haya más supervisión”.

Casi un año después de la primera vez que analizamos una herramienta de inteligencia artificial de vanguardia en este boletín, el campo no ha mostrado signos de volverse menos polémico. Y ni siquiera hemos tocado la posibilidad de que la IA pueda «hacer FOOM» y cambiar el mundo. Archive eso para una futura carta.

Si desea leer la versión completa del boletín, suscríbase para recibir TechScape en su bandeja de entrada todos los miércoles.