Por Bidisha Saha: El recuento de la cantidad de trabajos amenazados por la tecnología de IA generativa que cambia el mundo depende de si el GPT con inteligencia humana lo hace más productivo o lo vuelve obsoleto.

Ya no es sorprendente si te encuentras con un tweet, ensayo o artículo de noticias y te preguntas si fue escrito por un software de inteligencia artificial. Existen dudas sobre la autoría de un determinado escrito, como en el contexto académico, laboral o la veracidad del contenido. Del mismo modo, hay dudas sobre la autenticidad de la información, es decir, si una idea engañosa aparece repentinamente en publicaciones en Internet, ¿se está propagando orgánicamente o las publicaciones han sido generadas por IA para crear la apariencia de una tracción real?

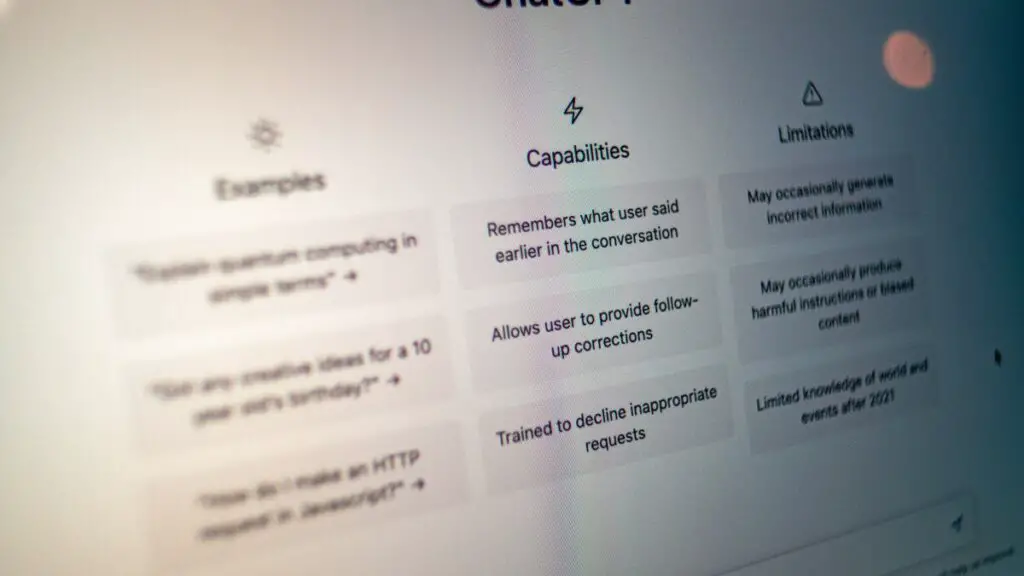

El núcleo de un chatbot generativo de IA como ChatGPT o GPT-3 es algo llamado Modelo de lenguaje grande (LLM), que es un algoritmo que imita la forma del lenguaje escrito. Aunque el telón de fondo de dicho algoritmo es complejo y opaco, la idea es bastante simple. Los GPT (Transformadores preentrenados generativos) se alimentan con montones de información de Internet, para predecir repetidamente las siguientes palabras y luego usar un mecanismo de calificación para mejorar su respuesta y escribir la cosa real.

Las herramientas para identificar si un fragmento de texto fue escrito por AI han comenzado a surgir en los últimos meses, incluida una creada por OpenAI, la compañía detrás de ChatGPT. Esta herramienta utiliza un modelo de IA entrenado para detectar diferencias entre el texto generado y el escrito por humanos. Pero identificar texto generado por IA se está volviendo cada vez más difícil a medida que el software como ChatGPT continúa avanzando y produce texto que es más convincentemente humano.

Para evaluar la efectividad de la tecnología actual de detección de IA, el equipo OSINT (Investigaciones de código abierto) de India Today analiza algunos de estos detectores utilizando contenido generado artificialmente por OpenAI. Los resultados muestran que los servicios de detección de IA avanzan rápidamente, pero a veces aún se quedan cortos.

Tres muestras de extractos escritos por ChatGPT de OpenAI son examinados por detectores en línea como Winston, AI Text Classifier de OpenAI, GPTZero y CopyLeaks. Para la primera pregunta, queríamos que la GPT resumiera una parte del contenido ya publicado. En este caso, al menos dos detectores no pudieron identificar el artículo escrito por ChatGPT, mientras que solo uno predijo el resultado correctamente y el otro predijo una probabilidad de 50-50.

En el segundo caso, le pedimos a ChatGPT que escribiera sobre los efectos ambientales de una erupción volcánica, que es un peligro geológico recurrente, y la información relacionada está ampliamente disponible en código abierto. En este caso, a excepción de AI Text Classifier, todas las demás plataformas pudieron predecir que el texto se generó artificialmente.

En el último intento, solicitamos a ChatGPT que escribiera una historia cargada de emociones con un clímax impactante. Se dio la indicación para verificar si la herramienta en sí puede generar contenido con valor artístico. Curiosamente, tres de los cuatro detectores no pudieron predecir el contenido como generado por IA.

La tecnología de detección ha sido anunciada como una forma de mitigar el daño del contenido generado por IA. Muchas de las empresas detrás de los detectores de IA reconocieron que sus herramientas eran imperfectas y advirtieron sobre una carrera armamentista tecnológica. Las empresas de detección de IA dicen que sus servicios están diseñados para ayudar a promover la transparencia y la rendición de cuentas, ayudando a señalar la desinformación, el fraude, la pornografía no consentida, la deshonestidad artística y otros abusos de la tecnología.

LA RÁPIDA PROLIFERACIÓN DEL CONTENIDO AUTOMATIZADO

NewsGuard, una empresa que rastrea la información errónea en línea, y ShadowDragon, una empresa que proporciona recursos y capacitación para investigaciones digitales, publicaron dos informes por separado.

Según el informe, docenas de sitios web de noticias marginales, granjas de contenido y revisores falsos están utilizando inteligencia artificial para crear contenido fabricado en línea. NewsGuard identificó 125 sitios web, que van desde noticias hasta informes de estilo de vida, y se publicaron en 10 idiomas, con contenido escrito en su totalidad o en su mayoría con herramientas de IA.

Los sitios incluían un portal de información de salud que publicó más de 50 artículos generados por IA que ofrecían consejos médicos. ShadowDragon también encontró contenido no auténtico en los principales sitios web y redes sociales, incluido Instagram, y en las reseñas de Amazon. Los sitios web a menudo estaban llenos de anuncios, lo que sugería que el contenido no auténtico se producía para generar clics y generar ingresos publicitarios para los propietarios del sitio web.

El contenido engañoso de la IA incluía eventos fabricados, consejos médicos y engaños sobre la muerte de celebridades, según los informes, lo que generó nuevas preocupaciones de que la tecnología transformadora podría remodelar rápidamente el panorama de la desinformación en línea. El riesgo inminente de la automatización también contribuye a amenazar una serie de puestos de trabajo incluso antes de lo que imaginamos.

Aunque, Google tomó una postura el año pasado de que no le gusta el contenido generado por IA y algunos incluso especularon que Google también podría penalizar a aquellos que usan IA para escribir contenido. Sin embargo, Danny Sullivan de Google dijo recientemente que no se preferirá ningún contenido escrito solo para los motores de búsqueda principalmente para las clasificaciones, independientemente de si ha sido escrito por una IA o por un ser humano.

¿CÓMO LA MARCA DE AGUA PUEDE PREDECIR EL CONTENIDO AUTOMATIZADO?

El mecanismo de decodificación de ChatGPT, que se basa en el modelo de lenguaje grande, considera muchas opciones para cada palabra generada, teniendo en cuenta la respuesta que ha escrito hasta el momento y el aviso que se le solicita. Luego asigna una puntuación a cada opción de la lista, que cuantifica la probabilidad de que la palabra aparezca a continuación, en función de la gran cantidad de texto escrito por humanos que ha analizado y los patrones y la relación de las palabras con las frases. Luego, elige una palabra con una puntuación alta y pasa a la siguiente.

La salida del LLM a menudo es tan sofisticada que puede parecer que el chatbot entiende lo que está diciendo, pero no es así. Cada elección que hace está determinada por matemáticas complejas y enormes cantidades de datos. Tanto es así que a menudo produce un texto coherente y preciso.

Investigadores de la Universidad de Maryland han discutido cómo funcionan los métodos de marca de agua en los modelos de lenguaje. Con la marca de agua, el fabricante del modelo entrega la salida de su modelo con huellas dactilares únicas que son imperceptibles para los humanos pero que se marcan con la ayuda de las estadísticas. Funciona ‘incrustando marcadores o firmas ocultos dentro del texto generado para permitir la trazabilidad y la verificación de propiedad’.

Digamos que tenemos 50 000 palabras en inglés que el modelo de lenguaje conoce, lo que se conoce como el ‘conjunto de datos portador’. Cuando el GPT está muestreando la palabra más probable de la distribución de probabilidad predicha, modifica la salida al incluir en la lista negra al menos el 20 por ciento del conjunto de datos del portador e introducir cambios específicos en los ejemplos de entrenamiento, todo mientras mantiene intacto el significado general. Estos cambios incluyen sustituciones de palabras, eliminaciones y reordenamientos cuidadosamente elaborados para codificar la marca de agua.

Entonces, el modelo de lenguaje para decodificar puede elegir del resto del 80 por ciento de las palabras. La semilla del generador de números aleatorios que elige qué palabras están en la lista negra es la última palabra de la entrada. Esto permite que el subconjunto de palabras de la lista negra se reconstruya cada vez. Este procedimiento se aplica en cada generación del siguiente token, donde para cada palabra siguiente, la última palabra se usa como semilla para incluir en la lista negra el 20 por ciento del conjunto de datos del portador.

Para detectar el texto generado a partir de este modelo de lenguaje, el detector revisa el texto generado y cuenta las palabras de la lista negra. El modelo de lenguaje con marca de agua no usaría las palabras de la lista negra, pero los humanos definitivamente usarían los términos de la lista negra. Una herramienta de detección que supiera qué palabras están en la lista especial podría diferenciar entre el texto generado y el escrito por una persona.

Si alguien intentara eliminar una marca de agua editando el texto, no sabría qué palabras cambiar. E incluso si lograran cambiar algunas de las palabras especiales, lo más probable es que solo reduzcan el porcentaje total en un par de puntos.

Aún así, la herramienta ‘única’ que puede detectar de manera confiable todo el texto generado por IA con total precisión puede estar fuera de su alcance, a menos que las empresas en el campo de IA acuerden una implementación de marca de agua estándar y requiera mucha ingeniería.