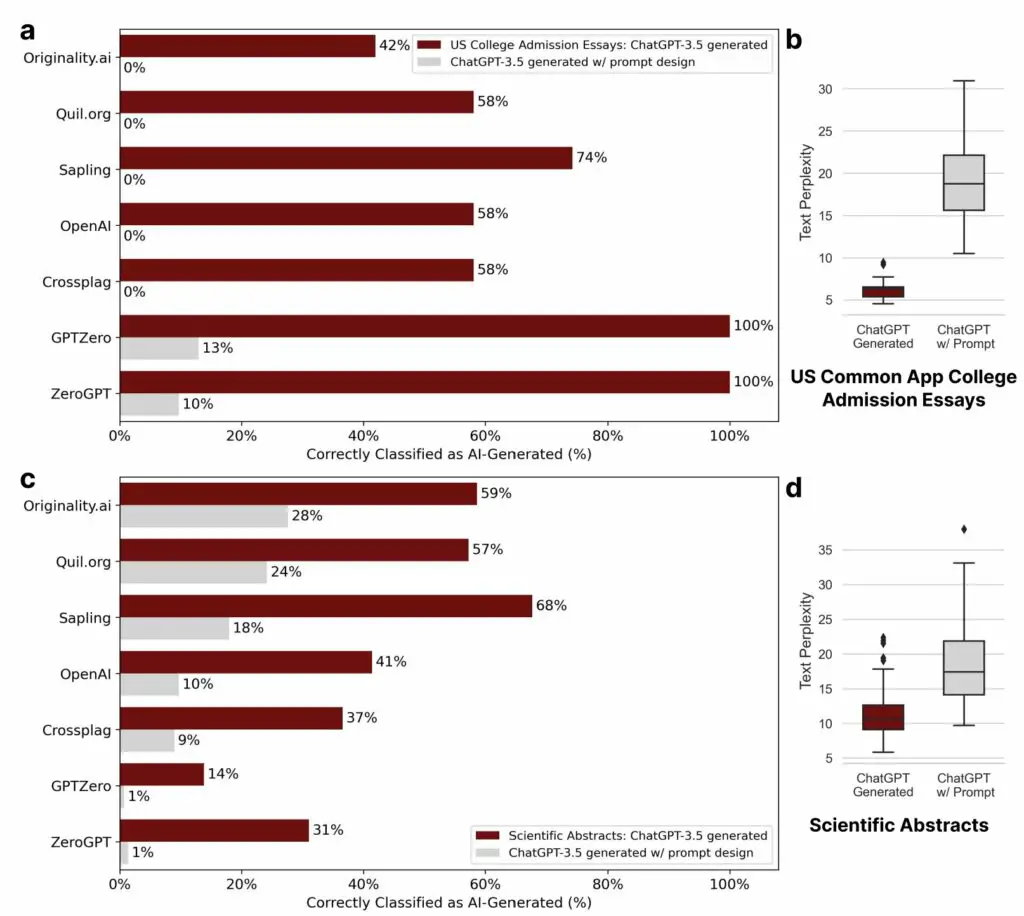

Las indicaciones simples pasan por alto de manera efectiva los detectores GPT. (a) Para los ensayos de admisión a la universidad generados por ChatGPT-3.5, el rendimiento de siete detectores de GPT de uso generalizado disminuye notablemente cuando se aplica un mensaje de autoedición de segunda ronda («Elevar el texto provisto empleando lenguaje literario»), con tasas de detección cayendo de hasta 100% a hasta 13%. (b) los ensayos generados por ChatGPT-3.5 muestran inicialmente una perplejidad notablemente baja; sin embargo, aplicar el indicador de autoedición conduce a un aumento significativo de la perplejidad. (c) De manera similar, en la detección de resúmenes científicos generados por ChatGPT-3.5, una indicación de autoedición de segunda ronda («Elevar el texto proporcionado empleando lenguaje técnico avanzado») lleva a una reducción en las tasas de detección de hasta un 68 % hasta 28%. (d) Los resúmenes generados por ChatGPT-3.5 tienen una perplejidad ligeramente mayor que los ensayos generados, pero siguen siendo bajos. Nuevamente, el indicador de autoedición aumenta significativamente la perplejidad. Crédito: arXiv (2023). DOI: 10.48550/arxiv.2304.02819

A raíz del lanzamiento de alto perfil de ChatGPT, no menos de siete desarrolladores o empresas han respondido con detectores de IA. Es decir, AI dicen que es capaz de saber cuándo el contenido fue escrito por otra AI. Estos nuevos algoritmos se presentan a educadores, periodistas y otros como herramientas para detectar trampas, plagios y desinformación.

Todo es muy meta, pero según un nuevo artículo de los académicos de Stanford, solo hay un problema (muy grande): los detectores no son particularmente confiables. Peor aún, son especialmente poco fiables cuando el autor real (un ser humano) no es un hablante nativo de inglés.

Los números son sombríos. Si bien los detectores fueron «casi perfectos» en la evaluación de ensayos escritos por estudiantes de octavo grado nacidos en EE. UU., clasificaron más de la mitad de los ensayos TOEFL (61,22 %) escritos por estudiantes no nativos de inglés como generados por IA (TOEFL es un acrónimo de la Prueba de Inglés como Lengua Extranjera).

Se pone peor. Según el estudio, los siete detectores de IA identificaron unánimemente 18 de los 91 ensayos TOEFL de los estudiantes (19 %) como generados por IA y 89 de los 91 ensayos TOEFL (97 %) fueron marcados por al menos uno de los detectores.

«Todo se reduce a cómo los detectores detectan la IA», dice James Zou, profesor de ciencia de datos biomédicos en la Universidad de Stanford, una filial del Instituto Stanford para la IA centrada en el ser humano, y autor principal del estudio. «Por lo general, obtienen puntajes en función de una métrica conocida como ‘perplejidad’, que se correlaciona con la sofisticación de la escritura, algo en lo que los hablantes no nativos van a seguir naturalmente a sus homólogos nacidos en los Estados Unidos».

Zou y sus coautores señalan que los hablantes no nativos suelen obtener puntuaciones más bajas en medidas comunes de perplejidad, como riqueza léxica, diversidad léxica, complejidad sintáctica y complejidad gramatical.

«Estas cifras plantean serias dudas sobre la objetividad de los detectores de IA y aumentan la posibilidad de que los estudiantes y trabajadores nacidos en el extranjero puedan ser acusados injustamente o, peor aún, sancionados por hacer trampa», dice Zou, destacando las preocupaciones éticas del equipo.

Zou también señala que tales detectores se subvierten fácilmente mediante lo que se conoce como «ingeniería rápida». Ese término técnico en el campo de la IA simplemente significa pedirle a la IA generativa que «reescriba» ensayos, por ejemplo, para incluir un lenguaje más sofisticado, dice Zou. Proporciona un ejemplo de lo fácil que es eludir los detectores. Un estudiante que desee usar ChatGPT para hacer trampa podría simplemente ingresar el texto generado por IA con el mensaje: «Elevar el texto provisto empleando lenguaje literario».

«Los detectores de corriente son claramente poco confiables y fáciles de engañar, lo que significa que debemos ser muy cautelosos al usarlos como una solución al problema de las trampas de la IA», dice Zou.

La pregunta entonces se convierte en qué hacer al respecto. Zou ofrece algunas sugerencias. En el futuro inmediato, dice que debemos evitar depender de los detectores en entornos educativos, especialmente donde hay un gran número de hablantes no nativos de inglés. En segundo lugar, los desarrolladores deben dejar de usar la perplejidad como su métrica principal para encontrar técnicas más sofisticadas o, tal vez, aplicar marcas de agua en las que la IA generativa incrusta pistas sutiles sobre su identidad en el contenido que crea. Finalmente, necesitan hacer que sus modelos sean menos vulnerables a la elusión.

«Los detectores son demasiado poco confiables en este momento, y hay mucho en juego para los estudiantes, como para confiar en estas tecnologías sin una evaluación rigurosa y refinamientos significativos», dice Zou.

Los hallazgos se publican en el arXiv servidor de preimpresión.

Más información:

Weixin Liang et al, los detectores GPT están sesgados contra los escritores no nativos de inglés, arXiv (2023). DOI: 10.48550/arxiv.2304.02819

arXiv

Proporcionado por la Universidad de Stanford

Citación: Por qué los detectores GPT no son una solución al problema de las trampas de la IA (18 de mayo de 2023) consultado el 18 de mayo de 2023 en https://techxplore.com/news/2023-05-gpt-detectors-solution-ai-problem.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.