Las técnicas de aprendizaje continuo de pocos disparos permiten que los modelos de IA aprendan de un flujo continuo de tareas descritas por un pequeño conjunto de muestras sin olvidar la información aprendida previamente. Este paradigma de aprendizaje es beneficioso en aplicaciones del mundo real, como la robótica industrial, donde un agente desplegado debe aprender en un entorno dinámico con observaciones limitadas, y en la preservación de la privacidad, donde el entrenamiento secuencial comparte solo los pesos del modelo sin exponer los datos.

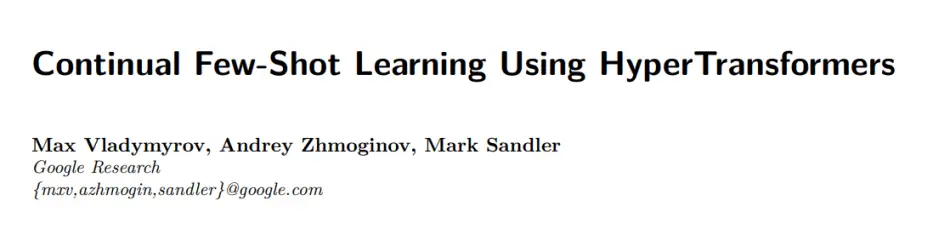

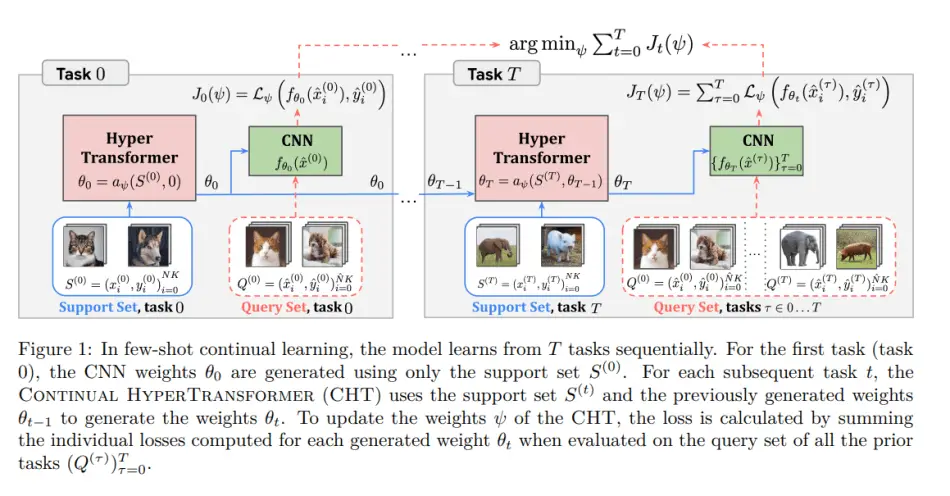

Un equipo de Google Research avanza en esta dirección de investigación en el nuevo artículo. Aprendizaje continuo de pocos disparos usando HyperTransformersproponiendo Continual HyperTransformer (CHT), un modelo que modifica el recientemente publicado HyperTransformer (HT, Zhmoginov et al., 2022) para actualizar secuencialmente los pesos de una red neuronal convolucional (CNN) en función de la información en una nueva tarea sin olvidar el conocimientos adquiridos en tareas anteriores.

El documento describe las principales ventajas del enfoque CHT propuesto de la siguiente manera:

- CHT puede generar y actualizar los pesos de la CNN sobre la marcha sin necesidad de capacitación.

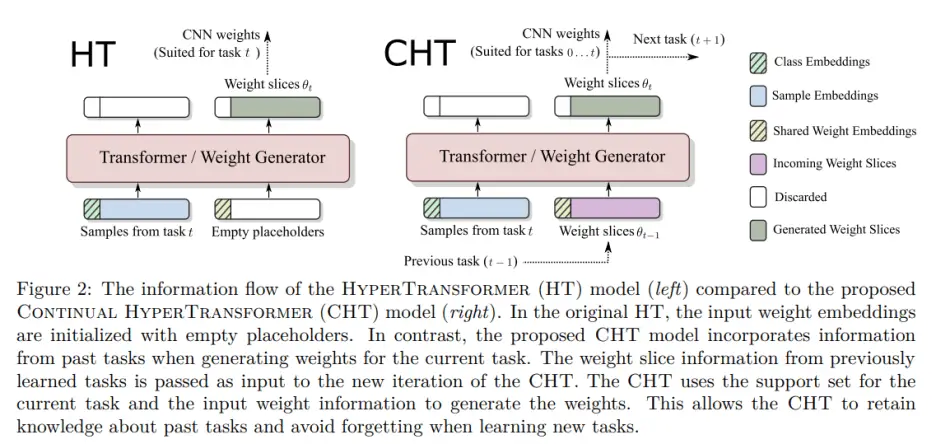

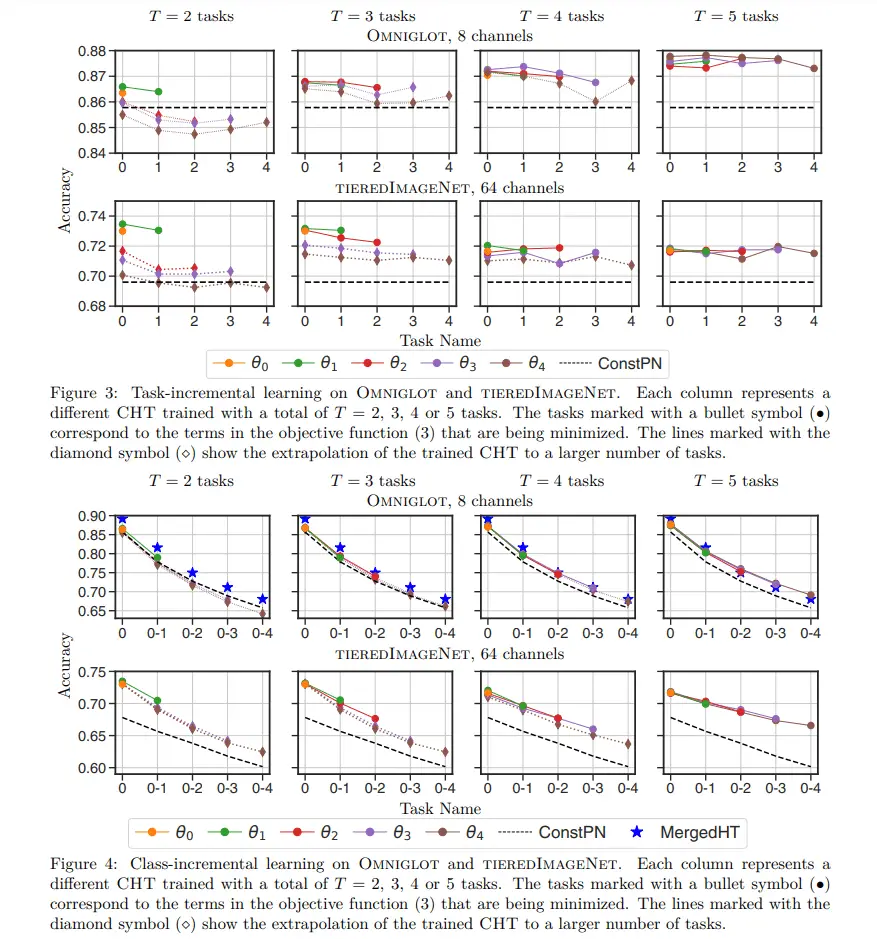

- Los modelos aprendidos con CHT no sufren de olvido catastrófico. Incluso vemos casos de transferencia hacia atrás positiva para modelos más pequeños, donde el rendimiento en una tarea determinada en realidad mejora para los pesos generados posteriormente.

- Si bien el CHT está capacitado para optimizar para T tareas, el modelo se puede detener en cualquier punto t ≤ T durante la inferencia con pesos θt que son adecuados para todas las tareas 0 ≤ τ ≤ t.

- El modelo CHT está diseñado para ser independiente de un paso específico y operar como un sistema recurrente. Se puede utilizar para aprender una mayor cantidad de tareas para las que se entrenó originalmente.

Dado un conjunto de pesos CNN generados a partir de tareas encontradas anteriormente y una descripción de una nueva tarea, el modelo CHT propuesto tiene como objetivo actualizar los pesos para que sean adecuados para todas las tareas anteriores, así como para la nueva tarea.

Los investigadores amplían el enfoque HT para permitir que CHT maneje un flujo continuo de tareas mediante el uso de los pesos generados a partir de tareas ya aprendidas como incrustaciones de pesos de entrada en el generador de pesos para nuevas tareas. También cambian la función de pérdida de entropía cruzada de HT a una pérdida prototípica más flexible (Snell et al., 2017) que emplea prototipos como una representación aprendida de cada clase de todas las tareas.

Su enfoque de aprendizaje continuo «preventivo» permite que el modelo CHT se entrene en tareas (T) y se ejecute en cualquier número de tareas (τ < T) mientras produce pesos de buen rendimiento (θτ) para todas sus tareas vistas hasta ese punto. generando así los pesos CNN sobre la marcha sin ningún entrenamiento adicional.

La arquitectura CHT propuesta es recurrente: debido a que los parámetros HT no dependen de la información de la tarea, sino que toman los pesos y el conjunto de soporte como entrada, el modelo entrenado puede aprender a generar pesos para cualquier tarea adicional no vista. Los investigadores también demuestran que CHT no sufre el catastrófico problema de olvido que ha afectado a otros enfoques de aprendizaje secuencial e incluso puede dar lugar a transferencias hacia atrás que mejoran el rendimiento en tareas previamente aprendidas.

En su estudio empírico, el equipo comparó CHT con los modelos de línea de base de Constant ProtoNet (ConstPN) y Merged HyperTransformer (MergedHT) en escenarios incrementales de tareas y de clases. En las evaluaciones, CHT superó consistentemente a ConstPN y superó a MergedHT cuando recibió capacitación en más tareas.

Este trabajo valida el CHT propuesto como un aprendiz eficiente de pocos disparos libre del problema de olvido catastrófico y adecuado para varios escenarios de uso.

El papel Aprendizaje continuo de pocos disparos usando HyperTransformers está en arXiv.

Autor: Hécate He | Editor: Michael Sarazen

Sabemos que no quiere perderse ninguna noticia o avance de investigación. Suscríbete a nuestro popular boletín IA global sincronizada semanalmente para recibir actualizaciones semanales de IA.

Me gusta esto:

Cargando…