«Hasta que se establezcan salvaguardas gubernamentales significativas para proteger al público de los daños de la IA generativa, necesitamos una pausa».

Así lo dice un informe sobre los peligros de la inteligencia artificial (IA) publicado el martes por Public Citizen. Noble Lo siento por adelantado! La prisa rápida por implementar IA generativa pone en riesgo una amplia gama de daños automatizadosel análisis de los investigadores Rick Claypool y Cheyenne Hunt tiene como objetivo «replantear la conversación en torno a la IA generativa para garantizar que el público y los legisladores tengan voz sobre cómo estas nuevas tecnologías podrían cambiar nuestras vidas».

Tras el lanzamiento en noviembre de ChatGPT de OpenAI, las herramientas de IA generativa han estado recibiendo «una gran cantidad de comentarios, especialmente entre las corporaciones Big Tech mejor posicionadas para beneficiarse de ellas», señala el informe. «Los impulsores más entusiastas dicen que la IA cambiará el mundo de manera que todos se volverán ricos, y algunos detractores dicen que podría matarnos a todos. Aparte de las amenazas aterradoras que pueden materializarse a medida que la tecnología evoluciona, los daños del mundo real son la prisa por liberar y monetizar estas herramientas pueden causar y, en muchos casos, ya están causando».

Claypool y Hunt clasificaron estos daños en «cinco áreas amplias de preocupación»:

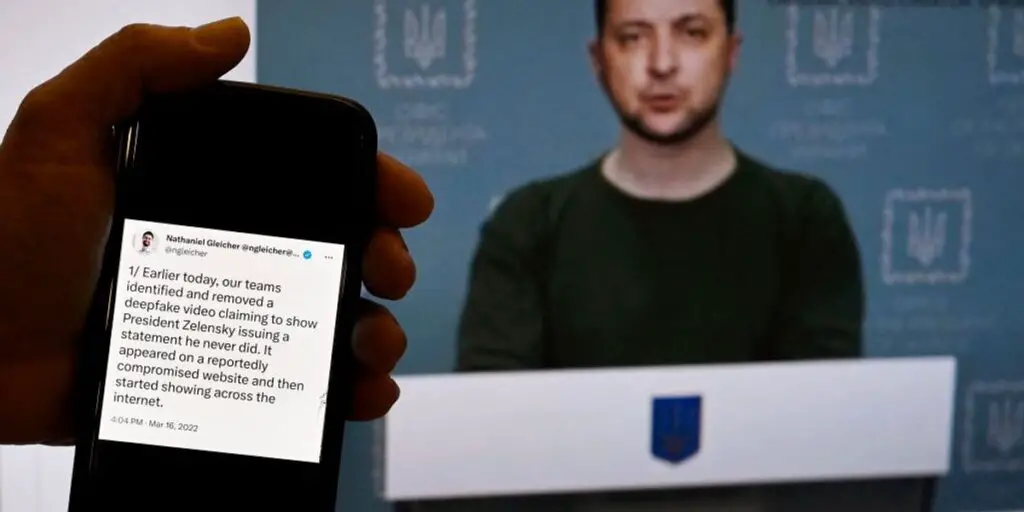

- Daños a la democracia: Los robots de spam que difunden información errónea no son nuevos, pero las herramientas generativas de inteligencia artificial permiten que los malos actores produzcan en masa contenido político engañoso. Las herramientas de IA de producción de audio y video cada vez más poderosas están haciendo que el contenido auténtico sea más difícil de distinguir [from] contenido sintético.

- Preocupaciones del consumidor: Las empresas que intentan maximizar las ganancias utilizando la IA generativa están utilizando estas herramientas para engullir los datos de los usuarios, manipular a los consumidores y concentrar las ventajas entre las corporaciones más grandes. Los estafadores los están utilizando para participar en esquemas de estafa cada vez más sofisticados.

- Empeoramiento de la desigualdad: Las herramientas de IA generativa corren el riesgo de perpetuar y exacerbar sesgos sistémicos como [as] racismo [and] sexismo Brindan a los acosadores y abusadores nuevas formas de dañar a las víctimas y, si su despliegue generalizado resulta consecuente, corren el riesgo de acelerar significativamente la desigualdad económica.

- Socavando los derechos de los trabajadores: Las empresas que desarrollan herramientas de IA utilizan textos e imágenes creados por humanos para entrenar a sus modelos y emplean a trabajadores con salarios bajos en el extranjero para ayudar a filtrar el contenido perturbador y ofensivo. Automatizar la creación de medios, como lo hace alguna IA, corre el riesgo de descualificar y reemplazar el trabajo de producción de medios realizado por humanos.

- Preocupaciones ambientales: La capacitación y el mantenimiento de herramientas de IA generativa requieren expansiones significativas en el poder de cómputo, expansiones en el poder de cómputo que están aumentando más rápido que la capacidad de los desarrolladores de tecnología para absorber las demandas con avances en eficiencia. Se espera que el despliegue masivo requiera que algunas de las compañías tecnológicas más grandes aumenten su poder de cómputo y, por lo tanto, sus huellas de carbono, en cuatro o cinco veces.

En un comunicado, Public Citizen advirtió que «las empresas están implementando herramientas de inteligencia artificial potencialmente peligrosas más rápido de lo que pueden comprender o mitigar sus daños».

«La historia no ofrece ninguna razón para creer que las corporaciones pueden autorregularse para eliminar los riesgos conocidos, especialmente porque muchos de estos riesgos son una parte tan importante de la IA generativa como de la avaricia corporativa», continúa la declaración. «Las empresas que se apresuran a introducir estas nuevas tecnologías están jugando con la vida y el sustento de las personas, y posiblemente con los cimientos mismos de una sociedad libre y un mundo habitable».

El jueves 27 de abril, Public Citizen organizará una conferencia híbrida en persona/Zoom en Washington, DC, durante la cual el representante estadounidense Ted Lieu (D-Calif.) y otros 10 panelistas discutirán las amenazas que plantea la IA y cómo controlar la industria de rápido crecimiento pero virtualmente no regulada. Las personas interesadas en participar deben registrarse hasta este viernes.

«Las empresas que se apresuran a introducir estas nuevas tecnologías están jugando con la vida y el sustento de las personas, y posiblemente con los cimientos mismos de una sociedad libre y un mundo habitable».

Las demandas para regular la IA están aumentando. El mes pasado, Geoffrey Hinton, considerado el «padrino de la inteligencia artificial», comparó los impactos potenciales de la tecnología que avanza rápidamente con «la Revolución Industrial, o la electricidad, o tal vez la rueda».

Preguntado por

Noticias CBSBrook Silva-Braga sobre la posibilidad de que la tecnología «aniquile a la humanidad», advirtió Hinton que «no es inconcebible».

Ese potencial aterrador no se encuentra necesariamente en las herramientas de IA existentes como ChatGPT, sino en lo que se llama «inteligencia general artificial» (AGI), a través de la cual las computadoras desarrollan y actúan sobre sus propias ideas.

«Hasta hace poco, pensé que pasarían de 20 a 50 años antes de que tuviéramos IA de propósito general», dijo Hinton.

Noticias CBS. «Ahora creo que pueden ser 20 años o menos». Eventualmente, Hinton admitió que no descartaría la posibilidad de que AGI llegara dentro de cinco años, una diferencia importante con respecto a hace unos años, cuando «habría dicho: ‘De ninguna manera'».

«Tenemos que pensar mucho sobre cómo controlar eso», dijo Hinton. Cuando Silva-Braga le preguntó si eso es posible, Hinton dijo: «No lo sabemos, aún no hemos estado allí, pero podemos intentarlo».

El pionero de la IA está lejos de estar solo. En febrero, el CEO de OpenAI, Sam Altman, escribió en una publicación de blog de la empresa: «Los riesgos podrían ser extraordinarios. Una AGI superinteligente desalineada podría causar un daño grave al mundo».

Más de 26.000 personas han firmado una carta abierta publicada recientemente que pide una moratoria de seis meses en el entrenamiento de sistemas de IA más allá del nivel del último chatbot de OpenAI, GPT-4, aunque Altman no se encuentra entre ellos.

«Los sistemas de inteligencia artificial potentes deben desarrollarse solo una vez que estemos seguros de que sus efectos serán positivos y sus riesgos serán manejables», dice la carta.

Si bien aún faltan algunos años para AGI, el nuevo informe de Public Citizen deja en claro que las herramientas de inteligencia artificial existentes, incluidos los chatbots que escupen mentiras, las aplicaciones de intercambio de rostros que generan videos falsos y las voces clonadas que cometen fraude, ya están causando o amenazan con causar daños graves. incluyendo la intensificación de la desigualdad, socavar la democracia, desplazar a los trabajadores, aprovecharse de los consumidores y exacerbar la crisis climática.

Estas amenazas «son todas muy reales y es muy probable que ocurran si se permite a las corporaciones implementar IA generativa sin barandillas que se puedan hacer cumplir», escribieron Claypool y Hunt. «Pero no hay nada inevitable en ellos».

Continuaron:

La regulación gubernamental puede impedir que las empresas implementen las tecnologías demasiado rápido (o bloquearlas por completo si resultan inseguras). Puede establecer estándares para proteger a las personas de los riesgos. Puede imponer deberes a las empresas que utilizan IA generativa para evitar daños identificables, respetar los intereses de las comunidades y los creadores, probar sus tecnologías, asumir la responsabilidad y aceptar la responsabilidad si las cosas salen mal. Puede exigir que se incorpore equidad en las tecnologías. Puede insistir en que si la IA generativa, de hecho, aumenta la productividad y desplaza a los trabajadores, o que los beneficios económicos se compartan con los perjudicados y no se concentren en un pequeño círculo de empresas, ejecutivos e inversores.

En medio del «creciente interés regulatorio» en un «mecanismo de responsabilidad» de IA, la administración Biden anunció la semana pasada que está buscando opiniones públicas sobre las medidas que podrían implementarse para garantizar que «los sistemas de IA sean legales, efectivos, éticos, seguros y confiables». .»

De acuerdo aAxiosel líder de la mayoría del Senado, Chuck Schumer (DN.Y.), está «dando los primeros pasos hacia la legislación para regular la tecnología de inteligencia artificial».

En palabras de Claypool y Hunt: «Necesitamos fuertes salvaguardas y regulaciones gubernamentales, y las necesitamos antes de que las corporaciones difundan ampliamente la tecnología de IA. Hasta entonces, necesitamos una pausa».