Ver la IA a través de una lente del futuro lejano socava la necesidad de una acción política en el presente para abordar los desafíos que plantean sistemas como ChatGPT.

Los modelos de lenguaje grande (LLM) ChatGPT de OpenAI, lanzados en noviembre de 2022, y su sucesor GPT-4, lanzado en marzo de 2023, han atraído mucha atención del público en general, generando tanto promesas como preocupaciones.

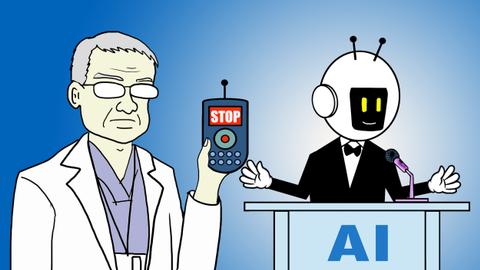

En vista de este desarrollo, el Instituto Futuro de la Vida publicó una Carta Abierta a “Pausa [the] Experimento de IA gigante” el 28 de marzo. Los autores de la carta piden una moratoria en el entrenamiento de grandes modelos de lenguaje durante seis meses, planteando el escenario de una “superinteligencia” que conduce a la extinción de la humanidad, también conocida como riesgo existencial o x -riesgo. Según el cofundador del Future of Life Institute, Jann Tallinn, la IA deshonesta representa un peligro mayor que la crisis climática.

La carta señala: «Debería ¿Dejamos que las máquinas inunden nuestros canales de información con propaganda y mentiras? Debería ¿Automatizamos todos los trabajos, incluidos los de cumplimiento? Debería desarrollamos mentes no humanas que eventualmente podrían superarnos en número, astucia, obsolescencia y reemplazo? Debería corremos el riesgo de perder el control de nuestra civilización?

Ha habido muchas críticas y desacuerdos con la carta, sobre todo del Instituto de Investigación de IA Distribuida (DAIR), fundado por Timnit Gebru. Esto se debe a que el marco de la narrativa de la carta está destinado a asustar a las personas mientras comercializa las «herramientas demasiado poderosas» que deben ser domesticadas, lo que en general alimenta la exageración de la IA.

La ideología que subyace a las preocupaciones expresadas por el Future of Life Institute es el llamado largoplacismo. Su objetivo es maximizar el bienestar humano en las décadas, si no en los siglos o milenios venideros, a expensas del presente. Famosos defensores del largoplacismo son ahora el deshonrado CEO de FTX, Sam Bankman-Fried, el CEO de Twitter y SpaceX, Elon Musk, el controvertido empresario Peter Thiel y el filósofo transhumanista Nick Bostrom, quien señala: “el valor esperado de reducir el riesgo existencial en una mera millonésima parte de un porcentaje punto es al menos diez veces el valor de mil millones de vidas humanas”.

El telón de fondo racista del largoplacismo toma la forma de lo que Abeba Birhane llama “colonialismo digital”, que repite siglos de opresión en beneficio de la visión de una élite de multimillonarios tecnológicos de “lo bueno para la humanidad”, que incluye colonizar el espacio o trascender nuestra mortalidad. .

Sin embargo, esta tecno-utopía, para la que es necesaria una “IA segura” para la singularidad deseada, distrae de los apremiantes problemas actuales.

Costos ocultos de la ‘superinteligencia’

Si bien estos sistemas parecen ser «autónomos» e «inteligentes», todavía dependen de una gran cantidad de trabajo humano. Como muestra Kate Crawford, esto comienza con la extracción de minerales y la fabricación de hardware. A continuación, los datos, que a menudo se extraen sin ningún consentimiento, deben etiquetarse para darles significado, y el contenido ofensivo, sexual o violento debe marcarse.

Este trabajo explotador, psicológicamente angustioso y mal pagado se lleva a cabo de manera invisible en un segundo plano. Entonces, en lugar de “automatizar todos los trabajos”, el resultado es un empeoramiento de las desigualdades sociales y una centralización del poder.

Otro problema con la idea de una «superinteligencia» es que da la falsa impresión de que los LLM son entidades sensibles que entienden y quizás incluso tienen sentimientos o empatía. Como resultado, las personas tienden a confiar demasiado en los resultados de los LLM, como en el trágico caso que llevó a un hombre al suicidio después de interactuar con un chatbot durante varias semanas. Otro chatbot médico que hace uso de GPT-3 también sugirió suicidarse o comenzar a reciclar para superar la tristeza. Esto último suena a despropósito. Pero los LLM simplemente unen palabras que suenan plausibles, lo que puede resultar en resultados absurdos, inexactos, dañinos y engañosos, como un artículo que menciona los beneficios de comer vidrio triturado.

Ante esto, podría surgir la pregunta de qué justifica el uso de GPT. ¿Qué problema intentan resolver los LLM? Además, considere que consumen energía a un “ojos llorosos” tasa: se estima que solo entrenar un solo modelo como GPT-3 consume tanta electricidad como 120 hogares estadounidenses por año y produce emisiones de dióxido de carbono equivalentes a las de 110 automóviles por año.

Necesidad de transparencia y rendición de cuentas

Por lo tanto, la idea subyacente de detener la capacitación adicional de los LLM para la gobernanza parece favorable. La carta abierta, sin embargo, no establece quién se vería afectado por esta pausa y cómo hacerla cumplir o garantizarla. Es ingenuo pensar que todas las empresas, universidades, institutos de investigación o cualquier persona que haga uso de diversas alternativas de código abierto simplemente se detendrán.

Al mismo tiempo, los LLM actualmente en curso persistirán con sus implicaciones. Y, sin embargo, Microsoft, que ha realizado una inversión multimillonaria en OpenAI, y el director ejecutivo de Twitter, Elon Musk, que donó 10 millones de dólares al Future of Life Institute y es miembro de su junta, han despedido a sus equipos de ética.

Como primera respuesta, Italia prohibió ChatGPT hace unos días y otros países europeos están considerando hacer lo mismo. Sin embargo, no está claro cómo afectará esta prohibición a otras aplicaciones que utilizan LLM como ChatGPT o GPT-4.

En vista de los diversos efectos posteriores, los escenarios vagos y apocalípticos que se proyectan en el futuro lejano, tal como los presenta el Future of Life Institute, no conducen a las medidas y regulaciones políticas concretas que se requieren actualmente, especialmente no en el marco de tiempo propuesto de seis meses.

Más bien, si la agenda política está impulsada por la idea de una «superinteligencia» que controla a la humanidad, existe el peligro de que se ignoren los riesgos actuales, así como las soluciones actuales. Y aunque los LLM no representan un riesgo existencial para “nuestra” civilización, sí lo hacen para una gran parte de ella, especialmente ya marginada.

Incluso si queremos sostener la idea de una “superinteligencia”, no debería ser la narrativa dominante en la que se centre ahora. Porque si presenta estos modelos como demasiado poderosos y les atribuye algún tipo de agencia, le quita la responsabilidad a las empresas que desarrollan estos sistemas.

Para que las empresas rindan cuentas, se necesita transparencia sobre cómo se desarrollaron estos LLM y con qué datos se capacitaron. Pero en cambio, OpenAI, que, contrariamente a su nombre, ahora es de código cerrado, afirma en su llamado «informe técnico» sobre GPT-4 que «este informe no contiene más detalles sobre la arquitectura (incluido el tamaño del modelo), hardware, capacitación cómputo, construcción de conjuntos de datos, método de entrenamiento, o similar”.

Este secreto dificulta las decisiones democráticas y, por lo tanto, las regulaciones sobre las condiciones en las que se deben desarrollar y desplegar los LLM. No existe tal cosa como “la buena IA”; por lo tanto, no deberíamos confiar en un grupo comparativamente pequeño y privilegiado de personas que creen que una «superinteligencia» es inevitable, lo que no es el caso, con la forma de construir una IA «segura».

En cambio, debemos comenzar involucrando a diferentes personas, especialmente a los agraviados, en la conversación para cambiar la narrativa y las relaciones de poder.

Descargo de responsabilidad: Los puntos de vista expresados por los autores no reflejan necesariamente las opiniones, los puntos de vista y las políticas editoriales de TRT World.

Damos la bienvenida a todos los lanzamientos y presentaciones a TRT World Opinion; envíelos por correo electrónico a opinion.editorial@trtworld.com