En esta foto tomada el 6 de agosto de 2020 se ve un Apolo Robotaxi en una calle de Changsha. – … [+]

AFP a través de Getty Images

Los vehículos autónomos (AV) avanzan a un ritmo rápido, a pesar de las limitaciones del Covid-19. En los últimos 2 meses se han producido importantes acontecimientos corporativos. Estos incluyen la adquisición de Zoox por parte de Amazon, las inversiones de Volkswagen en Argo, los planes de Yandex de crear su empresa conjunta de AV con Uber, y los unicornios LiDAR (LUnicornios) Velodyne y Luminar anunciando planes para salir a bolsa con valoraciones multimillonarias (¡más que Zoox!).

En el frente de despliegue, la pandemia ha proporcionado una oportunidad para que las compañías de AV con sede en China desplieguen agresivamente el servicio de transporte por carretera, mientras que la automatización de los camiones está haciendo progresos significativos en los EE.UU. (Waymo, Daimler, Ike, TuSimple, Aurora). Elon Musk ha anunciado una vez más que Tesla tendrá una funcionalidad básica para los AV de nivel 5 (no se necesitan humanos en el coche) a finales de 2020. Por si fuera poco, General Motors está reorganizando su presunto equipo de ingeniería de Corvette para apoyar los EV (vehículos eléctricos) y los AV. El enfoque es principalmente en los EVs, pero el artículo menciona planes para actualizar la plataforma AV (Origin) de GM Cruise a Corvette como niveles de manejo y confort. ¿Quién dice que las AV están destinadas a convertirse en una utilidad aburrida?

Se necesitan sistemas basados en la Inteligencia Artificial (IA) para sustituir a un conductor humano. La innovación continua y las pruebas de estos sistemas han impulsado la necesidad de datos de sensores más ricos, ya sea mediante el uso de muchos sensores por AV o capacidades de sensores más altas – rango, precisión, velocidad, visibilidad de FoV (Campo de visión), resolución y tasas de datos. Paradójicamente, el aumento de la sofisticación de los sensores plantea barreras para su despliegue: mayores costos de los sensores y los cálculos, mayor consumo de energía y problemas térmicos, preocupaciones sobre la fiabilidad y la durabilidad, mayor tiempo para la toma de decisiones (latencia), y posiblemente más confusión y errores. También aumenta las necesidades de ancho de banda de transmisión de datos, memoria y capacidades de computación (todo lo cual aumenta la potencia, el calor y los $$$s).

Se pueden seguir múltiples direcciones para adelgazar la pila de sensores y centrarse en lo que importa en un entorno de conducción (percepción de la inclinación). El resto del artículo cubre cuatro enfoques para realizarlo: diseño de sensores basado en el aprendizaje, detección basada en eventos, exploración de la región de interés (ROI) y detección semántica.

1. Optimizar el diseño de los sensores mediante el aprendizaje basado en la inteligencia artificial

El uso de complejos y sofisticados «instrumentos» de sensores y telas de computación está bien durante la fase de desarrollo, ya que la IA se desarrolla y se entrena (aprendiendo) para reemplazar al conductor humano. Un aprendizaje exitoso de la máquina debe ser capaz de identificar las características que son importantes en la fase de despliegue. El análisis del comportamiento de las neuronas en las DNN (Redes Neuronales Profundas) puede revelar los aspectos de los datos de los sensores que son importantes frente a los que son superfluos (similar a las neuronas de las DNN que procesan la información de visión 2d). Esto a su vez puede ayudar a adelgazar las especificaciones de los sensores y de los cálculos para el despliegue. Uno de los objetivos del aprendizaje de la máquina durante la fase de desarrollo de la AV debería ser especificar conjuntos de sensores que proporcionen datos procesables en el momento adecuado con el nivel óptimo de complejidad – para permitir una toma de decisiones oportuna y eficiente y decisiones de conducción.

En un artículo anterior se argumentaba que los jugadores de AV (como Waymo, Uber, Aurora, Cruise, Argo, Yandex) eligieron controlar y poseer la tecnología de sensores LiDAR para asegurar un acoplamiento más estrecho con la pila de software de IA. Este acoplamiento también puede ayudar a entender qué características de rendimiento del LiDAR son críticas para el despliegue. Trabajar con múltiples modalidades de sensores ayuda a identificar las características individuales de los sensores que son críticas en diferentes situaciones de conducción, elimina la información duplicada y redundante y reduce la complejidad innecesaria de los sensores. La postura anti-LIDAR de Tesla y el comentario de Elon Musk «El Lidar es una muleta» es un caso extremo – donde presumiblemente los datos y el aprendizaje de la máquina basado en los datos del radar y la cámara de más de 0,5M de coches desplegados en el campo ha convencido a Tesla de que el LiDAR no es necesario en los AV.

Los conductores humanos perciben una tremenda cantidad de información a través de diferentes modalidades: visual, audio, olfativa, háptica, etc. Un conductor inexperto absorbe todos estos datos, asumiendo inicialmente que todos ellos son relevantes. Con práctica y entrenamiento, los conductores expertos pueden filtrar lo irrelevante y centrarse en la información relevante, tanto en el tiempo como en el espacio. Esto les permite reaccionar rápidamente a corto plazo (frenando por un obstáculo repentino en la carretera o saliendo del tráfico con seguridad en caso de mal funcionamiento del vehículo) y a largo plazo (cambiando de carril para evitar un vehículo que se mueve más lentamente). Las máquinas que tratan de simular la inteligencia humana deberían ser capaces de seguir un modelo similar: inicialmente adquieren una gran cantidad de datos de sensores y se entrenan en ello, pero se vuelven más discriminatorias una vez que el entrenamiento alcanza un cierto nivel. El aprendizaje debería permitir a una computadora seleccionar, sentir y actuar sobre la relevante datos para asegurar una toma de decisiones oportuna y eficiente.

Llegar a un diseño óptimo de la pila de sensores delgados es una función de la IA y el aprendizaje de la máquina. Suponiendo que esto se haga, el sistema de sensores necesita decidir qué datos recoger (basado en eventos, basado en el retorno de la inversión) y cómo procesar estos datos (detección semántica).

2. Detección basada en eventos

La detección basada en eventos ha existido en el ámbito militar, en el que un sensor (por ejemplo, un radar) se puede utilizar para detectar una amenaza entrante y dar pie a otro sensor (una cámara o un LIDAR) para que preste más atención y dedique más recursos en esa región (para reconocer si se trata de un amigo o un enemigo, por ejemplo). Sin embargo, otras técnicas se basan únicamente en el propio sensor individual para identificar el evento.

Prophesee («predecir y ver dónde está la acción») es una compañía francesa que se especializa en el desarrollo de cámaras para eventos. Su objetivo es emular la visión humana o neuromórfica, donde los receptores de la retina reaccionan a la información dinámica y el cerebro se centra en el procesamiento de los cambios en la escena (especialmente para tareas dinámicas como la conducción).

La idea básica es utilizar arquitecturas de cámaras y píxeles que detecten cambios en la intensidad de la luz por encima de un umbral (un evento), y proporcionar sólo estos datos a la pila de computación para su posterior procesamiento. En relación con una cámara enmarcada de alta resolución, una cámara basada en eventos registra y transmite datos de sólo el 10-30% de los píxeles que experimentan cambios de intensidad. Las ventajas son significativas: menor ancho de banda de datos, latencia de decisión, almacenamiento y consumo de energía.

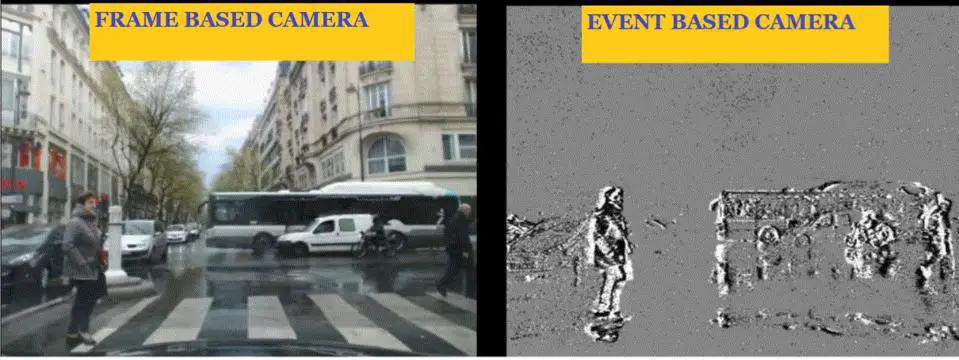

En la escena que se muestra a continuación, en la que el coche y la cámara están parados, las imágenes recogidas por una cámara HD con marco estándar proporcionan un bonito visual, pero la mayoría de los datos no son relevantes para la tarea inmediata de conducir (por ejemplo, los edificios). Un conductor humano filtra fácilmente los objetos estacionarios como edificios y árboles y se centra en los peatones y los coches en movimiento para decidir la acción de conducción. La cámara basada en eventos de Prophesee emula esto y captura las ubicaciones de los píxeles con los cambios de intensidad (eventos).

Comparación de las cámaras de fotogramas y de eventos, del coche estacionario y de la cámara

Prophesee

Cuando el coche se mueve, se activan los píxeles correspondientes a las superficies con movimiento relativo. Ciertos píxeles que corresponden a grandes áreas de uniformidad de intensidad (como el cielo o grandes superficies de un edificio estacionario) no experimentan un cambio de intensidad y no se activan.

Cámaras basadas en fotogramas y eventos, coche en movimiento y cámara

Prophesee

Un sensor basado en eventos requiere una innovación significativa en el circuito de píxeles. Los píxeles trabajan asincrónicamente y a velocidades mucho más altas ya que no tienen que integrar fotones como en una cámara convencional basada en fotogramas. Las tecnologías de interconexión para permitir esto se están trabajando en colaboración con Sony. Recientemente anunciaron un proyecto para desarrollar conjuntamente un sensor de visión basado en eventos apilados con un tamaño de píxel líder en la industria (< 5 μm) y un rango dinámico (124 dB).

Hablé con Luca Verre, CEO de Prophesee sobre los desafíos y posibilidades de las cámaras basadas en eventos, y por extensión al LIDAR basado en eventos.

SR: ¿No podría una cámara de fotograma rápido hacer lo que tú haces? diferenciar cuadros consecutivos y localizar eventos, pero al mismo tiempo tener información del nivel de intensidad en toda la escena?

LV: No. La diferenciación de fotogramas requiere recursos FPGA o SoC, mientras que las cámaras de Prophesee entregan los eventos de forma nativa. Típicamente, sólo el 10-30% de los datos recogidos por las cámaras con marco son relevantes para el control de la conducción. El uso de este tipo de cámaras crea una sobrecarga innecesaria de datos, costes y complejidad, a diferencia de nuestras cámaras basadas en eventos que identifican y transmiten sólo la información útil. Por último, para lograr una precisión temporal de submilisegundos se necesitaría una cámara basada en fotogramas que funcionara a velocidades de fotogramas de 1 Khz (difícil debido a los tiempos de exposición necesarios). Las cámaras basadas en eventos logran esto y un alto rendimiento de rango dinámico ya que los píxeles ajustan asincrónicamente el tiempo de exposición según las condiciones de iluminación de la escena.

SR: En muchas situaciones, los objetos estacionarios también son relevantes, como un peatón o un coche aparcado cerca del coche. ¿Suprimiría una cámara de eventos tal información?

LV: Las cámaras basadas en eventos detectan información dinámica. Mientras la cámara o los objetos frente a la cámara no se muevan en un sentido relativo, no hay eventos y es una situación segura. Si se produce un movimiento relativo, se traduce en un cambio de intensidad, y se registra como un evento.

SR: ¿Pueden sus cámaras trabajar en situaciones de escasez de luz?

LV: Sí, vea la figura de arriba para un coche en movimiento. Como no hay tiempo de exposición, cada píxel acumula fotones y desencadena nuevos eventos sólo cuando la intensidad de la luz cambia en una cierta cantidad (umbral de sensibilidad). Debido a esto, las cámaras basadas en eventos funcionan bien en condiciones de iluminación sublux. La contrapartida es el tiempo necesario para leer la información según lo requiera la aplicación.

SR: ¿Estás trabajando en el LIDAR basado en eventos – en términos de búsqueda de cambios en la intensidad y la profundidad de la información en un píxel?

LV: Estamos apoyando iniciativas con socios de LIDAR que están fusionando eventos e información LiDAR. Las cámaras de Prophesee identifican los eventos y el LIDAR obtiene información 3D del retorno de la inversión.

SR: ¿Las cámaras de eventos son caras de fabricar?

LV: Los sensores utilizados por nuestras cámaras se fabrican mediante procesos convencionales y se basan en interfaces de comunicación estándar. Los costes del sensor y del sistema de la cámara son comparables a los de las cámaras convencionales.

3. REscaneo de la región de interés (ROI)

Aeye (compañía de LIDAR con sede en California) promueve IDAR™ (Intelligent Detection and Ranging) – un LIDAR de 1550 nm de longitud de onda que utiliza técnicas de Tiempo de Vuelo (ToF) para extraer información de profundidad e intensidad en la escena. En la página web de Per Aeye, el IDAR™ es «el primer sistema de percepción artificial de estado sólido de vanguardia para vehículos autónomos del mundo que aprovecha la biomímesis, nunca se pierde nada, entiende que todos los objetos no son creados iguales y hace todo en tiempo real».

Aeye cree en la idea de la «saliencia» – y argumenta que el objetivo de un sistema de percepción en un AV es detectar y reaccionar a las sorpresas (si no es sorprendente, ¡es aburrido!) El IDAR™ está diseñado para ser ágil – eligiendo juiciosamente las ubicaciones en la escena a la que transmite y de la que recibe los fotones (en lugar de rociarlos uniformemente a través del FoV). Estas decisiones están guiadas por la información del propio LiDAR o de otros sensores como una cámara de alta resolución, y la inteligencia (la «I» en el IDAR™). El objetivo es inyectar fotones en una región que probablemente devuelva retornos de láser salientes (¡sorpresas!). Como en el caso de Prophesee, las regiones dinámicas de la escena son más interesantes y es probable que creen más sorpresas.

La mecánica de apuntar rápidamente el LIDAR hacia regiones de interés se consigue mediante una combinación de inteligencia y un rápido sistema de espejos microelectro-mecánicos (MEM) en 2D de alta frecuencia resonante. Las ventajas de este enfoque son el aumento del rendimiento (precisión, latencia, resolución, rango, velocidad) en el retorno de la inversión y la reducción de la complejidad, el coste y el consumo de energía del sistema. La siguiente figura muestra un ejemplo de un patrón de escaneo que puede ser creado por el LiDAR definible por software de AEye. Demuestra un control preciso de los MEM y el láser, y la capacidad de generar dinámicamente patrones de disparo de alta resolución en un ROI específico, asegurando que el LiDAR y los recursos informáticos se despliegan de forma eficiente.

Patrón de escaneo producido por el LiDAR de Aeye mostrando el retorno de la inversión.

Aeye

Allan Steinhardt es el científico jefe de Aeye. Discutimos sobre IDAR™, MEMs, y los principios impulsores de la relevancia de la información o la relevancia.

SR: ¿El IDAR™ tiene que ser vendido como un paquete de cámara y sistema LiDAR con su software?

AS: Vendemos sistemas agrupados o no agrupados, dependiendo de la preferencia del cliente. El LiDAR puede ser autoguiado o puede ser guiado por una cámara (si la velocidad de cuadro de la cámara es lo suficientemente rápida para mantener el ritmo). Muchas situaciones de tráfico se benefician de tener una cámara que se apunte con el LiDAR (por ejemplo, acercarse a los faros de un coche por la noche).

El software de nuestro sistema es como el que tienen la mayoría de los LiDARs: firmware y SW integrado para el control de los sensores. Suministramos SDK (Software Development Kit) a los clientes para experimentar con el control adaptativo de los patrones de escaneo LiDAR. También suministramos una biblioteca de patrones de escaneo que pueden ser utilizados por nuestros clientes para diferentes entornos de conducción (la figura de arriba es un ejemplo de dicho patrón de escaneo).

SR: ¿Tu sistema funcionaría mejor si el LIDAR fuera captado por una cámara de eventos?

AS: Esto depende del cliente, algunos quieren una cámara de eventos, otros no. La latencia de una cámara de eventos es menor, aunque podemos hacer que una cámara normal funcione como una cámara de eventos (por ejemplo, viendo el horizonte de la carretera y extrayendo los eventos en un software que podemos utilizar para indicar el lidar).

SR: ¿Cómo manejas las sorpresas rápidas? Necesitas determinar donde enfocar el LIDAR, posicionarlo, disparar el láser, analizar los retornos… ¿es todo esto posible en un marco de tiempo de ms?

AS: Nuestro LIDAR se adapta en tiempo real en una línea de exploración a base de líneas de exploración. Podemos determinar en 40 microsegundos si un objeto está presente o no. Basándonos en esto, actualizamos el control del sensor y modificamos el tiempo de disparo del láser para generar la resolución necesaria en el retorno de la inversión.

SR: ¿Cómo es capaz el escáner de MEM de responder tan rápido?

AS: Utilizamos un sistema de 2 MEMs de espejo, escaneando 2 ejes ortogonales. Uno de los MEM funciona en modo resonante (sin control de posición activo), el otro puede la posición de los MEM puede ser controlada activamente a través de un escaneo por pasos. Un escaneo de cuadro completo que abarca un HFoV de 120° se puede lograr en 40 microsegundos. Esto es posible basado en la capacidad de nuestro sistema para utilizar pequeños MEMs (1 mm de diámetro) de manera efectiva, una parte importante de la salsa secreta de Aeye.

SR: ¿Pero no sufren los MEM de problemas de vibración y afectan la sensibilidad del sistema debido al pequeño tamaño?

AS: Los MEM pequeños tienen ventajas significativas: altas frecuencias de resonancia (1 Khz, lo que hace que el sistema sea inmune a las vibraciones de baja frecuencia de la carretera), mayores velocidades de exploración y rangos angulares, y una alta fiabilidad de las estructuras de flexión de los MEM (en términos de fatiga). Típicamente, los MEM pequeños se traducen en una menor eficiencia óptica del sistema. Aeye evita esto a través de su diseño patentado de sistema óptico bi-estático que proporciona SNRs capaces de una visibilidad de 1 km.

4. La detección semántica…

La detección basada en eventos y el retorno de la inversión parecen ser direcciones lógicas para permitir el «adelgazamiento» de los sensores y hacerlos prácticos para el despliegue AV. Sin embargo, hay puntos de vista opuestos. Según Raúl Bravo, Presidente de Outsight (empresa francesa de software de LIDAR y detección 3D), confiar en la creación dinámica de una mayor resolución en la zona de eventos en tiempo real es problemático, porque si sabes dónde está el evento, ya deberías estar actuando, y si tienes que buscar el evento y luego interrogarlo, entonces es demasiado tarde para actuar de todos modos.

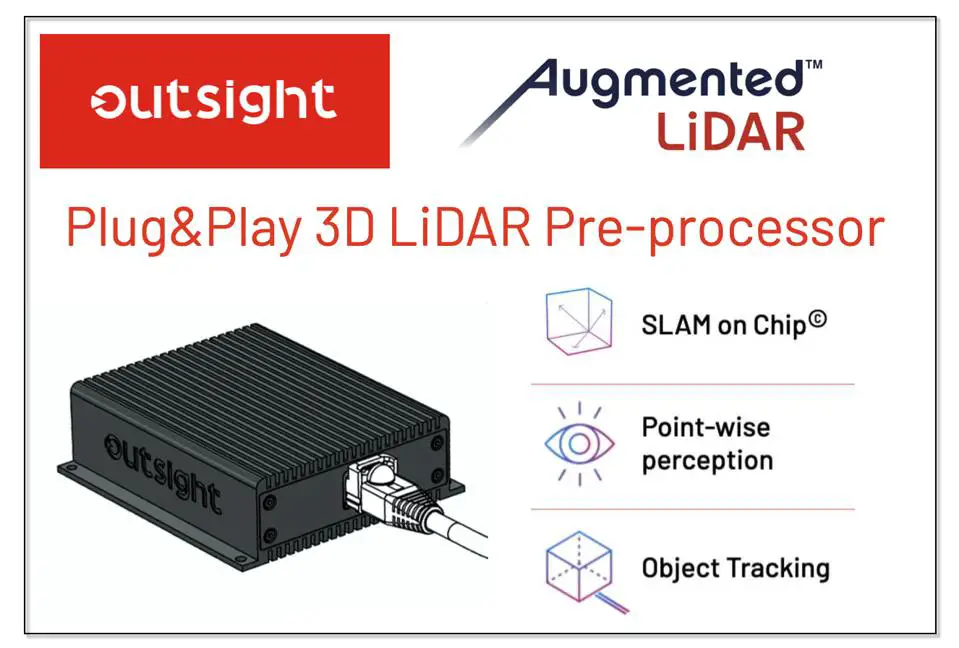

El software en tiempo real de Outsight trabaja con otros LiDARs ToF comerciales, procesando datos pasados y actuales de nubes de puntos sin procesar de forma inteligente en el borde para generar una comprensión semántica de la escena. En lugar de proporcionar datos de nubes de puntos en bruto, el software de Outsight proporciona datos de puntos clasificados.

SLAM exterior en el motor de preprocesamiento de chip LIDAR

La premisa básica del enfoque de Outsight es que, en términos simplistas, el cerebro humano aborda el riesgo/respuesta de dos maneras fundamentales. La primera exige una respuesta inmediata, es intuitiva e instintiva (Sistema 1). Esta función la realiza una porción del cerebro llamada La amígdala (o el cerebro reptil). No razona, actúa rápida e impulsivamente. El Neocórtexpor otra parte, adopta un enfoque más lógico y deliberado para comprender y decidir una acción. Necesita la mayor cantidad de datos posible (Sistema 2).

Outsight resuelve el problema del Sistema 1 (reaccionando rápidamente a las sorpresas a corto plazo en el entorno de conducción) proporcionando una amígdala artificial, y utilizándola para facilitar las funciones a largo plazo similares a las del Neocórtex. La base de la información semántica que apoya la toma de decisiones a corto plazo es un enfoque SLAM (Localización y Mapeo Simultáneos) en un chip que utiliza los datos en bruto de las nubes de puntos del pasado y del presente para crear nubes de puntos y detección de objetos relevantes y accionables. La información SLAM incluye ubicaciones relativas de objetos y velocidades en el entorno del coche.

Mis conversaciones con Raúl sobre el enfoque de Outsight se resumen a continuación.

SR: ¿Puede dar un ejemplo de cómo funciona el Sistema 1?

RB: El Sistema 1 procesa los datos en tiempo real basándose en la información pasada y actual, proporcionando sólo puntos significativos para permitir una clasificación más eficiente de los puntos y la detección de obstáculos. Deshacerse del 90% de los puntos de datos brutos del LiDAR que no son relevantes para la detección dinámica de objetos (puntos de la superficie de la carretera, la vegetación, el cielo, el entorno estático) permite alimentar la capa de identificación de objetos sólo con información relevante (por ejemplo, objetos móviles o movibles para el seguimiento de objetos o marcas en la carretera para el mantenimiento del carril). De esta manera se mejora el proceso de identificación y control (robusto, rápido y con menores requerimientos de ancho de banda).

SR: No está claro cómo interactúan los sistemas 1 y 2, ¿puede aclararlo?

RB: El Sistema 1 es determinista y funciona sin ningún tipo de aprendizaje de máquina. Funciona en paralelo con el Sistema 2 (que es el «neocórtex» o red neuronal, centrado en funciones a largo plazo como la identificación de objetos). El software de Outsight asegura la gestión del procesamiento crítico de bajo nivel (¿hay un objeto o no?), mientras que las capas de mayor abstracción del aprendizaje automático (Sistema 2) se centran en el razonamiento (¿este objeto es un perro o un gato?).

SR: ¿Funciona esto con cualquier LIDAR – ToF, FMCW, etc.?

RB: Sí, nuestro sistema funciona con cualquier salida de sensor 3D, incluyendo el LIDAR.

SR: Pero seguramente la longitud de onda de la LIDAR importa. ¿O si es un flash o un LIDAR de escaneo?

RB: Nuestro software es agnóstico en longitud de onda. Puede mejorar ciertos efectos relacionados con la longitud de onda. Por ejemplo, ciertas longitudes de onda son menos robustas a las gotas de lluvia y pueden confundirse. El software de Outsight las filtra ya que no son objetos relevantes. En términos de escaneo, el software corrige los efectos de distorsión de movimiento inherentes al escaneo de los LiDAR.

SR: ¿El software de Outsight permite un mejor rendimiento del sistema con LiDARs que tienen una menor resolución y especificaciones de rango?

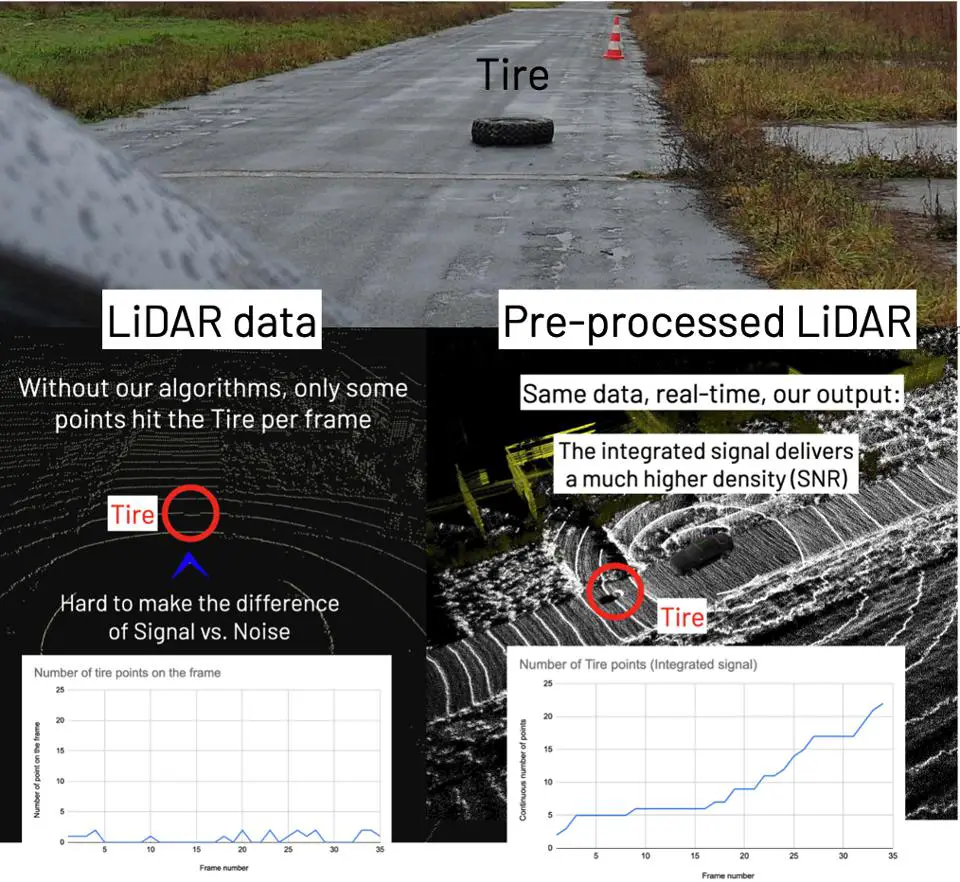

RB: Dado que el software de procesamiento integra información de eventos y datos pasados, el LIDAR de menor resolución puede aprovecharse mucho mejor que los métodos tradicionales. Por ejemplo, en la figura siguiente, el LIDAR en bruto crea muy pocos retornos a partir de un obstáculo de baja reflectividad en la carretera como un neumático (menos de 5 puntos por cuadro, a veces cero puntos). Al integrar los datos a lo largo del tiempo, este número aumenta drásticamente, proporcionando una mayor SNR (relación señal-ruido).

Mayor SNR de los retornos del LiDAR – Obstáculo de los neumáticos negros en la carretera

Predicción: A medida que los AV se acercan a la realidad, las limitaciones prácticas de despliegue (costes, tamaño, calor, durabilidad, velocidad de toma de decisiones, fiabilidad del hardware y del software) obligarán a los proveedores de sensores y de percepción a centrarse en lo que se necesita para el despliegue en el campo en lugar de lo que se puede conseguir en un laboratorio o en un entorno de desarrollo. Los requisitos y especificaciones superfluas continuarán eliminándose, lo que dará lugar a una percepción «delgada» o «magra». En muchos sentidos, este es un juego circular – un tirón de los proveedores de AV para hacer los sensores más delgados y desplegables, y un empuje de los proveedores de sensores para hacer los AV una realidad.