Internet se está convirtiendo en un huracán de tonterías generadas por IA, y nadie sabe cómo detenerlo.

Esa es la posibilidad aleccionadora presentada en un par de artículos que examinan modelos de IA entrenados con datos generados por IA. Este posible destino evitable no es noticia para los investigadores de IA. Pero estos dos nuevos hallazgos destacan algunos resultados concretos que detallan las consecuencias de un ciclo de retroalimentación que entrena un modelo en su propio resultado. Si bien la investigación no pudo replicar la escala de los modelos de IA más grandes, como ChatGPT, los resultados aún no son buenos. Y pueden extrapolarse razonablemente a modelos más grandes.

“Con el tiempo, esos errores se acumulan. Luego, en un momento dado, sus datos están básicamente dominados por los errores en lugar de los datos originales”. —Ilia Shumailov, Universidad de Cambridge

“Con el concepto de generación de datos, y la reutilización de la generación de datos para volver a entrenar, ajustar o perfeccionar los modelos de aprendizaje automático, ahora está entrando en un juego muy peligroso”, dice Jennifer Prendki, directora ejecutiva y fundadora de la empresa Alectio de DataPrepOps.

La IA se precipita hacia el colapso

Los dos documentos, ambos preprints, abordan el problema desde ángulos ligeramente diferentes. «The Curse of Recursion: Training on Generated Data Makes Models Forget» examina el efecto potencial en modelos de lenguaje extenso (LLM), como ChatGPT y Google Bard, así como modelos de mezcla gaussiana (GMM) y codificadores automáticos variacionales (VAE). El segundo documento, «Hacia la comprensión de la interacción de la inteligencia artificial generativa e Internet», examina el efecto en los modelos de difusión, como los que utilizan los generadores de imágenes como Stable Diffusion y Dall-E.

Si bien los modelos discutidos difieren, los documentos alcanzan resultados similares. Ambos encontraron que entrenar un modelo con datos generados por el modelo puede conducir a una falla conocida como colapso del modelo.

“Esto se debe a que cuando el primer modelo ajusta los datos, tiene sus propios errores. Y luego, el segundo modelo, que se entrena con los datos producidos por el primer modelo que tiene errores internos, básicamente aprende los errores establecidos y agrega sus propios errores encima”, dice Ilia Shumailov, Ph.D. en ciencias de la computación de la Universidad de Cambridge. . candidato y coautor del artículo «Recursión». “Con el tiempo, esos errores se acumulan. Luego, en un momento dado, sus datos están básicamente dominados por los errores en lugar de los datos originales”.

La calidad de los resultados generados por los LLM disminuye con cada generación de capacitación sobre datos generados por IA.La maldición de la recursividad: el entrenamiento con datos generados hace que los modelos se olviden

Y los errores se acumulan rápidamente. Shumailov y sus coautores utilizaron OPT-125M, un LLM de código abierto presentado por investigadores de Meta en 2022, y ajustaron el modelo con el conjunto de datos wikitext2. Si bien las primeras generaciones produjeron resultados decentes, las respuestas se volvieron absurdas dentro de diez generaciones. Una respuesta de la novena generación repitió la frase «liebres de cola» y alternó varios colores, ninguno de los cuales se relaciona con el mensaje inicial sobre la arquitectura de las torres de Somerset, en Inglaterra.

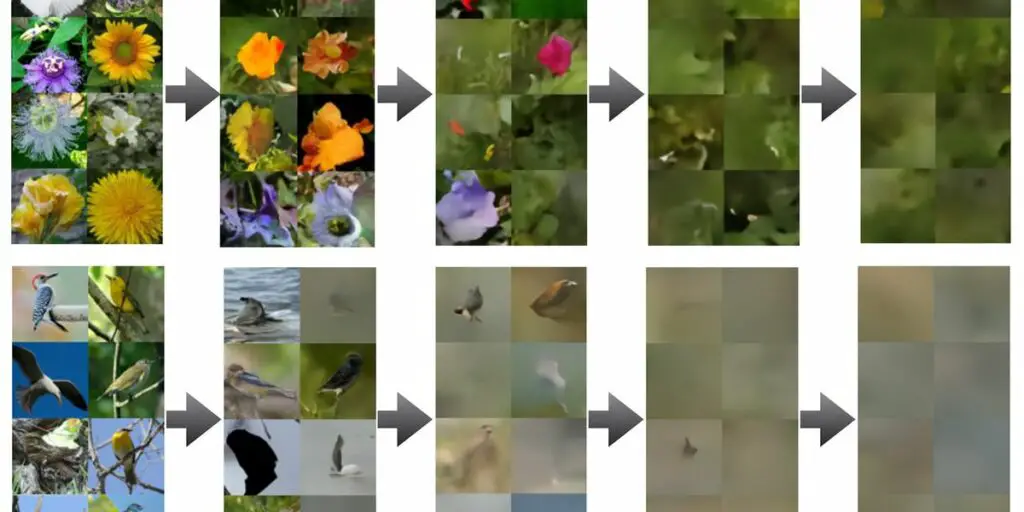

Los modelos de difusión son igualmente susceptibles. Rik Sarkar, coautor de «Towards Understanding» y subdirector del Laboratorio de Fundamentos de Ciencias de la Computación de la Universidad de Edimburgo, dice: «Parece que tan pronto como se tiene un volumen razonable de datos artificiales, se degenera». El documento encontró que un modelo de difusión simple entrenado en una categoría específica de imágenes, como fotos de pájaros y flores, produjo resultados inutilizables dentro de dos generaciones.

Sarkar advierte que los resultados son el peor de los casos: el conjunto de datos era limitado y los resultados de cada generación se retroalimentaron directamente al modelo. Aún así, los resultados del documento muestran que el colapso del modelo puede ocurrir si el conjunto de datos de entrenamiento de un modelo incluye demasiados datos generados por IA.

Los datos de entrenamiento de IA representan una nueva frontera para la ciberseguridad

Esto no sorprende a quienes estudian de cerca la interacción entre los modelos de IA y los datos utilizados para entrenarlos. Prendki es un experto en el campo de las operaciones de aprendizaje automático (MLOps), pero también tiene un doctorado en física de partículas y ve el problema a través de una lente más fundamental.

“Es básicamente el concepto de entropía, ¿verdad? Los datos tienen entropía. Cuanta más entropía, más información, ¿verdad? dice Prendki. “Pero tener un conjunto de datos dos veces más grande no garantiza en absoluto una entropía dos veces más grande. Es como poner un poco de azúcar en una taza de té y luego agregar más agua. No estás aumentando la cantidad de azúcar”.

“Esta es la próxima generación de problemas de ciberseguridad del que muy pocas personas hablan”. —Jennifer Prendki, directora ejecutiva de Alectio.com

El colapso del modelo, visto desde esta perspectiva, parece un problema obvio con una solución obvia. Simplemente cierra el grifo y echa otra cucharada de azúcar. Eso, sin embargo, es más fácil decirlo que hacerlo. Pedro Reviriego, coautor de «Hacia la comprensión», dice que si bien existen métodos para eliminar los datos generados por IA, el lanzamiento diario de nuevos modelos de IA rápidamente los vuelve obsoletos. «Es como [cyber]seguridad”, dice Reviriego. “Tienes que seguir corriendo detrás de algo que se mueve rápido”.

Prendki está de acuerdo con Reviriego y lleva el argumento un paso más allá. Ella dice que las organizaciones y los investigadores que entrenan un modelo de IA deberían ver los datos de entrenamiento como un adversario potencial que debe ser investigado para evitar degradar el modelo. “Esta es la próxima generación de problemas de ciberseguridad del que muy pocas personas hablan”, dice Prendki.

Hay una solución que podría resolver completamente el problema: la marca de agua. Las imágenes generadas por DALL-E de OpenAI incluyen un patrón específico de colores por defecto, como una marca de agua (aunque los usuarios tienen la opción de eliminarlo). Los LLM también pueden contener marcas de agua en forma de patrones detectables algorítmicamente que no son obvios para los humanos. Una marca de agua proporciona una manera fácil de detectar y excluir datos generados por IA.

Sin embargo, la marca de agua efectiva requiere cierto acuerdo sobre cómo se implementa y un medio de aplicación para evitar que los malos actores distribuyan datos generados por IA sin una marca de agua. China ha presentado un borrador de medida que aplicaría una marca de agua en el contenido de IA (entre otras regulaciones), pero es una plantilla poco probable para las democracias occidentales.

Las imágenes creadas con DALL-E de OpenAI tienen una marca de agua en la esquina inferior derecha, aunque los usuarios pueden optar por eliminarla.IA abierta

Las imágenes creadas con DALL-E de OpenAI tienen una marca de agua en la esquina inferior derecha, aunque los usuarios pueden optar por eliminarla.IA abierta

Quedan algunos destellos de esperanza. Los modelos presentados en ambos documentos son pequeños en comparación con los modelos más grandes que se usan en la actualidad, como Stable Diffusion y GPT-4, y es posible que los modelos grandes resulten más robustos. También es posible que los nuevos métodos de curación de datos mejoren la calidad de futuros conjuntos de datos. Sin embargo, en ausencia de tales soluciones, Shumailov dice que los modelos de IA podrían enfrentar una «ventaja de ser los primeros», ya que los primeros modelos tendrán un mejor acceso a los conjuntos de datos no contaminados por los datos generados por IA.

“Una vez que tengamos la capacidad de generar datos sintéticos con algún error dentro, y tengamos un uso a gran escala de tales modelos, inevitablemente los datos producidos por estos modelos terminarán siendo utilizados en línea”, dice Shumailov. “Si quiero construir una empresa que proporcione un gran modelo lingüístico como servicio a alguien [today]. Si luego voy y raspo un año de datos en línea e intento construir un modelo, entonces mi modelo colapsará dentro de él”.

De los artículos de su sitio

Artículos relacionados en la Web