Noticias ACM

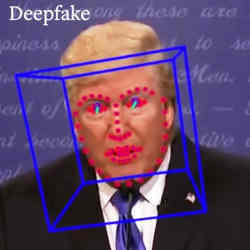

La inteligencia artificial, que puede generar imágenes y videos falsos asombrosamente realistas, se utiliza cada vez más para detectarlos.

Crédito: Berkeley Video

Distinguir entre hechos y falsedades se ha convertido en una parte cotidiana de nuestras vidas en línea. Durante la campaña electoral de Estados Unidos, un video manipulado que parecía mostrar que Joe Biden olvidó en qué estado se encontraba se volvió viral y recibió más de un millón de visitas antes de que fuera desacreditado.

La manipulación del material visual para hacer travesuras políticas no es nada nuevo. Josef Stalin borró notoriamente a los compañeros indeseables de las fotografías durante la Gran Purga en la Rusia de los años 30. Hoy en día, los métodos digitales significan que todo el mundo puede fingir.

La inteligencia artificial (IA) puede generar imágenes y videos falsos asombrosamente realistas. Estos llamados deepfakes, un nombre que combina «aprendizaje profundo» con «falso», son las estrellas en ascenso del mundo posterior a los hechos.

Cualquier persona puede hacer deepfakes de forma rápida y económica: aficionados, bromistas, estafadores, grupos políticos, extremistas. Muchos son memes inofensivos y parodias cómicas, pero otros están dignos de confundir y desestabilizar. Se utilizan como engaños, estafas, propaganda política y campañas de desinformación o desinformación.

Los deepfakes se crean comúnmente utilizando redes generativas de confrontación (GAN). Dos redes neuronales (un generador y un discriminador) están configuradas para trabajar entre sí; el generador produce imágenes aleatorias y el determinador las clasifica como reales o falsas. Se produce un ciclo de aprendizaje y revisión hasta que el determinante es engañado para que identifique las falsificaciones como reales.

La IA no solo puede generar deepfakes, sino que se utiliza cada vez más para detectarlos.

Investigadores de Intel Corporation y el laboratorio de Computación de Gráficos e Imágenes (GAIC) de la Universidad de Binghamton produjeron una herramienta llamada FakeCatcher que identifica y clasifica videos de retratos falsos a través de señales biológicas. El equipo informó una precisión del 99,39% para la separación por pares, pares de videos en los que uno es real y el otro es falso, y una precisión del 96% para la detección de deepfake.

El grupo GAIC ha estado estudiando las expresiones faciales y las emociones utilizando imágenes y videos tridimensionales (3D), junto con datos biológicos, como la frecuencia cardíaca, la presión arterial y otros signos vitales.

«Cuando las personas experimentan diferentes emociones, experimentan diferentes señales fisiológicas, esas señales se capturan en nuestro laboratorio «, dijo el director de GAIC, Lijun Yin..

Los conjuntos de datos resultantes se están aplicando a la investigación en campos tan variados como la visión por computadora, la seguridad, la biomedicina y la psicología.

Ilke Demir, científico investigador senior de Intel, se dio cuenta del potencial del recurso para la detección de deepfake y colaboró con uno de los Ph.D. de Yin. estudiantes, Umur A. Ciftci, como experto en señales PPG. Como explicó Yin, «la gente puede sintetizar un video facial, una expresión facial animada, pero es muy difícil sintetizar sus señales fisiológicas».

Cuando las emociones desencadenan cambios sutiles en el flujo sanguíneo y la frecuencia cardíaca, se manifiestan en videos de retratos como cambios de color en píxeles. Estos son difíciles de reproducir con precisión en un deepfake.

Los cambios son invisibles para el ojo humano, pero pueden detectarse mediante señales de fotopletismografía (PPG). Bajo la supervisión de Yin, Ciftci y Demir desarrollaron un algoritmo que identifica señales PPG y las convierte en un mapa PPG que luego se puede utilizar para detectar deepfakes automáticamente.

En un video de retrato real, tales señales deben ser coherentes espacialmente, dijo Yin. «Si se trata de una persona real, un video real, entonces la señal PPG sería consistente desde cada parte de su rostro, en la frente, en la barbilla, en la nariz». También deben ser consistentes temporalmente: en el tiempo, en un fotograma de video. Como explicó Yin, «la frecuencia cardíaca de una persona no puede cambiar drásticamente en un período de tiempo tan corto».

La técnica funciona porque los productores de deepfake no han considerado estos obsequios ocultos en su trabajo. «Nunca mantienen la consistencia en la dimensión espacial y temporal de la señal PPG», dijo Yin. Sin embargo, agregó, la llegada de este nuevo método de detección podría cambiar todo eso.

En Alemania, un equipo del Instituto Horst Görtz de Seguridad de TI de Ruhr-Universität Bochum ha desarrollado una técnica para detectar deepfakes mediante análisis de frecuencia. El trabajo fue presentado en la Conferencia Internacional sobre Aprendizaje Automático (ICML) en julio.

El equipo basó su enfoque en una transformación matemática existente llamada transformada de coseno discreta (DCT), que se usa comúnmente en el procesamiento de señales. DCT «toma datos de imágenes y los transforma en lo que se llama espacio de frecuencia», explicó el asistente de investigación Joel Frank.

Cuando se comprime un archivo de imagen, el análisis DCT elimina información que no es relevante o visible para el ojo humano. Los datos de imagen prominentes tienden a encontrarse en áreas de baja frecuencia, que los algoritmos de compresión intentan preservar. Como explicó Frank, «podemos eliminar las altas frecuencias sin perder mucho del contenido de la imagen».

Esto se hace a menudo para ahorrar ancho de banda o espacio al transmitir imágenes. «WhatsApp eliminaría la información de alta frecuencia de una imagen porque realmente no puedes verla como un ser humano; simplemente está ahí», dijo Frank.

Los investigadores escribieron un programa que automatiza el análisis DCT en imágenes obtenidas de Which Face is Real? sitio web y un conjunto de datos de imágenes de dormitorios recopiladas específicamente para el proyecto. El equipo demostró que, a diferencia de sus contrapartes reales, los deepfakes generados por GAN muestran rastros de información en áreas de alta frecuencia.

Estos rastros, o artefactos, ahora se pueden identificar fácilmente y usar para marcar una imagen como falsa. «En la alta frecuencia, es muy prominente porque las imágenes reales no tienen mucha información allí y [deepfakes] en realidad tengo bastante «, dijo Frank.

El código está disponible gratuitamente en GitHub para que lo utilicen investigadores y programadores. El equipo ahora tiene como objetivo construir una interfaz que permita a cualquier usuario cargar una imagen para su análisis.

Estas nuevas técnicas de detección de Binghamton y Bochum aprovechan las sutiles cualidades de los datos de imágenes que los creadores de deepfakes no han tenido en cuenta hasta ahora. Es posible que reaccionen y se adapten. El uso de IA para generar y detectar deepfakes es un juego de gato y ratón en rápido movimiento, sin un final obvio a la vista.

Karen Emslie es periodista y ensayista independiente independiente de la ubicación.

entradas no encontradas