La capacidad de razonar de forma abstracta sobre los acontecimientos a medida que se desarrollan es una característica definitoria de la inteligencia humana. Sabemos instintivamente que el llanto y la escritura son medios de comunicación, y que un panda que cae de un árbol y un avión que aterriza son variaciones en el descenso.

Organizar el mundo en categorías abstractas no es fácil para las computadoras, pero en los últimos años los investigadores se han acercado más entrenando modelos de aprendizaje de máquinas sobre palabras e imágenes infundidas con información estructural sobre el mundo, y sobre cómo se relacionan los objetos, los animales y las acciones. En un nuevo estudio realizado en la Conferencia Europea sobre Visión por Computadora este mes, los investigadores revelaron un modelo híbrido de visión de lenguaje que puede comparar y contrastar un conjunto de eventos dinámicos capturados en video para desentrañar los conceptos de alto nivel que los conectan.

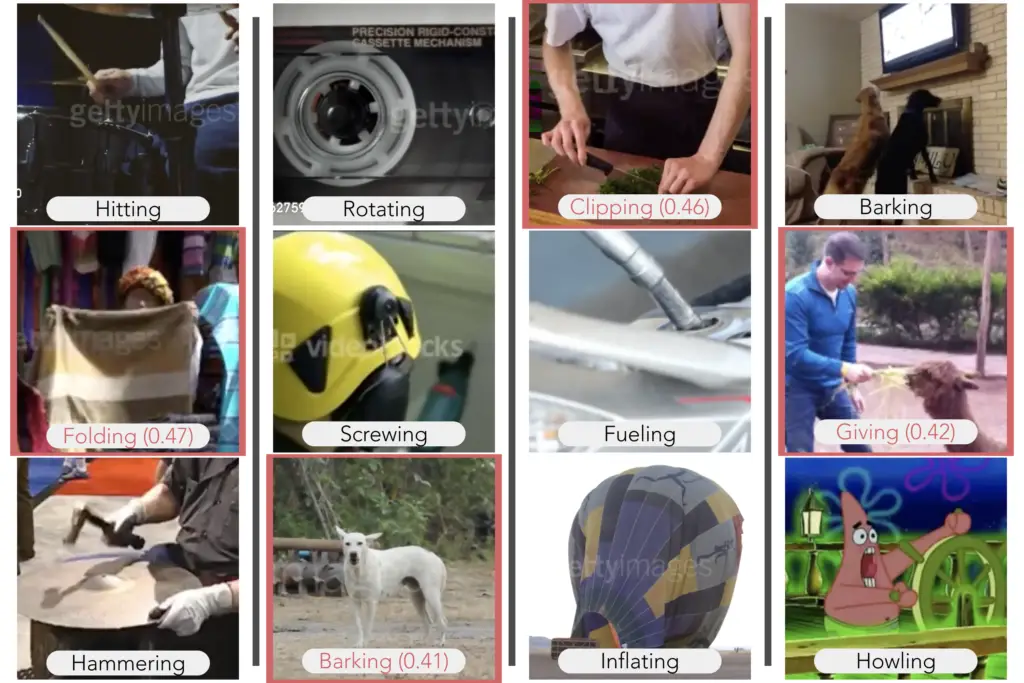

Su modelo lo hizo tan bien o mejor que los humanos en dos tipos de tareas de razonamiento visual: elegir el vídeo que conceptualmente mejor completa el conjunto, y elegir el vídeo que no encaja. Mostrando videos de un perro ladrando y un hombre aullando al lado de su perro, por ejemplo, la modelo completó el conjunto escogiendo el bebé que lloraba de un conjunto de cinco videos. Los investigadores replicaron sus resultados en dos conjuntos de datos para el entrenamiento de sistemas de inteligencia artificial en reconocimiento de acción: Multi-Momentos en el tiempo del MIT y la cinética de DeepMind.

«Demostramos que se puede construir la abstracción en un sistema de IA para realizar tareas ordinarias de razonamiento visual cerca de un nivel humano», dice la autora principal del estudio Aude Oliva, científica investigadora principal del MIT, codirectora del MIT Quest for Intelligence, y directora del MIT-IBM Watson AI Lab. «Un modelo que puede reconocer eventos abstractos dará predicciones más precisas y lógicas y será más útil para la toma de decisiones».

A medida que las redes neuronales profundas se vuelven expertas en reconocer objetos y acciones en fotos y video, los investigadores han puesto sus ojos en el siguiente hito: la abstracción y el entrenamiento de modelos para razonar sobre lo que ven. En un enfoque, los investigadores han fusionado el poder de coincidencia de patrones de las redes profundas con la lógica de los programas simbólicos para enseñar a un modelo a interpretar las complejas relaciones de los objetos en una escena. Aquí, en otro enfoque, los investigadores capitalizan las relaciones incrustadas en los significados de las palabras para dar a su modelo un poder de razonamiento visual.

«Las representaciones lingüísticas nos permiten integrar la información contextual aprendida de las bases de datos de texto en nuestros modelos visuales», dice el coautor del estudio Mathew Monfort, un científico investigador del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT. «Palabras como ‘correr’, ‘levantar’ y ‘boxear’ comparten algunas características comunes que las hacen más relacionadas con el concepto de ‘ejercicio’, por ejemplo, que con el de ‘conducir’. ”

Usando WordNet, una base de datos de significados de palabras, los investigadores mapearon la relación de cada etiqueta de clase de acción en Momentos y Cinética con las otras etiquetas en ambos conjuntos de datos. Palabras como «esculpir», «tallar» y «cortar», por ejemplo, estaban conectadas a conceptos de nivel superior como «artesanía», «hacer arte» y «cocinar». Cuando el modelo reconoce una actividad como la escultura, puede elegir actividades conceptualmente similares en el conjunto de datos.

Este gráfico relacional de clases abstractas se utiliza para entrenar al modelo a realizar dos tareas básicas. Dada una serie de videos, el modelo crea una representación numérica para cada video que se alinea con las representaciones de las palabras de las acciones mostradas en el video. A continuación, un módulo de abstracción combina las representaciones generadas para cada vídeo del conjunto para crear una nueva representación del conjunto que se utiliza para identificar la abstracción compartida por todos los vídeos del conjunto.

Para ver cómo funcionaría el modelo en comparación con los humanos, los investigadores pidieron a los sujetos humanos que realizaran el mismo conjunto de tareas de razonamiento visual en línea. Para su sorpresa, el modelo funcionó tan bien como los humanos en muchos escenarios, a veces con resultados inesperados. En una variación de la tarea de finalización del conjunto, después de ver un vídeo de alguien envolviendo un regalo y cubriendo un artículo en cinta, el modelo sugirió un vídeo de alguien en la playa enterrando a otro en la arena.

«Es efectivamente ‘cubriente’, pero muy diferente de las características visuales de los otros clips», dice Camilo Fosco, un estudiante de doctorado en el MIT que es co-autor del estudio con el estudiante de doctorado Alex Andonian. «Conceptualmente encaja, pero tuve que pensar en ello».

Las limitaciones del modelo incluyen una tendencia a sobredimensionar algunas características. En un caso, sugirió completar un conjunto de vídeos deportivos con un vídeo de un bebé y un balón, aparentemente asociando los balones con el ejercicio y la competición.

Un modelo de aprendizaje profundo que puede ser entrenado para «pensar» más abstractamente puede ser capaz de aprender con menos datos, dicen los investigadores. La abstracción también allana el camino hacia un razonamiento de mayor nivel, más humano.

«Un sello distintivo de la cognición humana es nuestra capacidad para describir algo en relación con otra cosa – para comparar y contrastar», dice Oliva. «Es una forma rica y eficiente de aprender que podría eventualmente llevar a modelos de aprendizaje automático que pueden entender analogías y están mucho más cerca de comunicarse inteligentemente con nosotros.»

Otros autores del estudio son Allen Lee del MIT, Rogerio Feris de IBM y Carl Vondrick de la Universidad de Columbia.