El tema obligatorio sigue siendo ChatGPT. Pasaron algunos meses desde su irrupción en noviembre del año pasado, pero la Inteligencia Artificial ganó las charlas en aulas, oficinas, sobremesas. Lo cierto es que la IA existe desde hace décadas; por lo menos desde los años 50. Pero no fue sino hasta que apareció la inteligencia “generativa” (la G de ChatGPT) que se masificó y ganó esta relevancia.

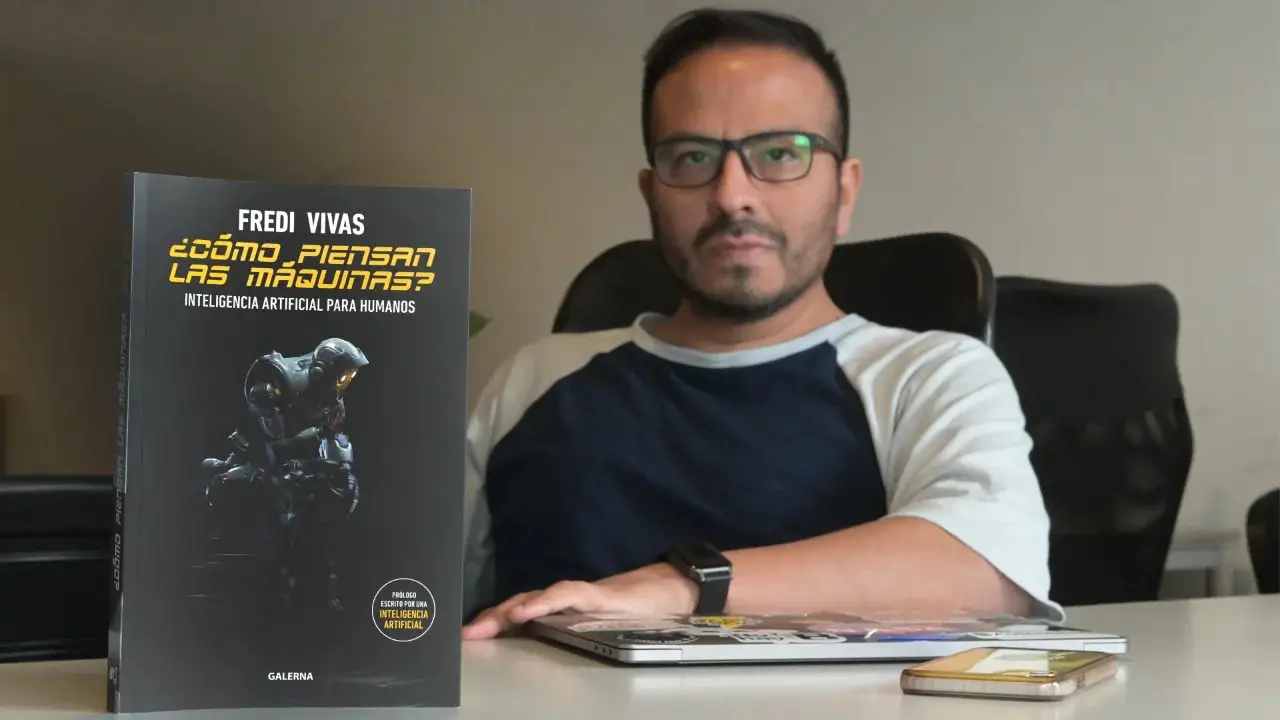

Uno de los referentes en el tema es Fredi Vivas, autor de ¿Cómo piensan las máquinas?, que ya desde su portada, en la que un robot asume la pose del pensador de Rodin, propone una lectura polémica, pero no incómoda. ¿Cuáles son los límites de la IA? ¿Cuáles son sus riesgos? ¿Cuál es la mejor manera de aprovecharla? ¿Cómo desarrollar IA de manera responsable? Algunas de las preguntas que Vivas se hicieron al publicarlo y que hoy vuelven con más urgencia que nunca. El libro se publicó por la editorial Galerna; la misma por donde sale El imperio de los algoritmosde Cecilia Danesi.

En el marco del ciclo que coorganizaron Ticmas y la Universidad de San Andrés, Fredi Vivas visitó el auditorio de Ticmas y habló del fantasma en la maquina.

—¿Sin la salida de ChatGPT, sin ese proyecto que estaba vinculado a Microsoft ya Elon Musk, la inteligencia artificial todavía sería un tema de ciencia ficción?

—Puede ser. La verdad, la inteligencia artificial como un subcampo de las Ciencias de la Computación, se viene aplicando hace mucho en un montón de entornos. Hace unos quince o veinte años ya, que se ha implementado en empresas. Pero la realidad es que el ChatGPT consiguió un millón de usuarios en cinco días. Eso es un indicador que te demuestra el interés y la democratización que proponía OpenIA, que es la empresa que creó una ChatGPT encabezada, en ese momento, Por Elon Musk y Microsoft. Después Elon se va y viene toda una conversación.

—OpenAI da idea de ser un proyecto abierto.

—Es que ellos querrían democratizar el acceso. Después se volvió no tan abierta: cuando te empiezan a cobrar por un servicio, vemos que están corriendo un poco el propósito como empresa. Pero podemos asegurar que el hecho de que cualquier persona pueda entrar gratis a usar una herramienta con inteligencia artificial eso es novedoso. Nunca pasó que cualquier persona pudiera acceder a una herramienta e interactuar con la inteligencia artificial. En mi caso, que hace 12 años más o menos trabajo en esto, lo vimos desarrollar, pero no es lo mismo. Acá estamos hablando de plataformas con capacidades tremendamente poderosas puestas en la mano de millones de personas.

—Lo fascinante de la inteligencia artificial es que los programadores no tienen el control completo de lo que elaboran, y que la carrera de Ingeniería en Prompt —la orden que se le da a la IA— es tal vez más importante que la de la programación.

—Yo ahí tengo una polémica. El prompteo es una orden que se le da a la inteligencia artificial. Por ejemplo, una imagen podemos pedirle que crea un oso panda bailando en Marte. Ahora, imagine lo que puede pasar en los próximos años, cuando ese prompteo ya no sea escrito. ¿Años? Meses, semanas: ya no sé. Imaginate que eso pase a estar integrado a la voz y que vos, en vez de tener que escribir, le hables a Alexa, Siri, Ok Google, cualquiera de esas y, le digas “Dame un texto estilo Borges sobre tal cosa”. Entonces, ¿dónde va a quedar la ingeniería de prompteo? Se va a convertir en otra cosa. Una de las cosas en que me la jugué en mi libro es que la inteligencia artificial se va a diluir conceptualmente, y se va a meter en todas las demás. Entonces el concepto de inteligencia artificial va a cambiar. Yo me imagino que ChatGPT desaparece y queda embebido en otras cosas. Por ejemplo, quede asociado dentro de tu correo. El prompteo podría ir desapareciendo.

—¿La inteligencia artificial dónde se desarrolla? ¿cuantas inteligencias hay?

—Está buena la pregunta. Para los que tienen iniciativas de aprender a desarrollar inteligencia artificial: la podés hacer en tu casa con un lenguaje de programación que se llama Python. De forma gratuita. No necesitas nada. Lo caro y lo complejo es el entrenamiento con los datos. Qué tiene ventaja ChatGPT por sobre todas las otras cosas: que tiene un entrenamiento con muchos datos. Accedió a toda la Wikipedia, a 17 billones de páginas web, a todos los blogs de programación del mundo. Es como si hubiera puesto a leer todo lo que existe en la humanidad y está digitalizado…

—Es un gran servidor, un mega cerebro.

—… pero quién paga la tecnología para el entrenamiento de los datos. Esa es la pregunta. Cuando empezamos a hablar del modelo GPT con mi equipo de investigación, ellos decían que nosotros lo pudimos haber hecho, pero cuánto nos había salido. Todos podemos desarrollar una inteligencia artificial. De hecho, conozco gente en Argentina que está surgiendo unas al estilo ChatGPT y funcionan bien. El problema es el costo del entrenamiento. Eso se procesa en la nube —ahí va tu pregunta sobre dónde está todo eso—. Por eso la alianza con Microsoft, que tiene una nube propia, que es Azure, y eso te explica cómo funciona técnicamente.

—Está Microsoft, pero si de algún lado debería haber salido ChatGPT, tiene que haber sido de Google. ¿No?

—En el 2017, Google inventa la tecnología Transformer, que es el tipo de red neuronal artificial que estamos viendo hoy. Google tiene datos digitales desde el 98 en adelante. Por lo tanto, cuando muchos dicen que no hay chance de que ningún alcance OpenAI, pienso que Google tiene datos desde aquella época y tiene toda esta capacidad técnica. Sin duda, Bard va a ser un gran competidor. Y Bard está basado en el modelo LaMDA, que, no sé si te acordás, fue aquello con lo que un ingeniero dijo que tiene vida propia.

—Vayamos a esa vida propia. Con las declaraciones de Yuval Harari y el manifiesto de los científicos para no seguir explorando la inteligencia artificial, ¿qué tan peligrosa es la inteligencia artificial?

—Cualquier inteligencia no humana levanta sospechas; Quizás nosotros sabemos que la inteligencia es solo patrimonio humano. Hay que ser cautos y decir que la inteligencia artificial no es una inteligencia que pueda sentir emociones, ni que pueda tener algo parecido a una conciencia —aunque no sepamos bien qué es la conciencia—. A veces uno usa conceptos como “aprendizaje” o “pensar” que son conceptos de la humanidad. Uno lo utiliza para simplificar, pero las máquinas no piensan ni aprenden. Hacen algo similar, entienden el entorno para simular un tipo de inteligencia, pero eso es justamente: una simulación. Antes nos parecía imposible. Esa carta a mí me yo la leí y estuve bastante atento al tema tiene dos lecturas una lectura es lo que vos dijiste y lol más como competidor está lanzando una competencia entonces él pretendía frizar los desarrollos. La carta de Elon Musk pretendía frizar los modelos de lenguaje gigantes —donde adentro está GPT— porque todavía no entendemos el impacto que va a tener en la sociedad, en los trabajos, en la legislación. Recordarás el caso de Cambridge Analytica: cuando debaten con Mark Zuckerberg se notaba que no entendieron lo que estaban preguntando.

—Exactamente lo mismo que pasó con TikTok.

—Y va a seguir pasando. Por eso debería ser obligatorio un entrenamiento. No solo para los legisladores, sino para toda la sociedad en general. Estamos frente a una herramienta que puede ser usada para bien como para mal. Creo que, como cualquier disrupción, y estamos en el medio de una revolución industrial, además de una revolución de la economía y el conocimiento, creo que requiere de un involucramiento. No solo de los tecnólogos, sino de otros tipos de actores también.

—Volviendo a Cambridge Analytica y Mark Zuckerberg, recuerdo a los senadores de Estados Unidos hablándole a Zuckerberg, y todos caían en el mismo estereotipo “Necesitamos un conjunto de nerds que vengan a explicarnos”, decían. La idea de que un senador hable de un nerd en lugar de un técnico o un especialista también es grave.

—Sí, y de hecho mi empresa, RockingData, tiene perfiles diferentes: desde filósofos, que desarrolla este tipo de iniciativas pensando cómo impactar o disminuir los sesgos de la inteligencia artificial, pero también necesitamos gente que sepa de las leyes, de política, de psicología. Hoy vemos aplicaciones en todo tipo de industria: cómo hacemos para que todas esas herramientas sean bien canalizadas. Ese es uno de los grandes desafíos que se está planteando.

—¿Qué es la compañía X de Elon Musk?

—Vi los videos de Elon Musk, donde habló de frenar la inteligencia artificial y, en realidad, también dice que la IA tiene un montón de usos buenos y que, de hecho, la usa en Tesla. Entonces, está claro que no podía frenar la inteligencia artificial porque tiene empresa que hace autos que se manejan con inteligencia artificial. Con esta empresa, él estaba buscando crear desarrollos éticos y hechos responsables. No hay mucha materia escrita sobre el tema. Lo único que hay es un tratado, un marco de trabajo, que hizo la UNESCO hace un año. Es un estudio que hicieron en 150 países durante dos años viendo eran las buenas prácticas de implementación de inteligencia artificial. Antes de eso, vos creabas un proyecto de inteligencia artificial y tenías que imaginarte eran las cuestiones para prestar atención. Si, por ejemplo, hacías una app que usa inteligencia artificial para transferir dinero y operar con la voz, ¿me va a entender si soy disléxico o si soy un anciano? Son debates nuevos y es importante tenerlos.

—¿No puede darse cuenta de que la inteligencia artificial resuelva tantas tareas que se burocratice y, al final, sólo sean robots hablando entre sí?

—Uno tiende a pensar en un robot como un ser físico. Tipo Terminator. La realidad es que el mundo está lleno de robots. Cuando comprás algo en la calle y transferís dinero a otra cuenta. Hay un robot haciendo eso. Un robot te recomienda películas en la plataforma de contenido; un robot te ayuda a llegar a tu casa con Waze. Son robots digitalizados, robots de inteligencia artificial. Hace poco hablo con Diego Pereyra…

—Autor de La salud del futuro.

-Si. Con él siempre aprendo. Te dice que, si hay un accidente, se tardan 22 minutos en cargar los datos en el sistema. Y yo pienso que cuando pediste tardas dos minutos. Y tenés la trazabilidad en tiempo real de la comida, pero si pedís una ambulancia, no. Con Diego hicimos hace un par de años un proyecto muy interesante para predecir casos de COVID en la clínica Güemes —y podría ser dengue o cualquier otra patología—. Es un súper caso concreto, que, por más que sea o no perfecta, es mucho mejor que no tener ni idea de lo que puede pasar. Ahí estamos hablando de casos súper concretos de la inteligencia artificial aplicada.

—¿Por qué nos fascina tanto saber cómo piensan las máquinas?

—Yo creo que nos dispara la curiosidad. Hay una frase muy interesante, que dice: “Cualquier tecnología suficientemente avanzada es indistinguible de la magia”. Si trajéramos a alguien de hace cien años y lo sentáramos a chatear con ChatGPT, no lo podría creer. No podría creer que hay una máquina procesando todo eso. Por eso es importante aprender: cuando conocés algo te ayuda a perder el miedo.

LEER MÁS