Si su conductor de Uber toma un atajo, es posible que llegue a su destino más rápido. Pero si un modelo de aprendizaje automático toma un atajo, puede fallar de formas inesperadas.

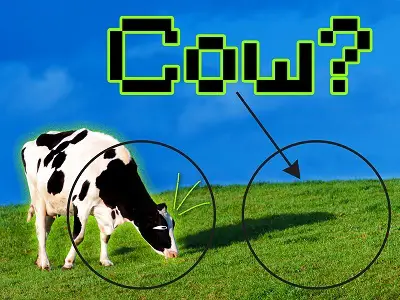

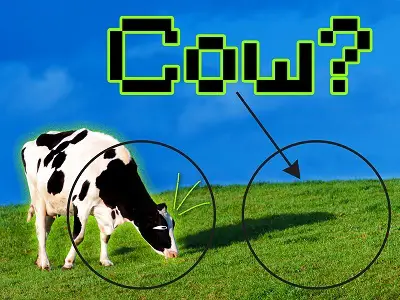

En el aprendizaje automático, se produce una solución de atajo cuando el modelo se basa en una característica simple de un conjunto de datos para tomar una decisión, en lugar de aprender la verdadera esencia de los datos, lo que puede generar predicciones inexactas. Por ejemplo, un modelo puede aprender a identificar imágenes de vacas centrándose en la hierba verde que aparece en las fotos, en lugar de en las formas y patrones más complejos de las vacas.

Un nuevo estudio realizado por investigadores del MIT explora el problema de los atajos en un método popular de aprendizaje automático y propone una solución que puede evitar los atajos al obligar al modelo a utilizar más datos en su toma de decisiones.

Al eliminar las características más simples en las que se enfoca el modelo, los investigadores lo obligan a enfocarse en características más complejas de los datos que no había estado considerando. Luego, al pedirle al modelo que resuelva la misma tarea de dos maneras, una vez usando esas características más simples y luego también usando las características complejas que ahora ha aprendido a identificar, reducen la tendencia a las soluciones de atajos y aumentan el rendimiento del modelo.

Una aplicación potencial de este trabajo es mejorar la efectividad de los modelos de aprendizaje automático que se utilizan para identificar enfermedades en imágenes médicas. Las soluciones de atajos en este contexto podrían conducir a diagnósticos falsos y tener implicaciones peligrosas para los pacientes.

“Todavía es difícil saber por qué las redes profundas toman las decisiones que toman y, en particular, en qué partes de los datos deciden enfocarse estas redes al tomar una decisión. Si podemos comprender con más detalle cómo funcionan los atajos, podemos ir aún más lejos para responder algunas de las preguntas fundamentales pero muy prácticas que son realmente importantes para las personas que intentan implementar estas redes ”, dice Joshua Robinson, estudiante de doctorado en el Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) y autor principal del artículo.

Robinson escribió el artículo con sus asesores, el autor principal Suvrit Sra, el profesor asociado de desarrollo profesional de Esther y Harold E. Edgerton en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación (EECS) y miembro principal del Instituto de Datos, Sistemas y Sociedad. (IDSS) y el Laboratorio de Sistemas de Información y Decisión; y Stefanie Jegelka, profesora asociada de desarrollo profesional de X-Consortium en EECS y miembro de CSAIL e IDSS; así como el profesor asistente de la Universidad de Pittsburgh Kayhan Batmanghelich y los estudiantes de doctorado Li Sun y Ke Yu. La investigación se presentará en la Conferencia sobre sistemas de procesamiento de información neuronal en diciembre.

El largo camino para comprender los atajos

Los investigadores centraron su estudio en el aprendizaje contrastivo, que es una forma poderosa de aprendizaje automático auto supervisado. En el aprendizaje automático auto supervisado, un modelo se entrena utilizando datos sin procesar que no tienen descripciones de etiquetas de humanos. Por lo tanto, se puede utilizar con éxito para una mayor variedad de datos.

Un modelo de aprendizaje auto-supervisado aprende representaciones útiles de datos, que se utilizan como entradas para diferentes tareas, como la clasificación de imágenes. Pero si el modelo toma atajos y no captura información importante, estas tareas tampoco podrán usar esa información.

Por ejemplo, si un modelo de aprendizaje auto-supervisado está capacitado para clasificar la neumonía en radiografías de varios hospitales, pero aprende a hacer predicciones basadas en una etiqueta que identifica el hospital del que proviene la exploración (porque algunos hospitales tienen más neumonía casos que otros), el modelo no funcionará bien cuando se le proporcionen datos de un nuevo hospital.

Para los modelos de aprendizaje contrastivo, se entrena un algoritmo codificador para discriminar entre pares de entradas similares y pares de entradas diferentes. Este proceso codifica datos ricos y complejos, como imágenes, de una manera que el modelo de aprendizaje contrastivo puede interpretar.

Los investigadores probaron codificadores de aprendizaje contrastivos con una serie de imágenes y descubrieron que, durante este procedimiento de entrenamiento, también son víctimas de soluciones de atajos. Los codificadores tienden a centrarse en las características más simples de una imagen para decidir qué pares de entradas son similares y cuáles no. Idealmente, el codificador debería centrarse en todas las características útiles de los datos al tomar una decisión, dice Jegelka.

Por lo tanto, el equipo hizo que fuera más difícil distinguir la diferencia entre los pares similares y diferentes, y descubrió que esto cambia las características que el codificador observará para tomar una decisión.

“Si hace que la tarea de discriminar entre elementos similares y diferentes sea cada vez más difícil, entonces su sistema se ve obligado a aprender información más significativa en los datos, porque sin aprender eso no puede resolver la tarea”, dice ella.

Pero el aumento de esta dificultad resultó en una compensación: el codificador mejoró al enfocarse en algunas características de los datos, pero empeoró al enfocarse en otras. Casi parecía olvidar las características más simples, dice Robinson.

Para evitar esta compensación, los investigadores le pidieron al codificador que discriminara entre los pares de la misma manera que lo había hecho originalmente, utilizando las características más simples, y también después de que los investigadores eliminaron la información que ya había aprendido. Resolver la tarea en ambos sentidos simultáneamente hizo que el codificador mejorara en todas las funciones.

Su método, llamado modificación implícita de características, modifica de forma adaptativa las muestras para eliminar las características más simples que utiliza el codificador para discriminar entre los pares. La técnica no depende de la participación humana, lo cual es importante porque los conjuntos de datos del mundo real pueden tener cientos de características diferentes que podrían combinarse de formas complejas, explica Sra.

De los coches a la EPOC

Los investigadores realizaron una prueba de este método utilizando imágenes de vehículos. Utilizaron la modificación de características implícitas para ajustar el color, la orientación y el tipo de vehículo para dificultar que el codificador discrimine entre pares de imágenes similares y diferentes. El codificador mejoró su precisión en las tres características (textura, forma y color) simultáneamente.

Para ver si el método resistiría datos más complejos, los investigadores también lo probaron con muestras de una base de datos de imágenes médicas de la enfermedad pulmonar obstructiva crónica (EPOC). Una vez más, el método generó mejoras simultáneas en todas las funciones que evaluaron.

Si bien este trabajo da algunos pasos importantes para comprender las causas de las soluciones de atajos y trabajar para resolverlas, los investigadores dicen que continuar perfeccionando estos métodos y aplicándolos a otros tipos de aprendizaje auto supervisado será clave para los avances futuros.

“Esto se relaciona con algunas de las preguntas más importantes sobre los sistemas de aprendizaje profundo, como ‘¿Por qué fallan?’ y ‘¿Podemos saber de antemano las situaciones en las que su modelo fallará?’ Aún queda mucho por hacer si desea comprender el aprendizaje de atajos en toda su generalidad ”, dice Robinson.

Reeditado por cortesía del MIT. Foto: Un modelo puede hacer una solución de atajo y aprender a identificar imágenes de vacas enfocándose en la hierba verde que aparece en las fotos, en lugar de las formas y patrones más complejos de las vacas. Créditos: Jose-Luis Olivares, MIT