Los modelos de lenguaje grande como GPT-4 de OpenAI y PaLM 2 de Google han dominado el ciclo de noticias durante los últimos meses. Y aunque todos pensábamos que el mundo de la IA volvería al ritmo lento habitual, eso aún no ha sucedido. Caso en cuestión: Google pasó casi una hora hablando de IA en su reciente discurso de apertura de E/S, donde también presentó hardware de vanguardia como Pixel Fold. Por lo tanto, no hace falta decir que la arquitectura de inteligencia artificial de próxima generación de la compañía, denominada Gemini, merece atención.

Gemini puede generar y procesar texto, imágenes y otros tipos de datos como gráficos y mapas. Así es, el futuro de la IA no son solo los chatbots o los generadores de imágenes. Tan impresionantes como esas herramientas pueden parecer hoy, Google cree que están lejos de maximizar todo el potencial de la tecnología. Entonces, en este artículo, analicemos lo que el gigante de las búsquedas pretende lograr con Gemini, cómo funciona y por qué señala el futuro de la IA.

Qué es Google Gemini: más allá de un modelo de lenguaje simple

Gemini es la arquitectura de inteligencia artificial de próxima generación de Google que eventualmente reemplazará a PaLM 2. Actualmente, este último impulsa muchos de los servicios de inteligencia artificial de la compañía, incluido el chatbot Bard y Duet AI en aplicaciones Workspace como Google Docs. En pocas palabras, Gemini permitirá que estos servicios analicen o generen simultáneamente texto, imágenes, audio, videos y otros tipos de datos.

Gracias a ChatGPT y Bing Chat, probablemente ya esté familiarizado con los modelos de aprendizaje automático que pueden comprender y generar lenguaje natural. Y es la misma historia con los generadores de imágenes de IA: con una sola línea de texto, pueden crear bellas artes o incluso imágenes fotorrealistas. Pero Gemini de Google irá un paso más allá, ya que no está limitado por un solo tipo de datos, y es por eso que puede escucharlo llamar modelo «multimodal».

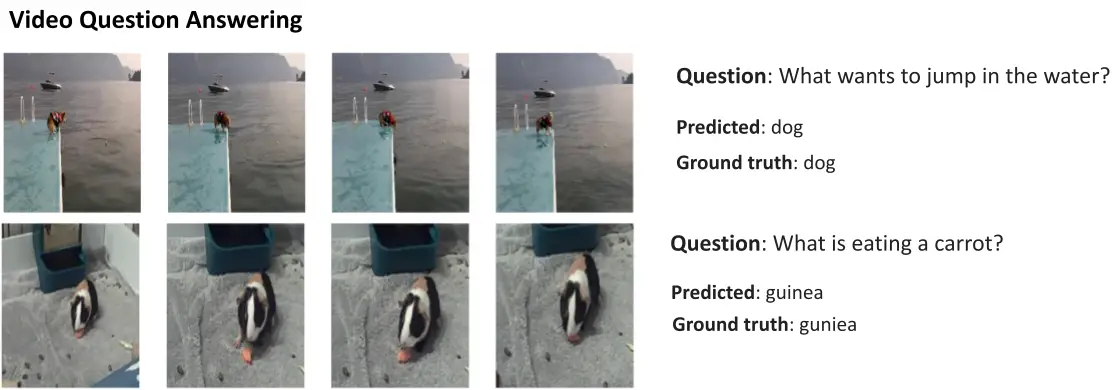

Este es un ejemplo que muestra las impresionantes capacidades de un modelo multimodal, cortesía del blog AI Research de Google. Muestra cómo la IA no solo puede extraer características de un video para generar un resumen, sino también responder preguntas de texto de seguimiento.

La capacidad de Gemini para combinar imágenes y texto también debería permitirle generar más de un tipo de datos al mismo tiempo. Imagine una IA que no solo pudiera escribir el contenido de una revista, sino también diseñar el diseño y los gráficos. O una IA que podría resumir un periódico completo o un podcast en función de los temas que más le interesan.

¿En qué se diferencia Gemini de otros modelos de lenguaje grande?

Calvin Wankhede / Autoridad de Android

Gemini se diferencia de otros modelos de idiomas grandes en que no solo se entrena solo con texto. Google dice que construyó el modelo con capacidades multimodales en mente. Eso indica que el futuro de la IA podría tener un propósito más general que las herramientas que tenemos hoy. La empresa también ha consolidado sus equipos de IA en una sola unidad de trabajo, ahora denominada Google DeepMind. Todo esto sugiere fuertemente que la compañía está apostando por Gemini para competir con GPT-4.

Un modelo multimodal puede decodificar muchos tipos de datos a la vez, de manera similar a cómo los humanos usan diferentes sentidos en el mundo real.

Entonces, ¿cómo funciona una IA multimodal como Google Gemini? Tiene algunos componentes principales que funcionan al unísono, comenzando con un codificador y un decodificador. Cuando se le da una entrada con más de un tipo de datos (como un fragmento de texto y una imagen), el codificador extrae todos los detalles relevantes de cada tipo de datos (modalidad) por separado.

Luego, la IA busca características o patrones importantes en los datos extraídos utilizando un mecanismo de atención, lo que esencialmente lo obliga a concentrarse en una tarea específica. Por ejemplo, identificar al animal en el ejemplo anterior implicaría mirar solo las áreas específicas de la imagen con un sujeto en movimiento. Finalmente, la IA puede fusionar la información que ha aprendido de diferentes tipos de datos para hacer una predicción.

¿Cuándo lanzará Google Gemini?

Cuando OpenAI anunció GPT-4, habló extensamente sobre la capacidad del modelo para manejar problemas multimodales. Aunque no hemos visto que estas funciones lleguen a servicios como ChatGPT Plus, las demostraciones que hemos visto hasta ahora parecen extremadamente prometedoras. Con Gemini, Google espera igualar o superar GPT-4, antes de que se quede atrás para siempre.

Todavía no tenemos los detalles técnicos de Gemini, pero Google ha confirmado que vendrá en diferentes tamaños. Si lo que hemos visto con PaLM 2 hasta ahora es cierto, eso podría significar cuatro modelos diferentes. El más pequeño puede incluso caber en un teléfono inteligente típico, por lo que es perfecto para la IA generativa sobre la marcha. Sin embargo, el resultado más probable es que Gemini llegue primero al chatbot de Bard y a otros servicios de Google.

Por ahora, todo lo que sabemos es que Géminis todavía está en su fase de entrenamiento. Una vez que esté completo, la compañía pasará a afinar y mejorar la seguridad. Esto último puede llevar un tiempo, ya que requiere que los trabajadores humanos califiquen manualmente las respuestas y guíen a la IA para que se comporte como un ser humano. Entonces, con todo esto en mente, es difícil responder cuándo Google lanzará Gemini, pero con la creciente competencia, no puede ser tan lejano.