La audiencia del Senado en la que participé hace unas semanas fue, en muchos sentidos, el punto culminante de mi carrera. Me emocionó lo que vi del Senado ese día: interés genuino y humildad genuina. Los senadores reconocieron que fueron demasiado lentos para averiguar qué hacer con las redes sociales, que los movimientos se hicieron entonces y que ahora había un sentido de urgencia. Estoy profundamente agradecido con la oficina del Senador Blumenthal por permitirme participar, y me alienta enormemente que haya mucho más consenso bipartidista en torno a la regulación de lo que había anticipado. Las cosas se han movido en una dirección positiva desde entonces.

Pero aún no hemos aterrizado el avión.

§

Solo unas semanas antes, había estado escribiendo en este Substack y en The Economist (con Anka Reuel) sobre la necesidad de una agencia internacional para la IA. Para mi gran sorpresa, el CEO de OpenAI, Sam Altman, me dijo antes de que comenzara el proceso que apoyaba la idea. Tomado por sorpresa, respondí: «Fantástico, deberías decírselo al Senado», sin esperar que lo hiciera. Para mi asombro, lo hizo, interrumpiendo, después de que planteé la noción de IA global, que «quería hacerse eco de lo que dijo el Sr. Marcus».

Las cosas, en muchos sentidos, se han movido rápidamente desde entonces, mucho más rápido de lo que podría haber soñado. En 2017, propuse un CERN para IA, en Los New York Times, con relativamente poca respuesta. Esta vez, las cosas (al menos nominalmente) se están moviendo a una velocidad vertiginosa. A principios de esta semana, el primer ministro británico, Rishi Sunak, pidió explícitamente un CERN para la IA, así como algo así como un OIEA para la IA, todo muy en línea con lo que yo y otros esperábamos. Hoy temprano, el presidente Biden y el primer ministro Sunak acordaron hoy, públicamente, «trabajar juntos en la seguridad de la IA».

Todo eso es increíblemente gratificante. Y sin embargo… sigo preocupado. Realmente, realmente preocupado.

§

Lo que me preocupa es la captura regulatoria; gobiernos que crean reglas que afianzan a los titulares, mientras hacen muy poco por la humanidad.

La posibilidad realista de este escenario fue capturada visceralmente en un agudo tuit de hoy, de la experta en tecnología británica Rachel Coldicutt:

Tuve una sensación similar en la boca del estómago en mayo después de que la vicepresidenta Kamala Harris se reuniera con algunos ejecutivos de tecnología, y los científicos apenas se mencionaron:

§

Dicho sin rodeos: si tenemos la bien regulación; las cosas pueden ir bien. Si tenemos la regulación equivocada, las cosas podrían ir mal. Si la gran tecnología escribe las reglas, sin aportes externos, es poco probable que terminemos con las reglas correctas.

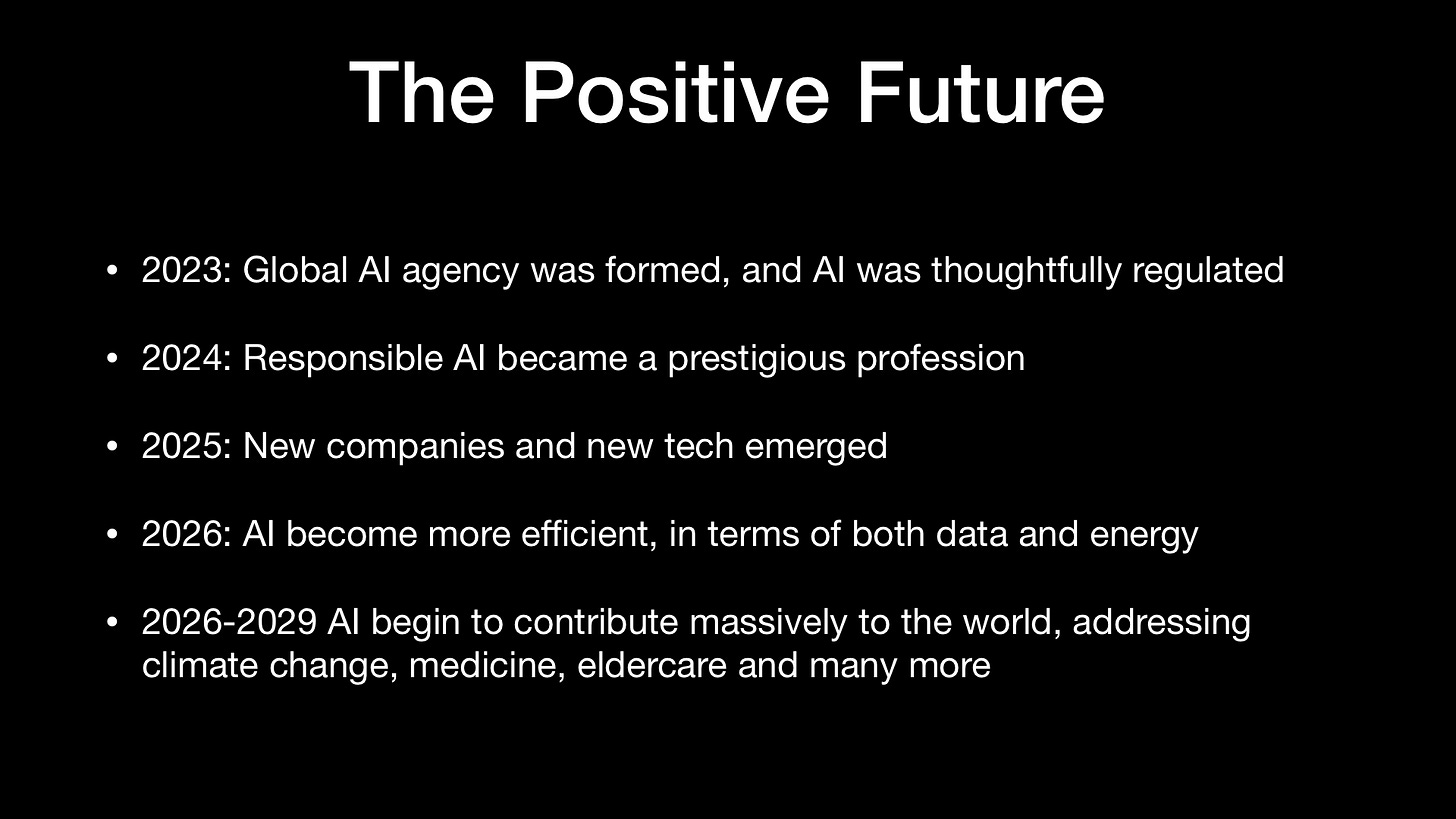

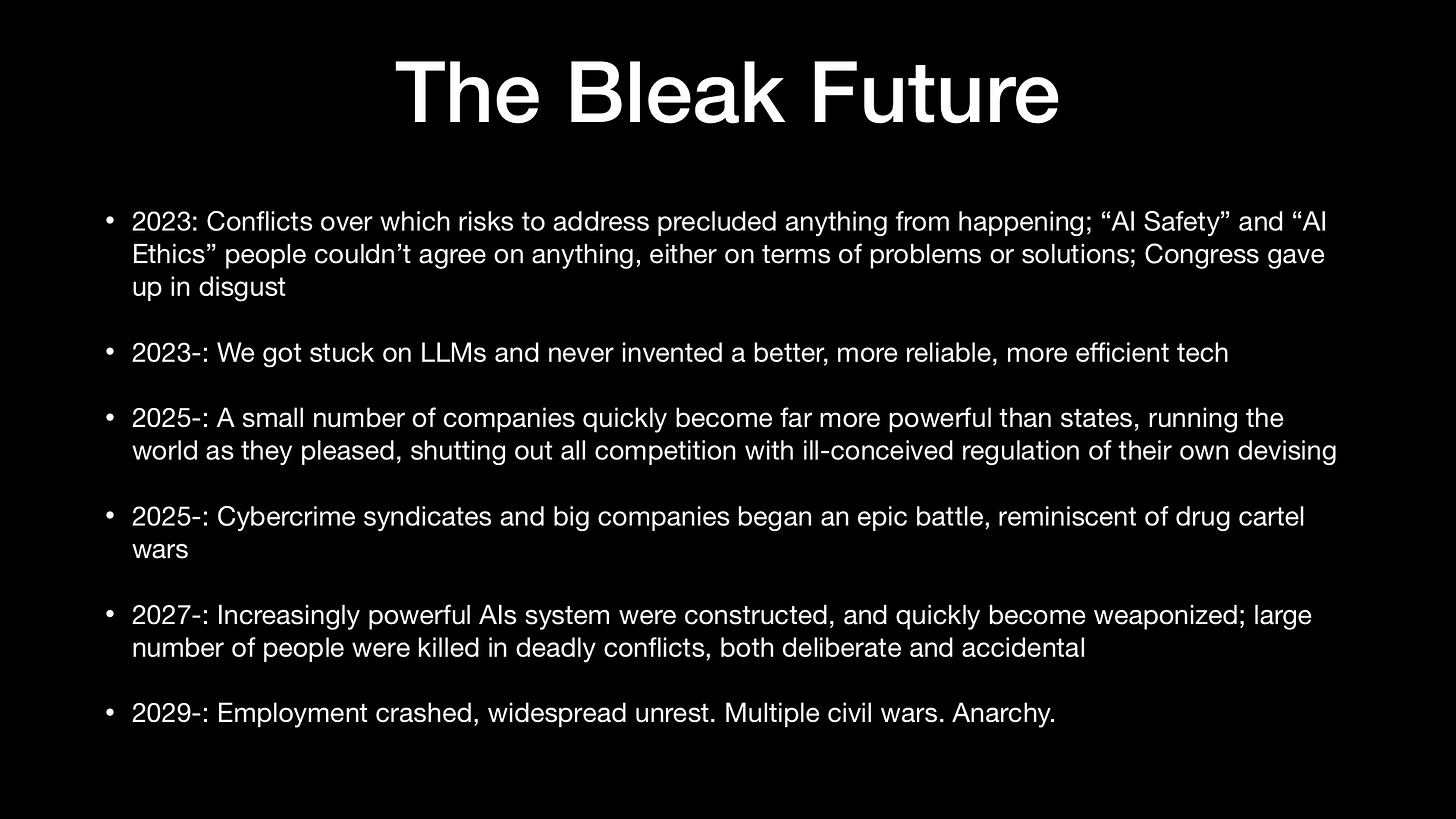

En una charla que di hoy al FMI, describí dos escenarios, uno positivo y otro negativo:

§

Todavía tenemos agencia aquí; todavía podemos, creo, construir un futuro de IA muy positivo.

Pero mucho depende de cuánto se enfrente el gobierno a las grandes tecnologías, y mucho de eso depende de tener voces independientes (científicos, especialistas en ética y representantes de la sociedad civil) en la mesa. Los comunicados de prensa y las oportunidades fotográficas que destacan a los gobiernos saliendo con los magnates de la tecnología que buscan regular, sin voces independientes en la sala, envían un mensaje totalmente equivocado.

La goma se encuentra con el camino en la ejecución. Tenemos, por ejemplo, Microsoft declarando en este momento que la transparencia y la seguridad son clave. Pero sus productos reales actuales definitivamente no son transparentes y, al menos en algunos aspectos, se puede demostrar que no son seguros.

Bing se basa en GPT-4, y nosotros (p. ej., en la comunidad científica) no tenemos acceso a cómo funciona GPT-4, y no tenemos acceso a los datos en los que está entrenado (vital, ya que sabemos que los sistemas puede sesgar, por ejemplo, el pensamiento político y las decisiones de contratación basadas en esos datos no revelados), eso es lo más lejos de la transparencia que podríamos estar.

También sabemos, por ejemplo, que Bing ha difamado a la gente y ha malinterpretado los artículos diciendo lo contrario de lo que realmente dicen, al servicio de hacerlo. Recomendar a Kevin Roose que se divorciara tampoco era muy competente. Mientras tanto, los complementos de ChatGPT (producidos por OpenAI, con el que tienen un estrecho vínculo) abren una amplia gama de problemas de seguridad: esos complementos pueden acceder a Internet, leer y escribir archivos y hacerse pasar por personas (p. alarmas a cualquier profesional de la seguridad. No veo ninguna razón para pensar que estos complementos son seguros. (Están mucho menos aislados y controlados con menos rigor que las aplicaciones de la tienda de aplicaciones de Apple).

Aquí es donde el gobierno debe dar un paso adelante y decir: «La transparencia y la seguridad son de hecho requisitos; los ha incumplido; no lo dejaremos hacer más».

No necesitamos más oportunidades para tomar fotografías, necesitamos regulación, con dientes.

§

En términos más generales, como mínimo absoluto, los gobiernos deben establecer un proceso de aprobación para cualquier IA que se implemente a gran escala, que demuestre que los beneficios superan los riesgos, y para mandato auditoría posterior al lanzamiento, por parte de personas externas independientes, de cualquier implementación a gran escala. Los gobiernos deben exigir que los sistemas solo usen contenido con derechos de autor de proveedores de contenido que opten por participar, y que todo el contenido generado por máquinas se etiquete como tal. Y los gobiernos deben asegurarse de que existan leyes estrictas de responsabilidad, para garantizar que, si las grandes empresas de tecnología causan daños con sus productos, sean responsables.

Es poco probable que dejar que las empresas establezcan las reglas por su cuenta nos lleve a ninguno de estos lugares.

§

Después de las audiencias del Senado, un deporte popular es preguntar: «¿Sam Altman es sincero cuando ha pedido que el gobierno regule la IA?»

Mucha gente dudaba de él; Habiéndome sentado a un metro de él, durante todo el testimonio, y observando su lenguaje corporal, en realidad creo que es, al menos en parte, sincero, que no es solo una estratagema para mantener a los titulares dentro y a los pequeños competidores fuera, que es genuinamente preocupado por los riesgos (que van desde la desinformación hasta daños físicos graves a la humanidad). Se lo dije al Senado, por lo que vale.

Pero no importa si Sam es sincero o no. Él no es el único actor en esta obra; Microsoft, por ejemplo, tiene acceso, según tengo entendido, según los rumores, a todos los modelos de OpenAI, y puede hacer lo que quiera con ellos. Si Sam está preocupado, pero Nadella quiere correr hacia adelante, Nadella tiene ese derecho. Nadella ha dicho que quiere hacer bailar a Google, y lo ha hecho.

Lo que realmente importa es lo que proponen los gobiernos de todo el mundo a modo de regulación.

Nunca dejaríamos que la industria farmacéutica se autorregulara por completo, y tampoco deberíamos dejar que la IA lo haga. No importa lo que diga Microsoft, OpenAI o Google. Importa lo que diga el gobierno.

O se enfrentan a Big Tech, o no lo hacen; el destino de la humanidad muy bien puede descansar en la balanza.

marcus gary (@garymarcus), científico, autor de bestsellers y empresario, profundamente preocupado por la IA actual, pero con la esperanza de que podamos hacerlo mejor. Habló ante el Senado de los EE. UU. el 16 de mayo y es coautor del galardonado libro Rebooting AI, así como presentador del nuevo podcast Humans versus Machines.

entradas no encontradas