Los modelos de lenguaje grande se han vuelto significativamente populares recientemente y se encuentran principalmente en los titulares. GPT-4, que se lanzó recientemente en marzo de 2023, es uno de los modelos de transformadores más conocidos. Es la tecnología detrás del famoso ChatGPT desarrollado por OpenAI. El chatbot puede generar información textual e imitar a los humanos al responder preguntas. Tras el gran éxito de GPT 3.5, GPT-4 es el último hito en la ampliación del aprendizaje profundo y la inteligencia artificial generativa.

A diferencia de la versión anterior, GPT 3.5, que solo permite que ChatGPT tome entradas de texto, la última GPT-4 es de naturaleza multimodal, lo que significa que acepta texto e imágenes como entrada. Otro modelo llamado LLaMA (Large Language Model Meta AI) fue lanzado por Meta AI en el mes de febrero de 2023. Con parámetros 13B, los investigadores detrás del desarrollo de LLaMA mencionaron cómo el rendimiento del modelo en la mayoría de los puntos de referencia de NLP superó el mucho mayor 175 B GPT- 3. El modelo más grande era incluso competitivo con modelos de última generación como PaLM y Chinchilla.

Ahora viene Vicuna, un chatbot de código abierto con parámetros 13B, desarrollado por un equipo de UC Berkeley, CMU, Stanford y UC San Diego y entrenado mediante el ajuste fino de LLaMA en conversaciones compartidas por los usuarios. Las conversaciones se recopilaron de ShareGPT a través de API públicas. ShareGPT es una extensión de Chrome que permite a los usuarios compartir sus conversaciones anteriores de ChatGPT con otros con un solo clic. Vicuna ha sido creado simplemente ajustando el modelo base de LLaMA. Ha utilizado alrededor de 70K conversaciones compartidas por usuarios en ShareGPT.

🚀 ÚNETE a la comunidad subreddit de ML más rápida

El código de capacitación, servicio y evaluación se ha compartido en https://github.com/lm-sys/FastChat. Los investigadores mencionaron que mientras recopilaban los datos de las conversaciones, la parte HTML se volvió a convertir al lenguaje de rebajas. Esto se ha hecho para filtrar las conversaciones que eran inapropiadas o de baja calidad. Además, las conversaciones largas se han dividido en segmentos más pequeños para que se ajusten a la longitud máxima del contexto del modelo.

El modelo se ha construido sobre la parte superior de Stanford’s Alpaca con ciertas mejoras, como:

- Optimización de la memoria: la longitud máxima del contexto se incrementó de 512 en alpaca a 2048, lo que aumenta los requisitos de memoria de la GPU. El uso de la memoria se ha solucionado mediante el uso de puntos de control de gradiente y atención flash.

- Conversaciones de varias rondas: el proceso de capacitación se ha ajustado para tener en cuenta las conversaciones de varias rondas. Esto permite que el chatbot responda con mayor precisión a conversaciones de múltiples rondas para una experiencia de alta calidad.

- Reducción de costos: el punto administrado por SkyPilot se ha utilizado para reducir los costos de capacitación utilizando instancias más económicas con recuperación automática y cambio de zona. Esto ayudó a entrenar el modelo 7B por alrededor de $140 y el modelo 13B por alrededor de $300.

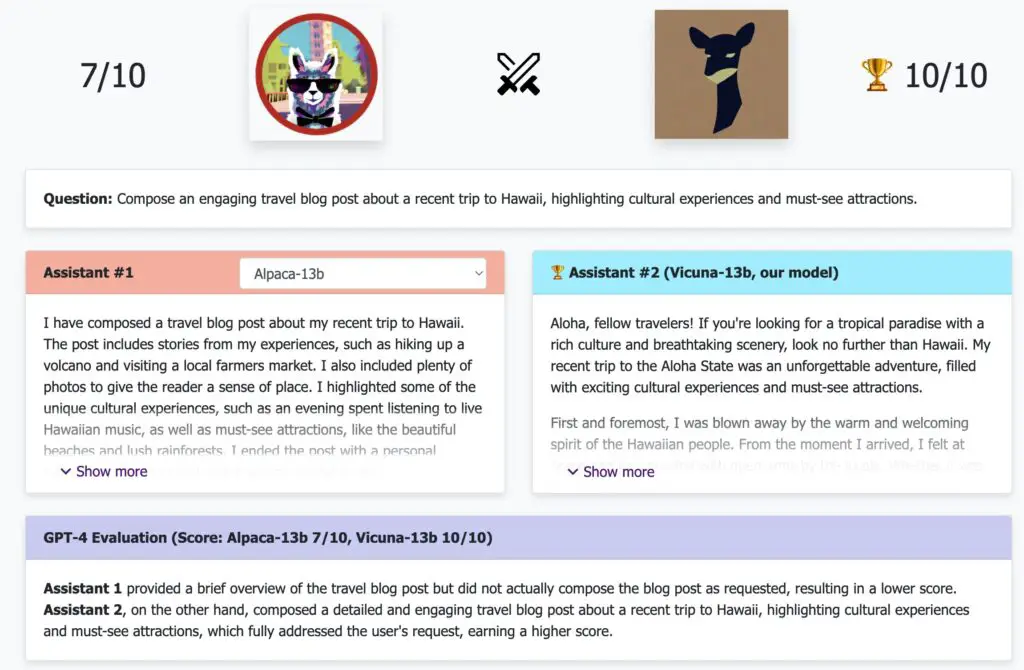

El equipo detrás de LLaMA ha evaluado el desempeño de Vicuña utilizando el modelo GPT-4. Vicuna obtuvo excelentes resultados y logró un puntaje de calidad de más del 90% en comparación con otros chatbots famosos como ChatGPT y Google Bard. Funcionó mejor que los modelos de chatbot como LLaMA y Stanford Alpaca en más del 90 % de los casos. El costo total de capacitar a Vicuna es de alrededor de $300, lo que la convierte en una solución buena y rentable para el desarrollo de chatbots.

Vicuna-13B es un gran desarrollo de bajo costo en el dominio de los chatbots. Aunque tiene ciertas limitaciones cuando se trata de razonamiento o matemáticas, con más investigación y modificaciones, realmente puede resultar útil y prometedor para uso futuro.

Revisar la Blog, Github y Manifestación. Todo el crédito de esta investigación es para los investigadores de este proyecto. Además, no olvides unirte nuestro SubReddit de 17k+ ML, Canal de discordiay Boletín electrónicodonde compartimos las últimas noticias de investigación de IA, interesantes proyectos de IA y más.

Tanya Malhotra es estudiante de último año de la Universidad de Estudios de Petróleo y Energía, Dehradun, y cursa BTech en Ingeniería Informática con especialización en Inteligencia Artificial y Aprendizaje Automático.

Es una entusiasta de la ciencia de datos con buen pensamiento analítico y crítico, junto con un gran interés en adquirir nuevas habilidades, liderar grupos y administrar el trabajo de manera organizada.

🔥 Debe leer: ¿Qué es la alucinación de IA? ¿Qué falla con los chatbots de IA? ¿Cómo detectar una inteligencia artificial alucinante?