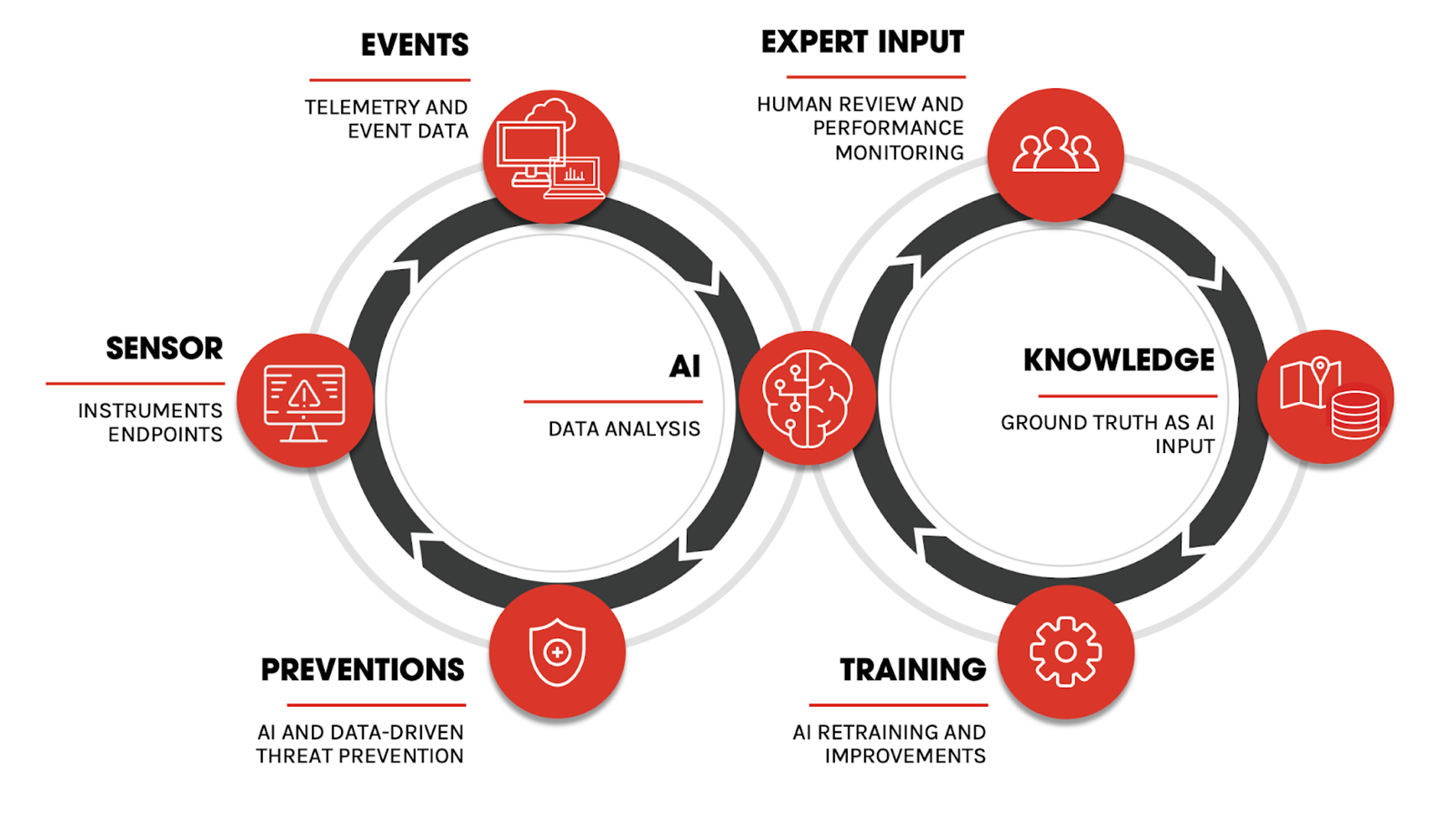

CrowdStrike Security Cloud procesa más de un billón de eventos de sensores de punto final por día, pero los profesionales humanos desempeñan un papel vital al proporcionar la estructura y la verdad básica para que la inteligencia artificial (IA) sea efectiva. Sin profesionales humanos, la IA es inútil.

Hay un nuevo tropo en la industria de la seguridad, y es más o menos así: para mantenerse a salvo, necesita una solución impulsada por IA que pueda actuar por sí sola, y para hacer eso, debe mantener alejados a esos molestos humanos. eso. Como profesional con un historial de llevar IA a la ciberseguridad, no porque arquitectura lo exige en estos días, pero debido a su utilidad real para resolver problemas de seguridad, esta caracterización me parece desconcertante.

Si esto le suena controvertido, tenga en cuenta que solo sucede en la industria de la ciberseguridad. Esta caracterización es totalmente indiscutible entre los investigadores de IA y aprendizaje automático (ML). E incluso en otras industrias, aprovechar la experiencia humana es completamente normal. ¿Cuánto así? Puede comprar servicios para que sus conjuntos de datos sean etiquetados por humanos. Algunas empresas incluso aprovechan procesos colaborativos para obtener etiquetas de usuarios habituales. Probablemente ya hayas contribuido a tal esfuerzo al demostrar que no eres un robot para un sitio web.

falacias

¿Cómo se generalizó esta postura de seguridad misantrópica? Hay dos falacias en juego. Si eres una persona que ve el vaso medio lleno, podrías llamar a esos conceptos erróneos. Pero si te enfocas en la mitad superior del vaso, podrías llamar a esas tergiversaciones. Primero, la inteligencia artificial no es, de hecho, inteligente. Tenga una conversación con su altavoz inteligente para asegurarse de ese hecho. La IA es un conjunto de algoritmos y técnicas que a menudo produce resultados útiles. Pero a veces fallan de formas extrañas y poco intuitivas. Incluso tiene su propio distintivo. superficie de ataque que los adversarios pueden aprovechar si se dejan desprotegidos. Tratar a la IA como la panacea que soluciona los problemas de nuestra industria es peligroso, como mencioné el año pasado en un charla invitada en el taller de Robustez de los sistemas de IA contra ataques adversarios.

En segundo lugar, todavía estamos todos hastiados de los días de la firma. En ese entonces, las firmas se implementaron, inicialmente detuvieron las amenazas, luego comenzaron a perder nuevas amenazas, lo que llevó a los humanos a escribir nuevas firmas y reiniciar el ciclo al día siguiente. Naturalmente, este enfoque es una propuesta perdedora: este modelo no solo es puramente reactivo, sino que su velocidad también está claramente limitada por el tiempo de respuesta humano. Por supuesto, no es así como se integran los modelos de IA para prevenir amenazas. No se necesita interacción humana para que un modelo de IA en la plataforma CrowdStrike Falcon® detenga una amenaza en seco. CrowdStrike utiliza específicamente IA para detectar amenazas que aún no han sido concebidas — sin necesidad de actualizaciones.

Datos, datos, datos

¿Qué se necesita para entrenar un modelo de IA que pueda hacer tal hazaña de manera confiable? Lo más importante es que necesita datos. Y mucho de ello. CrowdStrike Security Cloud procesa más de un billón de eventos desde sensores de punto final por día. Para poner esto en perspectiva, una resma de 500 páginas de papel de impresora de oficina tiene un grosor de unos 50 milímetros (unas 2 pulgadas). Un billón de páginas se acumularían a una altura de unos 100 000 kilómetros, o aproximadamente 60 000 millas. Esas son suficientes millas para obtener el estatus de oro diario en la mayoría de las aerolíneas, pero le tomaría alrededor de cuatro días volar esta distancia a la velocidad de crucero de un avión regular. Y después de esos cuatro días, la pila habrá llegado a la luna.

Sin embargo, lo esencial es que esta pila metafórica no solo es alta. CrowdStrike Security Cloud también tiene una gran huella que cubre facetas como seguridad de punto final, seguridad en la nube, protección de identidad, inteligencia de amenazas y mucho más. Para cada una de estas facetas, procesamos registros de datos complejos y matizados. Toda esta información se contextualiza y correlaciona en nuestro gráfico de amenazas CrowdStrike patentado.®una gran base de datos de gráficos distribuidos que desarrollamos.

La plataforma Falcon se diseñó desde cero como un sistema nativo de la nube para procesar eficazmente este volumen de datos de manera significativa. Nada de esto es posible en un aparato. Y nada de esto es posible con las soluciones de nube híbrida, es decir, esas nubes que son simplemente montones de dispositivos montados en rack administrados por proveedores. Esos tienen tanto sentido como la transmisión de video a través de Internet desde una videograbadora.

Más datos nos permiten detectar señales más débiles. Imagine trazar la latitud y la longitud de las ciudades de EE. UU. en papel cuadriculado. Inicialmente, verá algunos puntos dispersos al azar. Después de hacer esto para una gran cantidad de ciudades, una forma familiar emergerá lentamente de una nube de puntos. Y esa sería la forma de los Estados Unidos. Sin embargo, esa forma nunca se habría hecho evidente si todos hubieran usado un papel cuadriculado «local» para trazar un puñado de ciudades en su vecindad.

Estructura y verdad fundamental

Entonces, ¿cómo encajan los humanos en la imagen? Si hay tanta información apilada en nuestra pila metafórica de papel de impresora que incluso un avión no podría seguirle el ritmo, ¿cómo tienen los humanos la oportunidad de luchar para tener un impacto?

Hay dos maneras. Primero, apilar las hojas no es la forma más inteligente de organizarlas. Al colocarlos planos uno al lado del otro, se obtiene un cuadrado de papel de aproximadamente 250 por 250 kilómetros (alrededor de 150 millas por lado). Eso es mucho más manejable: se podría mapear un área como esta. Si, en cambio, organizamos las resmas de papel en un cubo, sería un cubo de unos 180 × 180 × 180 metros (o unos 600 pies por arista). Observe que ahora son metros, ya no kilómetros, lo que lo hace mucho más compacto y está listo para ser cartografiado. La conclusión es que el problema se vuelve más manejable al organizar los datos en más dimensiones y considerar las adyacencias. Esa es la misión de nuestra nube y Threat Graph.

En segundo lugar, no todos los datos se crean de la misma manera. Hay otro tipo de datos a los que los humanos pueden contribuir. A este tipo de datos lo llamamos verdad básica, y tiene un impacto significativo en el entrenamiento de modelos de IA. La verdad básica es el tipo de datos que describen cómo queremos que se comporte un modelo de IA bajo cierta entrada. Para nuestra pila de papel metafórico, un ejemplo de verdad básica sería si una hoja de papel corresponde a una amenaza (por ejemplo, una hoja de color rojo) o actividades benignas (una hoja de color verde). Si organiza sus datos de manera significativa, como se describió anteriormente, solo necesita unas pocas hojas de colores para deducir la información de resmas enteras de papel. Imagina que sacas una hoja de una resma en algún lugar de nuestro cubo de papel y resulta que es roja. Es probable que las otras hojas de esa resma también sean rojas. Y algunas de las resmas adyacentes también tendrán en su mayoría papel rojo. Así es como aprenden ciertos tipos de IA: descubren cómo reaccionar ante entradas similares (adyacentes) basadas en la verdad del terreno; esto se llama supervisado aprendiendo.

El aprendizaje supervisado es una forma poderosa de crear sistemas de clasificación altamente precisos, es decir, sistemas que tienen altas tasas de verdaderos positivos (detectando amenazas de manera confiable) y bajas tasas de falsos positivos (rara vez provocan alarmas sobre comportamiento benigno). No todo el aprendizaje debe llevarse a cabo utilizando la verdad básica (el dominio de sin supervisión el aprendizaje tiene que ver con otras técnicas, por ejemplo). Pero tan pronto como sea el momento de evaluar si un sistema de IA de este tipo funciona según lo previsto, también necesitará la verdad sobre el terreno.

Por último, dado que la verdad sobre el terreno suele ser un bien escaso, más escaso que otros datos, otras técnicas combinan estos dos enfoques. En semi-supervisado En el aprendizaje, una IA se entrena con grandes cantidades de datos sin supervisión, y luego se ajusta mediante un entrenamiento supervisado utilizando menos datos reales. En auto-supervisado aprendizaje, la IA toma pistas de la estructura de los datos mismos.

Humanos, humanos, humanos

En CrowdStrike, diseñamos nuestros sistemas para maximizar la generación de datos reales. Por ejemplo, cada vez que los cazadores de amenazas CrowdStrike Falcon OverWatch™ encuentran un adversario en la red, esos hallazgos se convierten en una nueva realidad. Del mismo modo, cuando los expertos de OverWatch evalúan la actividad sospechosa como benigna, también se convierte en verdad. Esos puntos de datos ayudan a entrenar o evaluar los sistemas de IA. Generamos datos de este tipo a escala todos los días utilizando nuestro punto de vista en la nube. Esto nos permite entrenar mejores modelos y construir mejores sistemas con características de rendimiento mejor entendidas.

Los sistemas de IA también pueden incidentes de bandera donde la verdad fundamental es más escasa y existe un mayor nivel de incertidumbre. Si bien la IA aún puede prevenir amenazas en esas circunstancias sin demora, los datos marcados pueden ser revisados luego por humanos para aumentar la cantidad de verdad disponible donde más importa. Alternativamente, otros medios pueden proporcionar datos adicionales, como una detonación dentro de el entorno de pruebas de análisis de malware CrowdStrike Falcon X™ para observar comportamientos de amenazas en un entorno controlado. Tales soluciones se basan en un paradigma llamado activo aprendiendo.

El aprendizaje activo es una forma útil de gastar el recurso limitado de la atención humana donde más importa. Las decisiones de la IA no se estancan: la IA seguirá analizando y deteniendo las amenazas. A esto lo llamamos el «bucle rápido». El equipo de Falcon OverWatch, entre otros, analiza la superficie de nuestros sistemas de IA y proporciona una disposición experta, que retroalimentamos a nuestros algoritmos de IA. A lo largo de esta ruta, nuestros modelos de IA reciben un flujo constante de comentarios sobre dónde tuvieron éxito y dónde detectamos y detuvimos ataques novedosos por otros medios. La IA aprende de estos comentarios y los incorpora en futuras detecciones. Llamamos a esta parte “el bucle largo”. Como resultado, nuestra IA mejora constantemente a medida que ingresan nuevos datos al sistema.

Puntos de prueba

Demostramos que este enfoque es superior todos los días en el campo cuando rechazamos a los adversarios de las redes de nuestros clientes, evitamos el robo de datos y nos aseguramos de que el alma de las empresas a las que servimos, su información y propiedad intelectual, esté protegida.

Además, tenemos un riguroso registro de pruebas de numerosas evaluaciones independientes de terceros realizadas por organizaciones de pruebas líderes como AV-Comparatives, SE Labs y MITRE. Los proveedores centrados en IA tienden a evitar las pruebas que penalizan los falsos positivos, pero no CrowdStrike. Los informes públicos de organizaciones de pruebas independientes atestiguan el compromiso de CrowdStrike con la transparencia, especialmente con la IA convirtiéndose en una tecnología omnipresente para trabajar con datos.

Fuera de las pruebas, CrowdStrike también fue el primer proveedor de NGAV en hacer que nuestra tecnología esté fácilmente disponible en VirusTotal para el escrutinio público, y proporcionamos nuestra tecnología fácilmente para que la comunidad de investigación la utilice en Análisis híbrido. La transparencia es un principio central de nuestro enfoque de privacidad por diseño: CrowdStrike diseña sus ofertas con la transparencia como un valor central para que los clientes puedan ver qué se procesa exactamente, tomar decisiones sobre cómo se procesa y seleccionar períodos de retención.

Pensamientos finales

La IA se está convirtiendo en una herramienta más común para detener las amenazas cibernéticas, pero es importante mirar más allá de la mera presencia de un algoritmo de IA en algún lugar del flujo de datos. Es fundamental medir la eficacia de un sistema de IA al comprender de dónde provienen los datos, incluida la verdad básica necesaria. La inteligencia artificial puede aprender solo si los nuevos hechos ingresan constantemente al sistema a escala, y los humanos en el circuito son un sello distintivo de un sistema de IA bien diseñado.