GAITHERSBURG, Md., 6 de octubre de 2022 — Utilizando el aprendizaje automático y un modelo matemático establecido, los científicos del Instituto Nacional de Estándares y Tecnología (NIST) desarrollaron un algoritmo basado en el aprendizaje automático para predecir la deriva en la red de Bragg de fibra existente (FBG) sensores de temperatura. El algoritmo podría usarse para reducir el efecto de la deriva sin necesidad de comprar o desarrollar una nueva tecnología de sensores.

“Es un enfoque alternativo en el que puedes tener tu pastel (mantener la tecnología existente) y comértelo también (reducir la contribución de la deriva a largo plazo)”, dijo el investigador Zeeshan Ahmed. “Los sensores de rejilla de Bragg de fibra son baratos. En lugar de dedicar cinco años a desarrollar mejores materiales, ¿por qué no usar este algoritmo o uno similar en esta familia de algoritmos?

Los sensores de temperatura FBG, integrados en las estructuras, se utilizan habitualmente en la infraestructura civil y en las industrias del petróleo y el gas. Sin embargo, no son lo suficientemente precisos para otras aplicaciones, como monitorear temperaturas en refrigeradores de grado médico.

Un impacto significativo en la precisión de los sensores proviene de la deriva a largo plazo. Los sensores de Bragg funcionan manipulando la interacción entre la luz y las estructuras grabadas en un cable de fibra óptica. Cuando el sensor Bragg se expone a altas temperaturas a lo largo del tiempo, el índice de refracción de la fibra cambia. Se cree que el cambio en el índice de refracción es la causa de los errores de deriva.

Recalibrar el sensor cada pocos meses corrige el problema; pero esto puede ser costoso y llevar mucho tiempo, especialmente si el sensor está enterrado en concreto o incrustado permanentemente en una estructura. Además, la desviación a largo plazo en los sensores Bragg provoca incertidumbres en la medición de temperatura que van desde 200 a 300 mK, el equivalente de un tercio a medio grado Fahrenheit.

“Para ser competitivo con la tecnología existente, desea reducirlo a aproximadamente la mitad de ese valor y, si es posible, a unas pocas decenas de milikelvin”, dijo Ahmed.

Ahmed y el equipo estudiaron la evolución temporal de la respuesta de temperatura de 14 sensores que se sometieron a ciclos repetidos entre 233 y 393 K. Después de evaluar varios modelos de calibración, determinaron que un modelo de regresión dinámica podría reducir efectivamente la incertidumbre de medición debido a la desviación en hasta aproximadamente 70%. Esto podría ser suficiente para estudiar algunos procesos, como la fermentación industrial, que dependen del control de la temperatura.

Además, encontraron que la cantidad total de luz reflejada por la rejilla y la intensidad de la luz en cada longitud de onda fueron útiles para predecir la deriva futura. El historial del sensor, por ejemplo, qué tan rápido se calentó o enfrió, o qué tan alta fue su temperatura en las horas previas al cambio de temperatura, también fue útil para pronosticar la deriva.

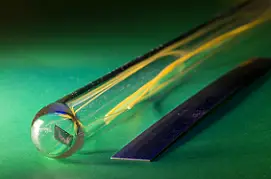

Un prototipo temprano de un termómetro fotónico basado en chip. El sensor está integrado en el chip, mientras que la luz entra y sale del sensor a través de fibras ópticas. Un enfoque desarrollado recientemente mejora la precisión de los sensores de red de Bragg de fibra sin necesidad de recalibración. Cortesía de Jennifer Lauren Lee/NIST.

Los investigadores aplicaron modelos Autoregressive Integrative Moving Average (ARIMA), una clase de modelos matemáticos creados en la década de 1970, para reducir las incertidumbres de medición. “No estoy usando la técnica más avanzada”, dijo Ahmed. “Incluso los métodos más antiguos pueden brindarle mucha información”.

La desventaja de este modelo es que solo funciona para la deriva a corto plazo que ocurre durante unas pocas semanas en lugar de durante meses o años.

Los investigadores del NIST están desarrollando termómetros fotónicos basados en chips que, en comparación con las técnicas tradicionales de termometría, prometen ser más pequeños y duraderos, resistentes a las interferencias electromagnéticas y potencialmente autocalibrables. Estos sensores aún se encuentran en fase de prueba.

La intención original de Ahmed era simplemente ayudar a los científicos a comprender mejor el problema de la deriva. “Pensé que si puedo entender el proceso directo y compensarlo matemáticamente, entonces puedo reducir estas incertidumbres a un nivel aceptable”, dijo. Su trabajo de prueba de concepto muestra cómo el aprendizaje automático puede permitir a los investigadores crear sensores de autocalibración o autocorrección utilizando la tecnología existente.

Un segundo artículo, aún en revisión, describe el trabajo de Ahmed para crear un verdadero modelo basado en la física que establezca la relación fundamental entre la longitud de onda y la temperatura en termómetros fotónicos basados en fibra y chips.

«Eso sería aún mejor», dijo. “Si tenemos un modelo basado en la física, entonces podemos describir cómo la física está cambiando con el tiempo y

La investigación fue publicada en Sensores y Actuadores A: Físico (www.doi.org/10.1016/j.sna.2022.113872).