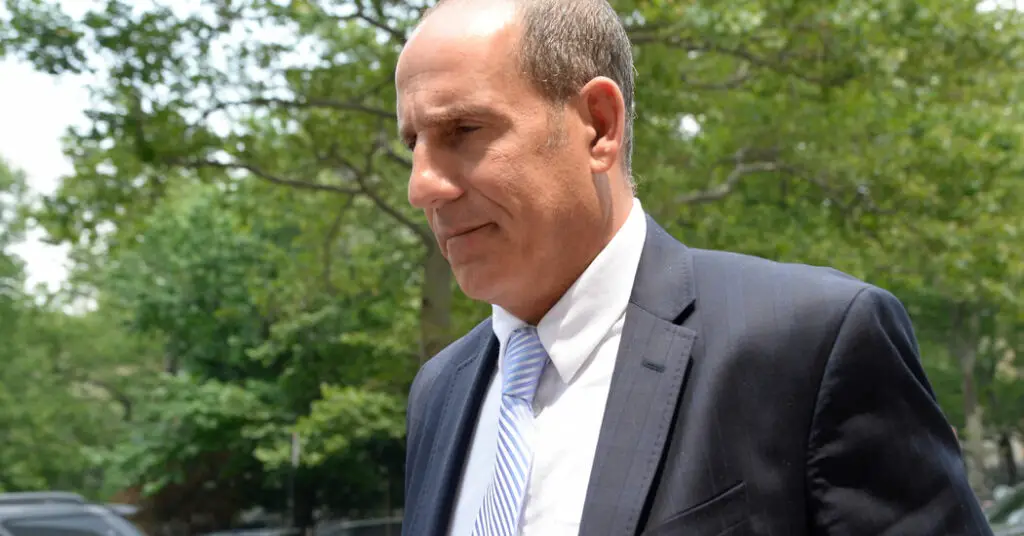

Cuando comenzó la audiencia en la corte en Manhattan, el abogado, Steven A. Schwartz, parecía nerviosamente optimista, sonriendo mientras hablaba con su equipo legal. Casi dos horas después, el Sr. Schwartz se sentó desplomado, con los hombros caídos y la cabeza apenas sobresaliendo del respaldo de la silla.

El jueves, durante casi dos horas, el Sr. Schwartz fue interrogado por un juez en una audiencia ordenada luego de que se revelara que el abogado había creado un informe legal para un caso en el Tribunal Federal de Distrito que estaba lleno de opiniones judiciales falsas y citaciones legales, todas generadas por ChatGPT. El juez, P. Kevin Castel, dijo que ahora consideraría imponer sanciones a Schwartz y su socio, Peter LoDuca, cuyo nombre figura en el escrito.

En ocasiones durante la audiencia, el Sr. Schwartz cerró los ojos con fuerza y se frotó la frente con la mano izquierda. Tartamudeó y bajó la voz. En repetidas ocasiones trató de explicar por qué no realizó más investigaciones sobre los casos que ChatGPT le había proporcionado.

“Dios, desearía haber hecho eso y no haberlo hecho”, dijo Schwartz, y agregó que se sentía avergonzado, humillado y profundamente arrepentido.

“No entendí que ChatGPT pudiera fabricar casos”, le dijo al juez Castel.

En contraste con las posturas contritas del Sr. Schwartz, el juez Castel gesticulaba a menudo con exasperación, alzando la voz al hacer preguntas mordaces. En repetidas ocasiones, el juez levantó ambos brazos en el aire, con las palmas hacia arriba, mientras le preguntaba a Schwartz por qué no revisaba mejor su trabajo.

Mientras Schwartz respondía las preguntas del juez, la reacción en la sala del tribunal, repleta de cerca de 70 personas que incluían abogados, estudiantes de derecho, asistentes legales y profesores, se extendió por los escaños. Hubo jadeos, risas y suspiros. Los espectadores hicieron muecas, miraron a su alrededor, masticaron bolígrafos.

“Seguí siendo engañado por ChatGPT. Es vergonzoso”, dijo Schwartz.

Un espectador dejó escapar un silbido suave y descendente.

El episodio, que surgió en una demanda por lo demás oscura, ha fascinado al mundo de la tecnología, donde ha habido un debate cada vez mayor sobre los peligros, incluso una amenaza existencial para la humanidad, que plantea la inteligencia artificial. También ha paralizado a abogados y jueces.

“Este caso ha repercutido en toda la profesión legal”, dijo David Lat, un comentarista legal. “Es un poco como mirar un accidente automovilístico”.

El caso involucró a un hombre llamado Roberto Mata, quien había demandado a la aerolínea Avianca alegando que resultó herido cuando un carrito de servicio de metal golpeó su rodilla durante un vuelo de agosto de 2019 de El Salvador a Nueva York.

Avianca le pidió al juez Castel que desestimara la demanda porque el plazo de prescripción había expirado. Los abogados del Sr. Mata respondieron con un escrito de 10 páginas citando más de media docena de decisiones judiciales, con nombres como Martínez contra Delta Air Lines, Zicherman contra Korean Air Lines y Varghese contra China Southern Airlines, en apoyo de su argumento de que se debe permitir que la demanda prosiga.

Después de que los abogados de Avianca no pudieran localizar los casos, el juez Castel ordenó a los abogados del Sr. Mata que proporcionaran copias. Presentaron un compendio de decisiones.

Resultó que los casos no eran reales.

Schwartz, que ha ejercido la abogacía en Nueva York durante 30 años, dijo en una declaración presentada ante el juez esta semana que se había enterado de ChatGPT por sus hijos en edad universitaria y por artículos, pero que nunca lo había usado profesionalmente.

Le dijo al juez Castel el jueves que creía que ChatGPT tenía un mayor alcance que las bases de datos estándar.

“Escuché sobre este nuevo sitio, que asumí falsamente que era como un súper motor de búsqueda”, dijo Schwartz.

Programas como ChatGPT y otros grandes modelos de lenguaje, de hecho, producen respuestas realistas al analizar qué fragmentos de texto deben seguir otras secuencias, según un modelo estadístico que ha ingerido miles de millones de ejemplos extraídos de Internet.

Irina Raicu, quien dirige el programa de ética en internet de la Universidad de Santa Clara, dijo esta semana que el caso Avianca mostró claramente lo que han estado diciendo los críticos de tales modelos, “que es que la gran mayoría de las personas que están jugando con ellos y usándolos no Realmente no entiendo qué son y cómo funcionan, y en particular cuáles son sus limitaciones”.

Rebecca Roiphe, profesora de la Facultad de Derecho de Nueva York que estudia la profesión legal, dijo que el embrollo ha alimentado una discusión sobre cómo se pueden incorporar los chatbots de manera responsable en la práctica del derecho.

“Este caso ha cambiado la urgencia del mismo”, dijo el profesor Roiphe. “Existe la sensación de que esto no es algo que podamos reflexionar de manera académica. Es algo que nos ha afectado en este momento y tiene que ser abordado..”

La publicidad mundial generada por el episodio debería servir como advertencia, dijo Stephen Gillers, profesor de ética en la Facultad de Derecho de la Universidad de Nueva York. “Paradójicamente, este evento tiene un lado positivo no deseado en forma de disuasión”, dijo.

No hubo esperanza en la sala 11-D el jueves. En un momento, el juez Castel interrogó al Sr. Schwartz sobre una de las opiniones falsas, leyendo unas pocas líneas en voz alta.

«¿Podemos estar de acuerdo en que eso es un galimatías legal?» Dijo el juez Castel.

Después de que Avianca trasladara el caso a la corte federal, donde el Sr. Schwartz no está autorizado para ejercer, el Sr. LoDuca, su socio en Levidow, Levidow & Oberman, se convirtió en el abogado de registro.

En una declaración jurada el mes pasado, el Sr. LoDuca le dijo al juez Castel que no tenía ningún papel en la realización de la investigación. El juez Castel interrogó al Sr. LoDuca el jueves sobre un documento presentado a su nombre que solicita que no se desestime la demanda.

“¿Leíste alguno de los casos citados?” preguntó el juez Castel.

“No”, respondió el Sr. LoDuca.

«¿Hiciste algo para asegurarte de que esos casos existieran?»

No otra vez.

Los abogados de Schwartz y LoDuca le pidieron al juez que no castigara a sus clientes, diciendo que los abogados habían asumido la responsabilidad y que no hubo mala conducta intencional.

En la declaración que el Sr. Schwartz presentó esta semana, describió cómo había planteado preguntas a ChatGPT, y cada vez pareció ayudar con citas de casos reales. Adjuntó una copia impresa de su coloquio con el bot, que lo muestra lanzando palabras como «seguro» y «¡ciertamente!»

Después de una respuesta, ChatGPT dijo alegremente: «¡Espero que eso ayude!»