En el centro de los proyectos modernos de IA se encuentran los sistemas basados en el aprendizaje por máquina que dependen de los datos para obtener su poder de predicción. Debido a esto, todos los proyectos de inteligencia artificial dependen de la alta calidad de los datos.

Sin embargo, la obtención y el mantenimiento de datos de alta calidad no siempre es fácil. Hay numerosos problemas de calidad de los datos que amenazan con descarrilar sus proyectos de inteligencia artificial y aprendizaje automático. En particular, estos nueve problemas de calidad de los datos deben ser considerados y prevenidos antes de que surjan los problemas.

1. Datos inexactos, incompletos y mal etiquetados

Los datos inexactos, incompletos o mal etiquetados suelen ser la causa del fracaso del proyecto de IA. Estos problemas de los datos pueden ir desde datos malos en la fuente hasta datos que no han sido limpiados o preparados adecuadamente. Los datos pueden estar en los campos incorrectos o tener etiquetas erróneas.

La limpieza de los datos es una cuestión tan importante que ha surgido toda una industria de preparación de datos para abordarla. Aunque parezca una tarea fácil limpiar gigabytes de datos, imagínese tener petabytes o zettabytes de datos para limpiar. Los enfoques tradicionales simplemente no se escalan, lo que ha dado lugar a nuevas herramientas impulsadas por la IA para ayudar a detectar y limpiar los problemas de los datos.

2. Tener demasiados datos

Como los datos son importantes para los proyectos de IA, es un pensamiento común que mientras más datos tengas, mejor. Sin embargo, cuando se utiliza el aprendizaje automático, a veces tirar demasiados datos a un modelo no ayuda. Por lo tanto, una cuestión contraria a la intuición sobre la calidad de los datos es tener demasiados datos.

Aunque parezca que demasiados datos nunca pueden ser algo malo, la mayoría de las veces, una buena parte de los datos no es utilizable o relevante. Tener que pasar a separar los datos útiles de este gran conjunto de datos desperdicia los recursos de la organización. Además, todos esos datos adicionales pueden dar lugar a un «ruido» de datos que puede hacer que los sistemas de aprendizaje automático aprendan de los matices y las variaciones de los datos en lugar de la tendencia general más significativa.

3. Tener muy pocos datos

Por otro lado, tener muy pocos datos presenta sus propios problemas. Si bien la capacitación de un modelo en un pequeño conjunto de datos puede producir resultados aceptables en un entorno de prueba, para llevar este modelo de la prueba de concepto o de la etapa piloto a la producción normalmente se requieren más datos. En general, los conjuntos de datos pequeños pueden producir resultados de baja complejidad, sesgados o demasiado ajustados, y no serán precisos cuando se trabaje con datos nuevos.

4. Datos sesgados

Además de los datos incorrectos, otra cuestión es que los datos podrían estar sesgados. Los datos podrían ser seleccionados de conjuntos de datos más grandes de manera que no transmitan adecuadamente el mensaje del conjunto de datos más amplio. De otras maneras, los datos podrían derivarse de información más antigua que podría haber sido el resultado de un sesgo humano. O tal vez haya algunos problemas con la forma en que se reúnen o generan los datos que dan lugar a un resultado final sesgado.

5. Datos desequilibrados

Aunque todo el mundo quiere tratar de minimizar o eliminar el sesgo de sus conjuntos de datos, esto es mucho más fácil de decir que de hacer. Hay varios factores que pueden entrar en juego cuando se abordan los datos sesgados. Un factor puede ser el desequilibrio de los datos. Los conjuntos de datos desequilibrados pueden obstaculizar significativamente el rendimiento de los modelos de aprendizaje automático. Los datos desequilibrados tienen una sobrerrepresentación de los datos de una comunidad o grupo, mientras que reducen innecesariamente la representación de otro grupo.

Un ejemplo de un conjunto de datos desequilibrado puede encontrarse en algunos enfoques de la detección del fraude. En general, la mayoría de las transacciones no son fraudulentas, lo que significa que sólo una parte muy pequeña de su conjunto de datos será fraudulenta. Dado que un modelo entrenado con estos datos fraudulentos puede recibir muchos más ejemplos de una clase que de otra, los resultados estarán sesgados hacia la clase con más ejemplos. Por eso es esencial realizar un análisis exploratorio exhaustivo de los datos para descubrir esos problemas con antelación y considerar soluciones que puedan ayudar a equilibrar los conjuntos de datos.

6. Silos de datos

Relacionado con el tema de los datos desequilibrados está el tema de los silos de datos. Un silo de datos es cuando sólo un cierto grupo o un número limitado de personas de una organización tiene acceso a un conjunto de datos. Los silos de datos pueden ser el resultado de varios factores, entre ellos las dificultades técnicas o las restricciones en la integración de los conjuntos de datos, así como cuestiones relacionadas con el control de acceso a los datos por motivos de propiedad o de seguridad.

También son el producto de averías estructurales en organizaciones en las que sólo ciertos grupos tienen acceso a determinados datos, así como de cuestiones culturales en las que la falta de colaboración entre los departamentos impide el intercambio de datos. Independientemente de la razón, los silos de datos pueden limitar la capacidad de quienes trabajan en una empresa en proyectos de inteligencia artificial para tener acceso a conjuntos de datos completos, lo que posiblemente disminuya la calidad de los resultados.

7. 7. Datos inconsistentes

No todos los datos se crean de la misma manera. Sólo porque estés recopilando información, no significa que pueda o deba ser utilizada siempre. Relacionado con la recolección de demasiados datos está el desafío de recolectar datos irrelevantes para ser usados en el entrenamiento. Entrenar el modelo sobre datos limpios pero irrelevantes resulta en los mismos problemas que los sistemas de entrenamiento sobre datos de baja calidad.

Junto con el concepto de datos irrelevantes son datos inconsistentes. En muchas circunstancias, los mismos registros pueden existir varias veces en diferentes conjuntos de datos pero con valores diferentes, lo que da lugar a incoherencias. La duplicación de datos es uno de los mayores problemas para las empresas que manejan datos. Cuando se trata de múltiples fuentes de datos, la incoherencia es un gran indicador de un problema de calidad de los datos.

8. La escasez de datos

Otra cuestión es la escasez de datos. La escasez de datos se da cuando faltan datos o cuando hay una cantidad insuficiente de valores esperados específicos en un conjunto de datos. La escasez de datos puede cambiar el rendimiento de los algoritmos de aprendizaje de las máquinas y su capacidad para calcular predicciones precisas. Si no se identifica la escasez de datos, puede dar lugar a que los modelos se entrenen con datos ruidosos o insuficientes, lo que reduce la eficacia o la precisión de los resultados.

9. 9. Cuestiones de etiquetado de datos

Los modelos de aprendizaje automático supervisado, uno de los tipos fundamentales de aprendizaje automático, requieren que los datos se etiqueten con los metadatos correctos para que las máquinas sean capaces de derivar conocimientos. El etiquetado de los datos es una tarea difícil, que a menudo requiere que los recursos humanos pongan metadatos en una amplia gama de tipos de datos. Esto puede ser tanto complejo como costoso. Uno de los mayores problemas de calidad de los datos que actualmente desafían los proyectos internos de IA es la falta de etiquetado adecuado de los datos de entrenamiento de aprendizaje de las máquinas. El etiquetado exacto de los datos asegura que los sistemas de aprendizaje automático establezcan modelos fiables para el reconocimiento de patrones, formando los cimientos de cada proyecto de IA. La buena calidad de los datos etiquetados es primordial para entrenar con precisión el sistema de IA sobre qué datos se están alimentando.

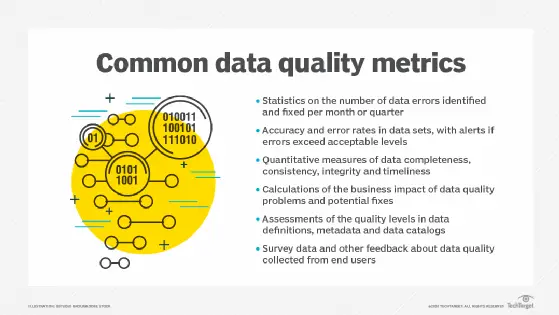

Las organizaciones que buscan implementar proyectos exitosos de IA deben prestar atención a la calidad de sus datos. Si bien las razones de los problemas de calidad de los datos son muchas, un tema común que las empresas deben recordar es que para tener los datos en las mejores condiciones posibles, la gestión adecuada es clave. Es importante vigilar los datos que se están recopilando, realizar comprobaciones regulares de estos datos, mantenerlos lo más precisos posible y obtener los datos en el formato adecuado antes de que los modelos de aprendizaje automático aprendan sobre estos datos. Si las empresas son capaces de mantenerse al tanto de sus datos, es menos probable que surjan problemas de calidad.