Hace años, la construcción de modelos financieros para los bancos era exhaustiva – esto fue cuando las características del modelo fueron hechas a mano y aprobadas por los comités de dirección. Estos eran días de aprendizaje pre-profundo, donde la IA no estaba a la vista. Como las características eran manuales, los controles de calidad de los datos eran la norma. Los analistas y asociados a cargo de las auditorías regulares notaron como los datos fluían de un sistema a otro – muchas veces era «Basura dentro, basura fuera».

La calidad de los datos en ese entonces era un gran problema – la naturaleza de los problemas de calidad de los datos difieren a través de los tipos de datos como imágenes/video, audio, texto. Siempre habría ese duplicado, atípico, datos faltantes, texto corrupto o errores de escritura. Pero incluso después de años de avances en la ingeniería de datos y la «inteligencia artificial», la calidad de los datos, particularmente los datos tabulares estructurados, sigue siendo un gran problema. De hecho, es un problema creciente. Pero también es por eso que es un problema emocionante de resolver.

Por qué la calidad de los datos es un problema creciente

Más decisiones se basan en datos

El crecimiento de las herramientas de BI como Tableau, las herramientas de inteligencia de mercado como AppAnnie, y las herramientas de pruebas A/B como Optimizely, todas ellas apuntan a la tendencia de las decisiones basadas en datos. Estas herramientas son inútiles si no se puede confiar en los datos subyacentes. Perdemos la confianza en estas herramientas rápidamente si siguen apareciendo problemas de calidad de datos. Se toman malas decisiones y se pierden oportunidades de negocio. Gartner estudia regularmente el coste de los datos erróneos y durante años se mantiene en >10 millones de dólares por empresa, incluso después de gastar 200.000 dólares anuales en herramientas de calidad de datos.

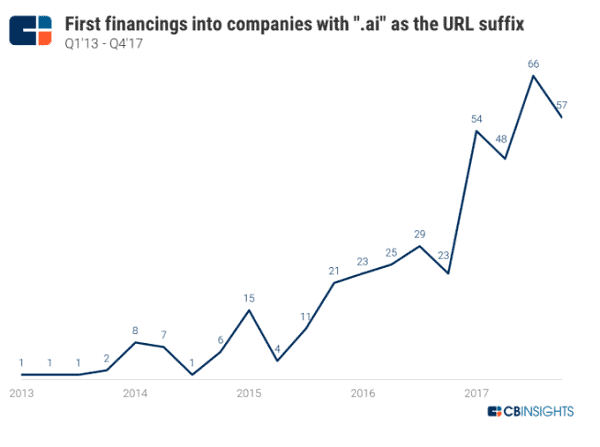

Más empresas se construyen sobre datos

Las olas de empresas de aprendizaje de máquinas se construyen con datos. Si has hablado con ingenieros de aprendizaje de máquinas y científicos de datos, siempre oirás lo importante que son los buenos datos.

Por qué la calidad de los datos sigue siendo un problema

Muchos datos, pero las comprobaciones estáticas de una sola vez siguen siendo el status quo

La nube cambió la mentalidad de almacenar sólo datos útiles a almacenar todos los datos potencialmente útiles. Las tecnologías de flujo como Kafka y los almacenes de datos de la nube como Snowflake disminuyen la fricción para almacenar más datos – a mayor velocidad, mayor variedad y mayor volumen. Para asegurar la calidad, las reglas de datos que especifican el rango y el esquema son escritas manualmente por consultores o analistas de calidad de datos. Se trata de un proceso costoso que requiere mucho tiempo y que por lo general se realiza una sola vez. Hay dos problemas con esto. El primero es que la mayoría de las reglas se aprenden en la producción, cuando surge un problema. Un caso de incógnitas desconocidas. El segundo es que los datos son dinámicos, lo que requiere que las reglas sean dinámicas.

Las fuentes de datos «fiables» siguen siendo problemáticas

Tres sectores tienen en mente la calidad de los datos más que cualquier otro: el sector público, la salud y los servicios financieros. Pero estas industrias siguen estando plagadas de malos datos. El líder de gobierno de datos de una compañía de salud dijo una vez que los datos del gobierno que reciben mensualmente están llenos de errores. Imagina, estamos siendo gobernados en base a datos sucios y necesitamos personal dedicado a limpiarlos.

Especialización de los profesionales de los datos

Solía ser que los profesionales de los datos cubrían más de la gama de ingerir datos, transformarlos, limpiarlos y analizarlos/consultarlos. Ahora tenemos diferentes profesionales abordando cada paso. Los ingenieros de datos se encargan de la ingestión y la transformación. A veces la transformación se salta y los datos se empujan directamente a los almacenes de datos para ser transformados más tarde. Los científicos de datos construyen modelos y están ocupados afinando las perillas de aprendizaje profundo para mejorar la precisión. Y los analistas de negocios consultan y escriben informes. Tienen más contexto de cómo deberían ser los datos, pero están separados de los ingenieros de datos que escriben e implementan controles de calidad de los datos.

Una gran oportunidad para agarrar

El mercado actual de software de calidad de datos es de casi 2.000 millones de dólares. Pero la verdadera oportunidad es mucho mayor, con 4.500 millones de dólares, ya que hay un gran componente de mano de obra que puede ser automatizado. Hay 21.000 puestos de trabajo de calidad de datos en los EE.UU., cada uno de los cuales paga 80.000 dólares anuales. Esto no captura a los que trabajan en empresas de servicios profesionales que tienen «consultores» como títulos de trabajo. Asumiendo que esto multiplica el componente de mano de obra directa por 1.5x, el componente de mano de obra total es de $2.5B. El mercado continuará creciendo saludablemente a medida que la calidad de los datos sea más importante en las aplicaciones de ML y en las decisiones de negocios.

Mientras que Informatica, SAP, Experian, Syncsort y Talend dominan actualmente el mercado, una nueva ola de startups se está apuntalando. Los productos actuales y la forma en que se venden pueden ser mucho mejores: desde ser una solución llave en mano conectada a cualquier parte del pipeline de datos, hasta no requerir un período de implementación de 6 meses y compromisos iniciales de 6 cifras, pasando por la automatización de la redacción de reglas de calidad de datos y la supervisión.

Sobre el autor

Kenn So es un inversor en Shasta Ventures. Kenn es un apasionado del potencial de la inteligencia artificial (IA). Mientras obtenía su MBA en la Escuela de Administración Kellogg, Kenn comenzó el Club de Inteligencia Artificial para ayudar a los estudiantes a entender cómo la IA está cambiando el panorama de los negocios. También dirigió hackathons y noches de campo para salvar la brecha entre los estudiantes de ingeniería y los de negocios. Kenn está entusiasmado por ver y trabajar con compañías que están construyendo productos de software inteligentes que aprovechan la IA. Kenn creció en Filipinas y vivió en toda Asia. Se crió en una familia de restauradores y es aficionado a los restaurantes familiares.

Suscríbete al boletín de noticias gratuito de InsideBIGDATA.